给机器人装上「虫脑」?非Transformer液态神经网络终于来了!MIT CSAIL负责人创业成果

文章摘要

【关 键 词】 AI模型、多模态、Transformer、内存优化、技术发布

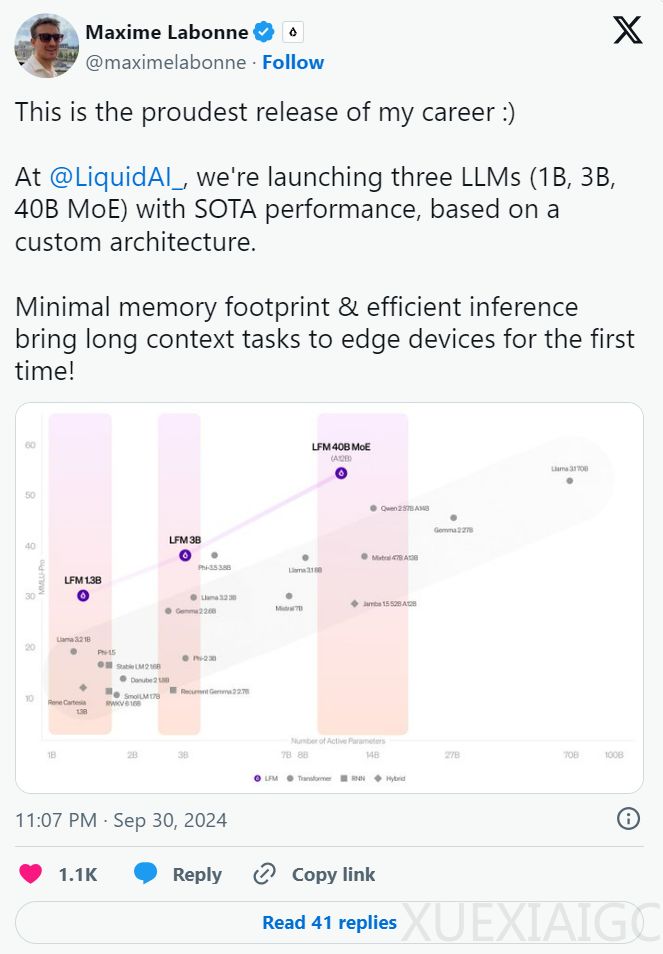

Liquid AI是一家专注于开发新型人工智能模型的初创公司,由MIT计算机科学与人工智能实验室(CSAIL)的前研究人员创立。该公司旨在超越现有的生成式预训练Transformer(GPT)模型,推出了名为Liquid Foundation Models(LFM)的多模态AI模型系列。这些模型基于第一原理构建,具有1B、3B和40B三种不同规模,均能实现最先进的性能(SOTA),同时占用更少的内存和更高效的推理能力。

LFM系列包括三种变体:1.3B、3B和40.3B MoE模型,分别适用于资源受限环境、边缘部署优化和处理复杂任务。这些模型在基准测试中的表现超过了同等规模的Transformer模型,如Meta的Llama和微软的Phi。LFM-1B在第三方基准测试中取得了最高分,标志着非GPT架构首次显著优于基于Transformer的模型。

与Transformer架构相比,LFM在内存使用上更为高效,尤其是在处理长输入时。LFM能够高效压缩输入,处理更长的序列,且占用的内存更少。例如,LFM-3B仅需要16GB内存,而Meta的Llama-3.2-3B则需要超过48GB内存。

LFM还充分利用了上下文长度,首次在边缘设备上实现了长上下文任务,为开发者解锁了新的应用场景,如文档分析、摘要、上下文感知聊天机器人和改进的检索增强生成(RAG)性能。

Liquid AI的模型超越了传统的生成式预训练Transformer(GPT)模型,采用了一种混合的计算单元,这些单元基于动态系统理论、信号处理和数值线性代数。这种方法允许模型在推理过程中进行实时调整,而不会带来传统模型相关的计算开销。此外,Liquid AI的模型保留了适应性的核心优势,可以高效处理多达100万个token,同时将内存使用量降至最低。

Liquid AI的创始人之一,MIT CSAIL主任Daniela Rus,指出生成式AI在安全、可解释性以及算力等方面存在局限性,难以应用于解决机器人问题,尤其是移动机器人。受秀丽隐杆线虫的神经结构启发,Rus和她的团队研发出了一种新型的灵活神经网络,即液态神经网络。这种网络由多个简单的动态系统组成,通过非线性门相互调节,具有时间常数可变的特点,输出通过求解微分方程得到。研究表明,这种网络在稳定性、表达能力和时间序列预测方面都优于传统模型。

Liquid AI的模型已被优化,以适应NVIDIA、AMD、Apple、Qualcomm和Cerebras等多家硬件制造商的产品。公司正在邀请早期用户和开发者测试他们的新模型并提供反馈,计划利用这些反馈来改进产品。他们计划在2024年10月23日在麻省理工学院举行正式发布会,并在此之前发表一系列技术博客文章。

Liquid AI的LFM结合了高性能和高效的内存使用,为传统的基于Transformer的模型提供了一个有力的替代选择,有望成为基础模型领域的重要玩家。

原文和模型

【原文链接】 阅读原文 [ 2888字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★