文章摘要

【关 键 词】 AI发展、AlphaGo、ChatGPT、DeepSeek、强化学习

文章围绕AI发展历程,从AlphaGo到ChatGPT,再到DeepSeek R1,阐述了AI底层原理的突破及其对AGI/ASI的重要性。

1. AlphaGo突破人类上限:1997年深蓝击败国际象棋冠军,2016年AlphaGo击败围棋冠军。围棋复杂度远超国际象棋,AlphaGo放弃暴力搜索,采用深度学习和强化学习,自我对弈超越人类。但围棋规则明确,强化学习在现实开放空间应用受限,AI领域随后陷入冷寂。

2. ChatGPT改变世界:ChatGPT将互联网文本数据压缩进模型,通过预测下一个字产生智能。经预训练、监督微调、基于人类反馈的强化学习(RLHF)三个阶段训练,使其学会问答并符合人类偏好。

3. 大模型发展困境:人类数据消耗殆尽,预训练因数据不足“撞墙”;RLHF依赖人类评估,随着模型智商超越人类,难以帮助模型突破人类思维枷锁。

4. OpenAI的解法:提出使用强化学习训练模型思维链,诞生Reasoning模型,如OpenAI的o1、o3,训练中人类反馈不再重要。

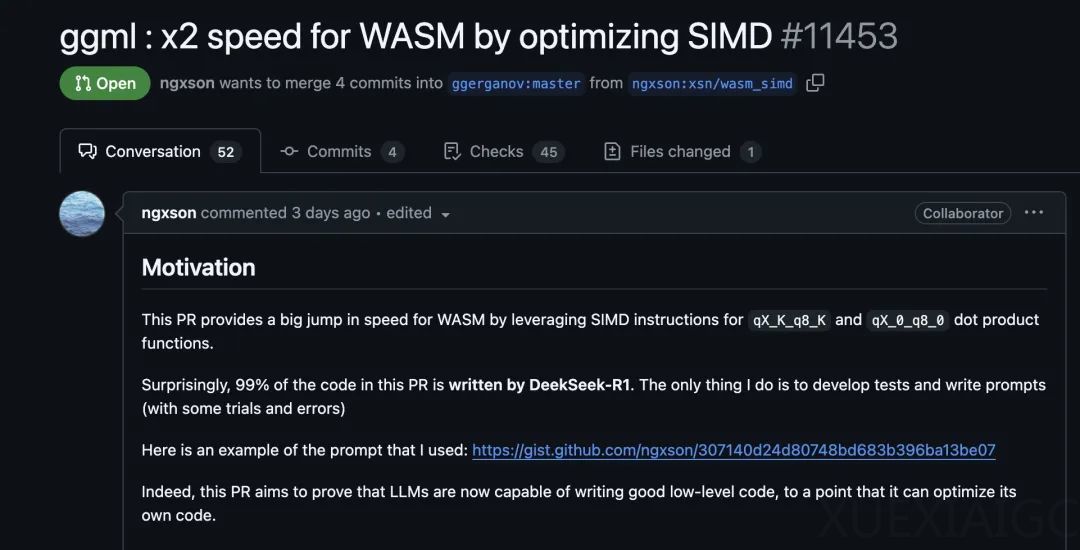

5. DeepSeek R1的突破:DeepSeek R1 – Zero致敬AlphaZero,在数学和代码数据上用GRPO算法强化学习,激发推理能力。经多阶段训练得到DeepSeek R1,开源比肩闭源o1的Reasoning模型,揭示纯RL可训练最强推理模型。

6. 对齐人类品味与超越人类:将模型对齐人类品味可避开激烈竞争,但难以量化效果且无法超越人类;对齐客观真理虽痛苦,但有超越人类的可能。

7. 反驳质疑:R1推理能力超越非Reasoning模型,接近o1,逊色于o3;不收集用户聊天内容训练;性能提升源于强化学习,并非蒸馏OpenAI模型;大模型不知自身训练信息,被误判为套壳不合理。

8. 感受:DeepSeek R1 – Zero摆脱人类反馈枷锁,让人们看到模型超越人类的可能;AI在代码领域表现出色,拓展了人类能力边界。

原文和模型

【原文链接】 阅读原文 [ 5519字 | 23分钟 ]

【原文作者】 波斯兔子

【摘要模型】 doubao-1.5-pro-32k

【摘要评分】 ★☆☆☆☆