Video Depth Anything来了!字节开源首款10分钟级长视频深度估计模型,性能SOTA

文章摘要

【关 键 词】 深度估计、视频应用、时序稳定、效率优化、实时场景

字节跳动智能创作AR团队与豆包大模型团队联合开发的Video Depth Anything(VDA)模型,针对单目深度估计在视频领域的应用难题取得了突破。VDA基于Depth Anything V2,通过融合时空头、时域一致性损失函数和基于关键帧的长视频推理策略,实现了对10分钟级视频的深度估计。该模型在不牺牲泛化能力、细节生成能力和计算效率的前提下,实现了时序稳定的深度估计,无需复杂视频生成先验知识,为单目深度估计在视频领域应用提供了新解决方案。

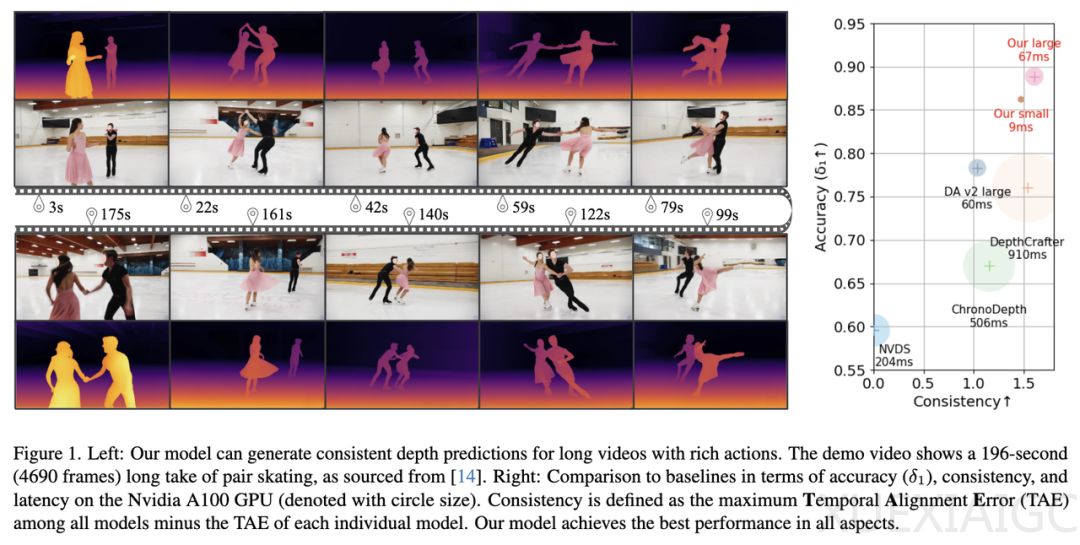

VDA在视频数据集的精度和稳定性指标上均取得SOTA,精度提升超过10个百分点,推理速度远超此前同类模型,速度是此前最高精度模型的10倍以上。在V100下,较小版本VDA模型推理速度可达30FPS。目前,该论文成果和代码仓库均已对外公开,项目上线数天已收获300+Stars,X原贴阅读量超过2万。

VDA模型设计兼顾预测精度与效率。从单图深度模型到视频深度模型,VDA使用训好的Depth Anything V2模型作为编码器,并设计了一个轻量级时空头,包含四个时间注意力层。为了约束时序一致性,VDA提出时序梯度匹配损失,直接使用相邻帧中相同坐标深度来计算损失。为了处理任意视频长度,VDA提出关键帧对齐和重叠区域插值方法,以对齐全局尺度和偏移,并确保局部窗口之间的平滑推理。

实验结果表明,VDA在6个包含室内外场景的Benchmark上,从几何精度、时序稳定性、耗时三个方面和学界SOTA方案进行对比,长视频Benchmark精度和时序稳定性误差均为最优。VDA模型耗时远小于其他视频深度模型,即使相比单帧模型Depth Anything V2,耗时也只增加约10%。DVA-S模型单帧推理时间仅9.1ms,面向实时性要求较高的场景,具有较大应用潜力。

此外,豆包大模型团队与浙江大学合作开源了Prompt Depth Anything技术,实现了4K分辨率下的高精绝对深度估计。该方法通过以iPhone LiDAR传感器采集的24×24绝对深度作为提示,促使模型最多可输出3840×2160同精度级别的绝对深度。该成果具备广泛的下游应用空间,如3D重建、自动驾驶、机器人抓取任务等。

原文和模型

【原文链接】 阅读原文 [ 2056字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★