Sebastian Raschka最新博客:从头开始,用Llama 2构建Llama 3.2

文章摘要

【关 键 词】 Meta Connect、轻量级模型、多语言文本、个性化应用、隐私保护

在 Meta Connect 2024 大会上,Meta 公司推出了两款新型轻量级模型 Llama 3.2 1B 和 3B,它们专为边缘和移动设备设计,能够在设备上本地运行,保护用户隐私。这些纯文本模型支持多语言文本生成和工具调用,为开发者提供了构建个性化应用的新工具。

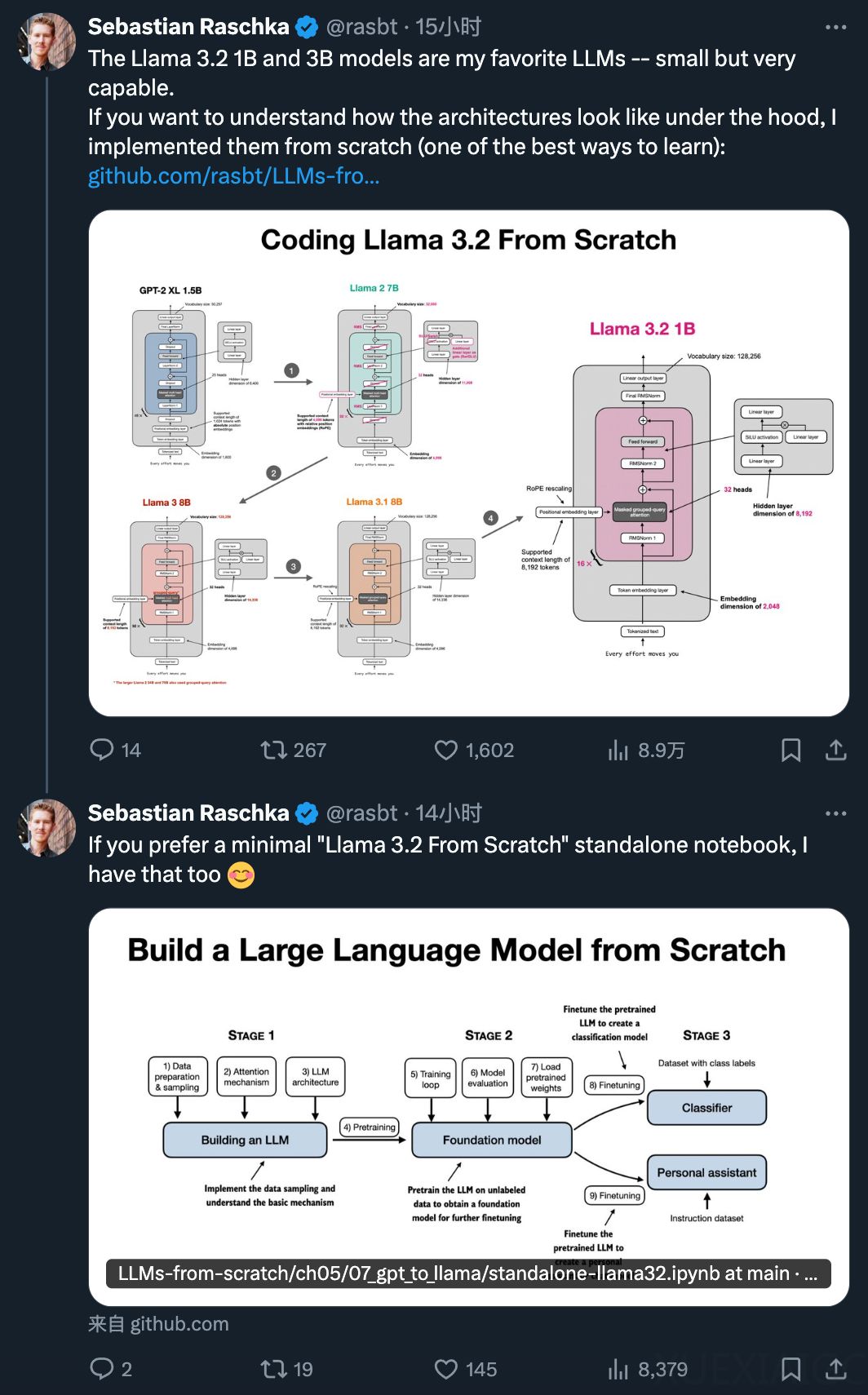

为了帮助开发者和研究人员更好地理解和使用这些模型,机器学习研究员 Sebastian Raschka 发布了一篇名为《Converting Llama 2 to Llama 3.2 From Scratch》的教程。这篇教程是之前《Converting a From-Scratch GPT Architecture to Llama 2》的续篇,专注于将 Meta 的 Llama 2 模型逐步升级到 Llama 3、Llama 3.1 和 Llama 3.2。教程内容简洁,重点放在代码实现上。

转换过程包括几个关键步骤:

1. 复用 Llama 2 的组件:Llama 2 与 Llama 3 架构非常相似,因此可以复用 Llama 2 的一些构建模块,如 RMSNorm 层、SiLU 和 SwiGLU 激活、RoPE(旋转位置嵌入)和 SentencePiece tokenizer。

2. 修改旋转嵌入:Llama 3 的 RoPE 与 Llama 2 类似,但支持的 token 数量翻倍,从 4096 增加到 8192。此外,RoPE 的基础值从 10000 增加到 50000,这改变了旋转矩阵中旋转角度的计算方式。

3. 实现分组查询注意力:Llama 3 引入了分组查询注意力(GQA),这是一种计算和参数效率更高的多头注意力(MHA)替代方案。GQA 通过在多个注意力头之间共享键和值投影来减少参数数量,同时保持每个头有其独特的查询。

4. 使用定制版的 GPT-4 tokenizer:Llama 3 还采用了定制版的 GPT-4 tokenizer,以提高模型的性能和效率。

通过这些改进,Llama 3 模型在保持轻量级的同时,提供了更强的文本生成能力和更高的隐私保护。开发者现在可以利用这些新功能,为用户打造更加个性化和安全的本地应用体验。

原文和模型

【原文链接】 阅读原文 [ 5374字 | 22分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆