文章摘要

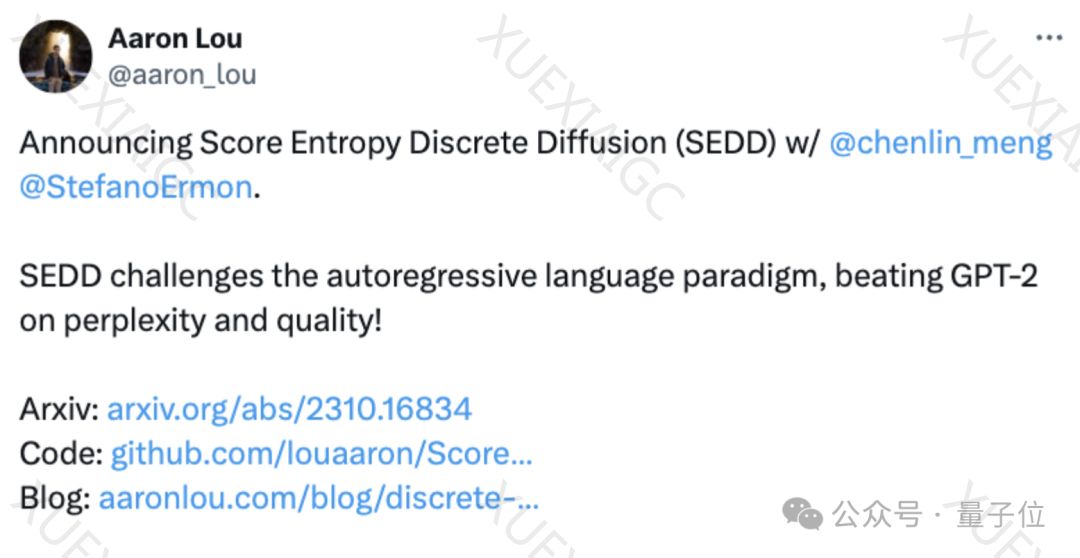

这篇文章介绍了生成式AI领域中的两个主导模型:自回归模型和扩散模型。自回归模型专注于处理离散数据,如文本,通过预测下一个token来生成文本。然而,作者指出自回归模型存在一些缺陷,如生成偏离数据分布、计算梯度困难等。为了克服这些问题,作者提出了一种新的模型——分数熵离散扩散模型(SEDD),旨在将扩散模型扩展到离散空间。SEDD模型通过学习具体得分和迭代去噪来生成文本,相比自回归模型,SEDD能够更好地利用全局上下文,提高生成效果。在实验中,SEDD表现出了强大的竞争力,包括在困惑度指标上的表现和控制生成质量上的优势。此外,SEDD还能够与GPT-2等自回归模型进行比较,并在零样本生成任务中展现出优势。研究团队由斯坦福大学的博士生Aaron Lou和Chenlin Meng以及导师Stefano Ermon组成。文章最后提供了论文链接,详细介绍了SEDD模型的原理和实验结果。

原文和模型

【原文链接】 阅读原文 [ 1400字 | 6分钟 ]

【原文作者】 量子位

【摘要模型】 gpt-3.5-turbo-0125

【摘要评分】 ★☆☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...