文章摘要

【关 键 词】 GPT-4o模型、法律纠纷、安全问题、技术挑战、RTC技术

OpenAI的GPT-4o模型虽然在5月14日的发布会上展示了出色的实时音视频对话能力,但至今仍未公开发布。推迟的原因包括法律纠纷、安全问题以及技术挑战。法律纠纷主要涉及语音音色的版权问题,而安全问题则需要确保对话模式不会被用于诈骗等不当用途。技术挑战则包括实现低延迟、多设备适配、应对多种网络条件和嘈杂环境等。

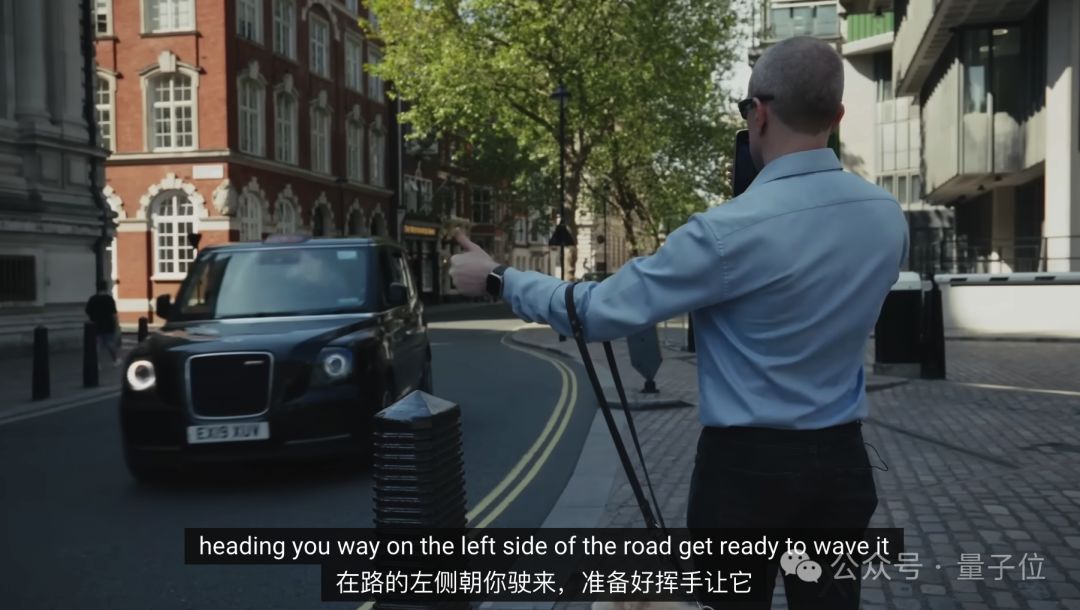

GPT-4o的发布会演示效果虽然令人印象深刻,但存在一些限制,如需要固定网络、设备和物理环境。此外,视频通话部分的延迟问题也显而易见。对于室外场景,网络信号不稳定和噪音问题可能会影响AI的语音识别和回答。多设备适配也是一个挑战,目前OpenAI主要使用新款iPhone Pro进行演示,但是否能在低端机型上获得一致体验还有待观察。

为了实现低延迟和多设备适配,RTC(实时通信)技术至关重要。RTC技术在AI时代之前已广泛应用于直播、视频会议等场景。RTC技术涉及信号采集与预处理、语音编码与压缩、网络传输、语音解码与还原等多个环节。每个环节都需要极致优化,才能实现实时音视频对话。

OpenAI选择与开源RTC厂商LiveKit合作,以解决RTC技术问题。LiveKit也与其他AI公司如Character.ai、ElevenLabs等展开合作。国内AI公司也在加紧研发端到端多模态大模型和AI实时音视频对话应用。声网作为RTC行业的代表性企业,已与多家AI公司合作,其技术水平已能将一轮对话的延迟压到1秒左右。

声网首席科学家、CTO钟声介绍了声网在优化RTC技术方面的三个主要方向:全球数据中心布局、智能路由技术和弱网场景优化。声网还尝试定制参数量更小的模型,以优化对话式AI的性价比和低延迟体验。此外,声网开发的RTC SDK也针对不同终端设备进行适配与优化。

钟声认为,AI与RTC技术结合的最终形态将走向端云结合,即不能完全依赖云端的大模型。端云结合模式下,整个基础设施将发生变化,算力不仅在云端,手机的算力也会被用上。声网与大模型应用厂商已摸索出三种合作模式:私有化部署、声网云平台和声网端到端解决方案。

国内AI应用正在超越AI助手问答与AI情感陪伴的范畴,逐渐应用于社交娱乐、电商直播和在线教育等行业。AI实时音视频对话驱动的数字人可以成为网红主播和名师的“数字分身”,与粉丝或学生进行一对一交流互动。随着技术的发展和成本的下降,AI分身技术的应用范围将日益扩大。

原文和模型

【原文链接】 阅读原文 [ 3187字 | 13分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★