文章摘要

【关 键 词】 Andrej Karpathy、GPT、C语言、深度学习、编程教程

Andrej Karpathy

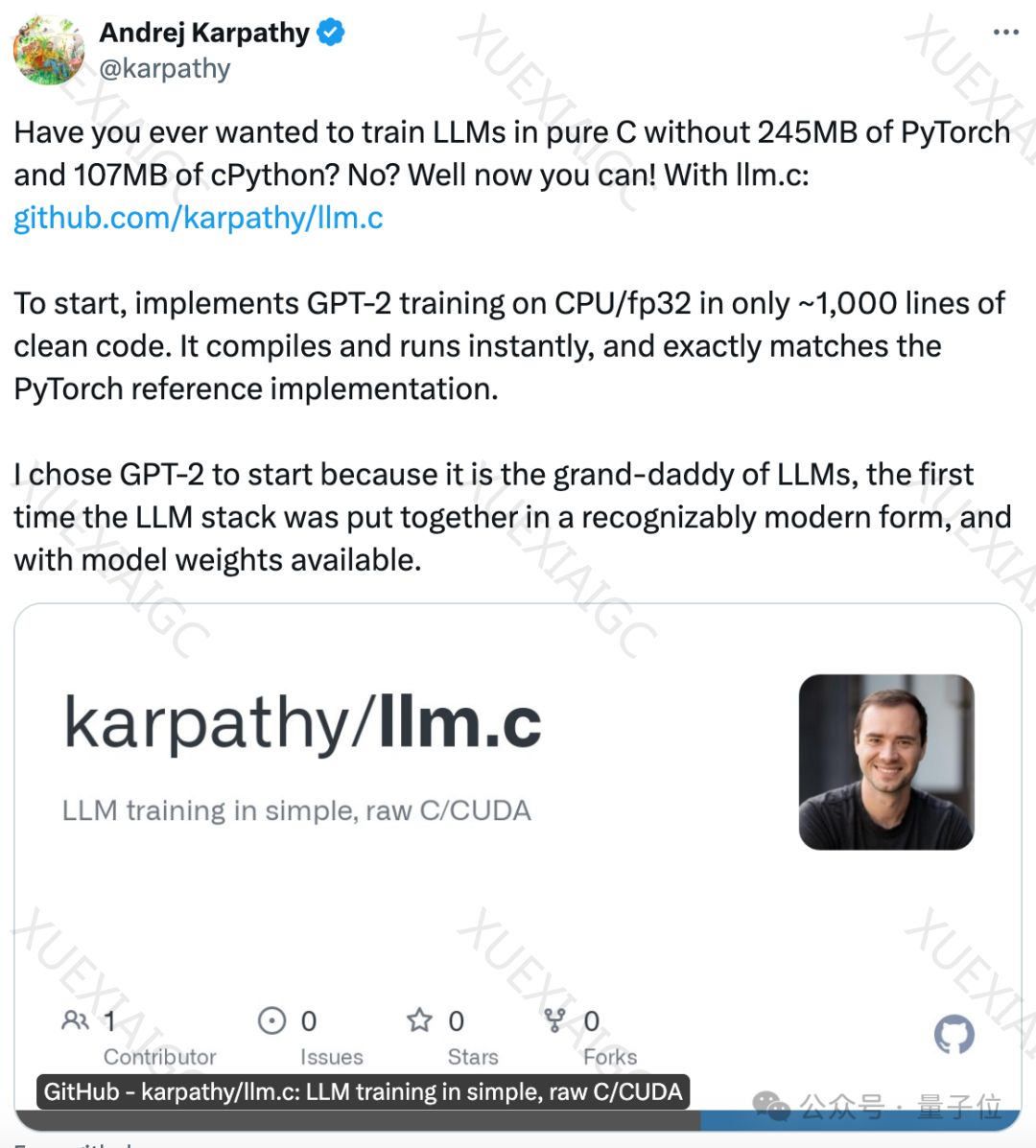

Andrej Karpathy,一位在人工智能领域享有盛誉的大神,近期复出并带来了一项引人注目的项目:使用纯C语言实现GPT的训练,仅用1000行代码就完成了这一壮举。这个项目不依赖任何现成的深度学习框架,完全是手工打造,且能够与PyTorch框架完全兼容。发布后不久,该项目在GitHub上迅速获得了2.3k的星标。

项目亮点

Karpathy选择了GPT-2作为示例,因为它具有现成的模型权重,并采用了堆栈式的Transformer模型结构。他的项目的核心亮点包括:直接在C/CUDA上训练大型语言模型(LLM),速度接近PyTorch;通过使用SIMD指令(如AVX2和NEON)来加速CPU版本;支持更先进的架构,如Llama2和Gemma。

手动实现

在项目中,Karpathy手动实现了每个层的前向传播和反向传播,并将它们串联起来。这一过程非常繁琐且充满挑战,因为需要确保所有的指针和张量都正确排列。他还展示了如何在一个单一的一维内存数组中分配所有模型权重和激活函数,并进行精确的指针计算。

未来计划

Karpathy还提到,他正在将代码逐层移植到CUDA上,以提高效率,甚至可能达到与PyTorch相似的水平,同时减少依赖。他还计划在未来的视频中提供更详细的解释,并在GitHub项目页上展示更多的代码。此外,他还添加了一个从PyTorch迁移到C的教程。

社区反应

网友们对这个项目的反应不一,有人好奇为什么不使用Rust语言,对此Karpathy表示他认为C语言已经足够好。还有人质疑AI程序员是否能够复制这样的项目,Karpathy给出了一些提示词,鼓励大家尝试使用LLM Agent来挑战。

LLM OS

有讨论指出这个项目可能与Karpathy计划中的LLM OS有关。Karpathy曾在OpenAI离职后表示要推进个人项目,而LLM OS被认为是他的目标之一。他将LLM OS比作一个操作系统,将各种模态(如文本、图像、音频等)作为外围设备连接到一个新的CPU上,即语言模型本身,并与现有的Software 1.0基础设施相连。

期待

随着Karpathy个人项目的推进,社区对他的后续工作充满期待。更多关于LLM.C的项目信息和视频讲解将会陆续推出,值得关注。项目的GitHub地址也已提供,供有兴趣的开发者和研究者探索和学习。

原文和模型

【原文链接】 阅读原文 [ 1258字 | 6分钟 ]

【原文作者】 量子位

【摘要模型】 gpt-4

【摘要评分】 ★★★☆☆