OpenAI停服,国产大模型免费用!开发者Token自由实现了

文章摘要

【关 键 词】 AI服务、开源模型、云平台、成本优化、开发者支持

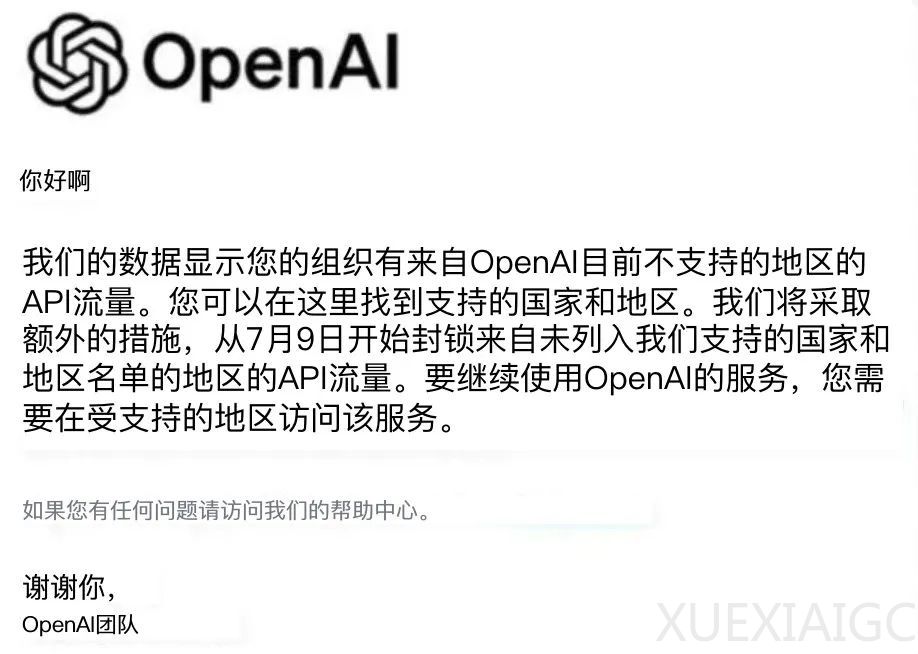

OpenAI 近期决定停止对中国提供 API 服务,限制了国内开发者对 GPT 等高级大模型的访问。然而,开源大模型的快速发展为开发者提供了多种替代选择,如 Qwen2、DeepSeek V2 等。硅基流动(SiliconFlow)作为 AI Infra 领域的专业公司,推出了一站式大模型 API 平台 SiliconCloud,为开发者提供快速、经济、全面的服务体验。

硅基流动为国内开发者提供了一份大礼,包括 Qwen2 (7B)、GLM4 (9B)、Yi1.5(9B)等顶尖开源大模型的永久免费使用。这标志着开发者可以自由地开发超级应用,不再受限于 Token 的成本。SiliconCloud 作为一个 Token 生产工厂,通过云服务接入大模型 API,满足开发者对模型响应速度、用户体验和成本的需求。

SiliconCloud 聚合了多个开源大模型,包括 DeepSeek-Coder-V2、Qwen2、GLM-4-9B-Chat、DeepSeek V2 系列模型,以及 Stable Diffusion 3 Medium、InstantID 等文生图模型。特别值得一提的是,对于部署难度高的模型如 DeepSeek V2,SiliconCloud 是除官方外唯一支持这些模型的云服务平台。开发者可以在 SiliconCloud 上自由切换不同的大模型,以适应不同的应用场景。

硅基流动致力于将大模型部署成本降低 10000 倍,核心挑战在于提升大模型推理速度。SiliconCloud 通过性能优化,实现了在某些场景下大模型吞吐量的 10 倍加速。例如,Qwen2-72B-Instruct 在 SiliconCloud 上的响应速度得到了显著提升,SD3 Medium 的生图时间缩短至约 1 秒。这些优化使得相同的算力产出更高,从而降低了成本。

SiliconCloud 上的大模型 API 价格亲民,即使是 Qwen2-72B,官网价格也只需 4.13 元 / 1M Token。新用户还可以免费享受 2000 万 Token。开发者对 SiliconCloud 的速度和性能给予了高度评价,认为其输出速度远超其他大模型厂商。

硅基流动团队在 AI 基础设施及加速优化方面拥有丰富的经验,早在 2016 年就投身于大模型基础设施的研发。他们基于这些经验,率先研发了高性能大模型推理引擎,并将其集成到 SiliconCloud 平台,为开发者提供了快速、价格实在的大模型服务。

随着国产开源大模型的不断迭代,以 Qwen2、DeepSeek V2 为代表的模型已足够支持超级应用。SiliconCloud 的出现解决了开发者在应用研发和大规模推广过程中的算力成本问题,使他们可以专注于实现产品想法,开发用户所需的生成式 AI 应用。现在,超级个体开发者和产品经理迎来了最佳“掘金”时刻,而 SiliconCloud 这个好用的工具已经为他们准备好了。

最后,硅基流动再次强调 Qwen2 (7B)、GLM4 (9B) 等顶尖开源大模型在 SiliconCloud 上的永久免费使用,欢迎开发者走进 Token 工厂 SiliconCloud,体验高速、经济的大模型服务。

原文和模型

【原文链接】 阅读原文 [ 1897字 | 8分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆