Meta推出Llama 4:MoE构架、原生多模态、10M上下文,没有发布推理模型

文章摘要

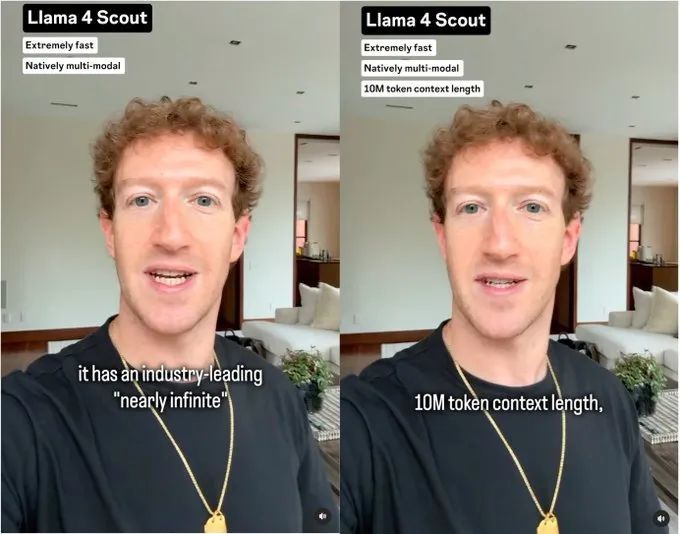

Meta 创始人兼首席执行官马克·扎克伯格宣布推出全新 Llama 4 系列模型,包括两款即时可用的模型——Llama 4 Maverick 和 Llama 4 Scout,以及一款仍在训练中的巨无霸模型 Llama 4 Behemoth。Llama 4 系列采用了混合专家(MoE)架构,并且是原生多模态训练,标志着对 Llama 系列的彻底重新设计。Llama 4 Maverick 和 Llama 4 Scout 分别支持 100 万和 1000 万 token 的上下文窗口,能够处理大量文本,适用于医学、科学、工程等知识密集型领域。Meta 估计 Llama 4 Maverick 的推理成本为每 100 万 token 0.19 至 0.49 美元,远低于 GPT-4o 的 4.38 美元。

Llama 4 Scout 定位为性能最强的小尺寸模型,拥有 109B 参数,支持 1000 万+ token 的多模态上下文窗口,并且能在单张 H100 GPU 上运行。Llama 4 Maverick 则在多个主流基准测试中击败了 GPT-4o 和 Gemini 2.0 Flash,推理和编码能力与新发布的 DeepSeek v3 相当,但激活参数量不到后者一半。Llama 4 Behemoth 是 Meta 迄今最强模型,拥有 2 万亿参数,在多个 STEM 基准上优于 GPT-4.5、Claude Sonnet 3.7 和 Gemini 2.0 Pro。

Llama 4 系列的技术亮点包括原生多模态训练、超长上下文窗口的实现以及优化的训练流程。超长上下文窗口的实现依赖于 iRoPE 架构,通过长度外推能力在短序列上训练,泛化到极长序列。训练流程采用了轻量级 SFT → 在线 RL → 轻量级 DPO 的策略,以避免过度约束模型。

尽管 Llama 4 Behemoth 在几项指标上略逊于 DeepSeek R1 和 OpenAI o1,但仍极具竞争力,位居或接近推理排行榜的榜首。然而,开源社区对 Llama 4 Scout 和 Maverick 无法在消费级 GPU 上运行表示失望,认为这对开源社区的可及性是个不小的损失。Meta 强调 Llama 4 Scout 能在单张 H100 上运行,说明 MoE 架构更符合当前开源策略。

Meta 还推出了智能调参 MetaP 技术,类似于贝叶斯优化,能在有限的试验预算内进行自适应实验。后训练策略强调重 RL 轻 SFT/DPO,以避免过度约束模型。训练过程中,较早的检查点可以作为“批评家”来评估后续模型,帮助过滤掉过于简单的训练样本。

Llama 4 的新许可证对使用有所限制,包括每月活跃用户超过 7 亿的公司必须向 Meta 申请特殊许可,使用 Llama 构建的 AI 模型名称开头必须包含“Llama”,并且必须遵守 Meta 的可接受使用政策。Meta 表示 Llama 4 只是开始,后续还有更多模型正在开发中,特别提到了 Llama 4 Reasoning 模型。

原文和模型

【原文链接】 阅读原文 [ 2340字 | 10分钟 ]

【原文作者】 Founder Park

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★