文章摘要

【关 键 词】 开源AI、大型语言模型、多语言翻译、技术创新、AI民主化

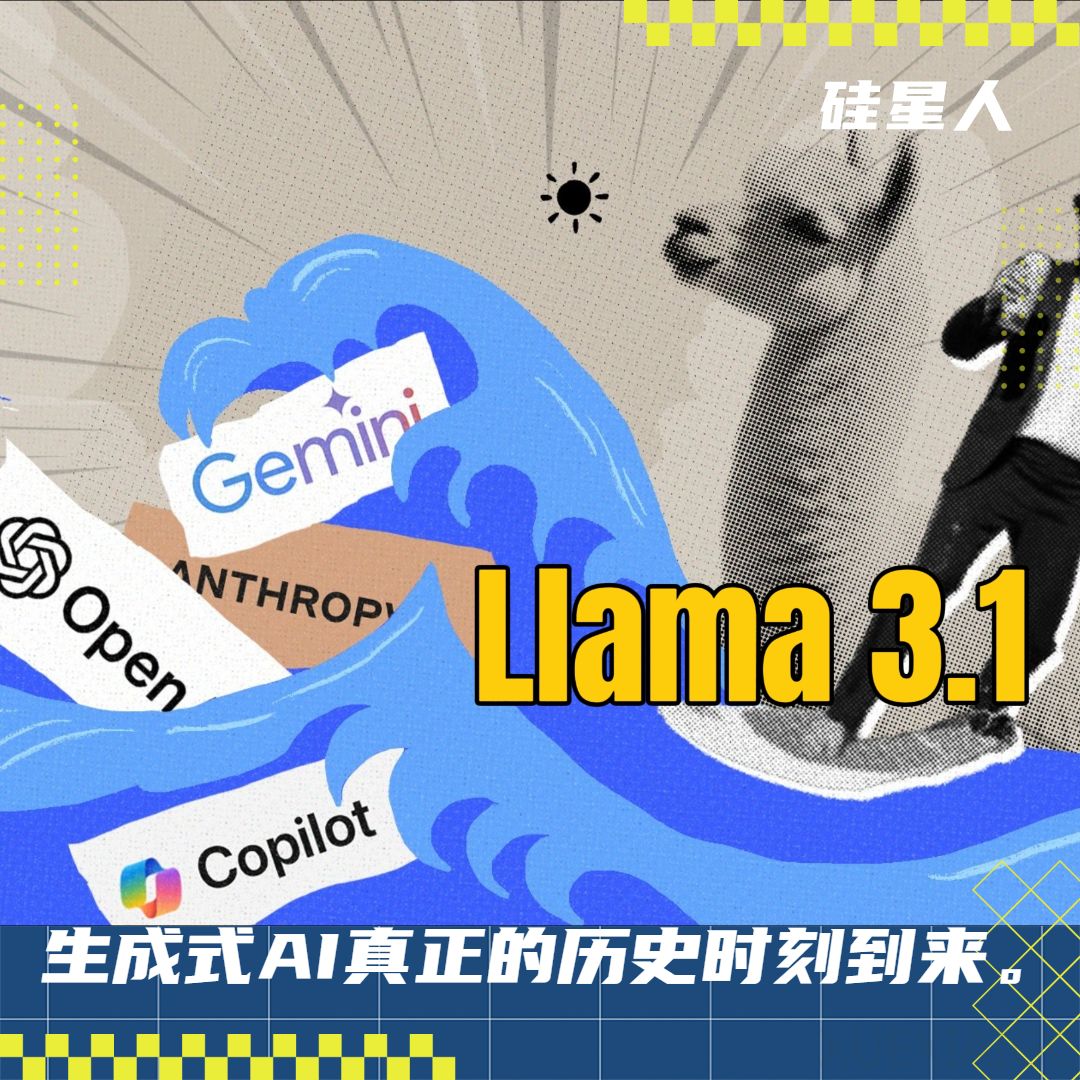

Meta公司发布了新一代开源大型语言模型(LLM)——Llama 3.1系列,包括8B、70B和405B三个尺寸的模型。其中,405B模型包含4050亿个参数,是首个前沿级别的开源AI模型,也是近年来规模最大的LLM之一。Llama 3.1系列模型在通用常识、可引导性、数学、工具使用和多语言翻译等广泛任务中表现出色,能够与GPT-4、Claude 3.5 Sonnet等领先闭源模型相媲美。

Llama 3.1系列模型的主要亮点包括:

1. 模型架构:延续Llama 3的标准解码器transformer架构,以最大化训练稳定性。

2. 巨量数据:405B模型在15万亿token(相当于7500亿个单词)上训练,结合2500万合成数据微调,包含了更多的非英语资料、数学数据和代码以及最近的网络数据。

3. 指令微调:后训练中每一轮都使用监督微调和直接偏好优化来迭代,并通过多轮对齐来改进模型的指令跟随能力和安全性。

4. GPU规模:使用超过1.6万个H100 GPU,时长高达3930万GPU小时。

5. 预训练知识库:更新至2023年12月。

6. 多语言支持:涵盖英语、法语、德语、印地语、意大利语、葡萄牙语、西班牙语和泰语。

Meta在超过150个基准数据集上对Llama 3.1进行了性能评估,涵盖多种语言,并进行了广泛的人类评估。实验结果表明,Llama 3.1 405B在各项任务中完全可与最先进闭源模型竞争,包括GPT-4、GPT-4o和Claude 3.5 Sonnet。在GSM8K数学、IFEval指令遵循、多语言处理、长上下文、ARC推理、Nexus工具调用等多项测试上表现优异。

此外,Llama 3.1 405B具有非常突出的数学能力,在GSM8K任务中表现最佳,得分96.8,高于GPT-4o的96.1和Claude 3.5 Sonnet的96.4。在推理方面,Llama 3.1 405B在ARC挑战任务中再次力克两个闭源强大对手夺冠。在长上下文方面,Llama 3.1 405B在ZeroSCROLLS和InfiniteBench/En.MC上又登榜首。

Llama 3.1系列模型的发布,标志着开源模型在能力上正式向闭源巨头宣战。这将大幅降低AI技术和成本的准入门槛,打破少数公司的垄断局面,加速全球AI研究与应用进程,推动技术创新向多样化发展。Meta已经在研发更强大的Llama 4,预示着AI技术民主化已是大势所趋。

原文和模型

【原文链接】 阅读原文 [ 2253字 | 10分钟 ]

【原文作者】 硅星人Pro

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★