Llama 4在测试集上训练?内部员工、官方下场澄清,LeCun转发

文章摘要

【关 键 词】 Llama4、模型性能、测试集、部署策略、开源社区

Meta最新发布的大模型Llama 4在发布后引发了广泛讨论,但其实际表现与预期存在较大差距。尽管Meta官方宣称Llama 4在多个基准测试中取得了优异成绩,例如在大模型竞技场(Arena)中,Llama 4 Maverick的总排名第二,并在开放模型、困难提示词、编程、数学和创意写作等任务中名列前茅,但用户在实际使用中却发现了诸多问题。例如,在Kscores基准测试中,Llama 4 Scout和Maverick的表现远不如GPT-4o、Gemini Flash等竞争对手,尤其是在编程任务中的表现令人失望。此外,OCR、前端开发、抽象推理等领域的表现也未能达到预期。

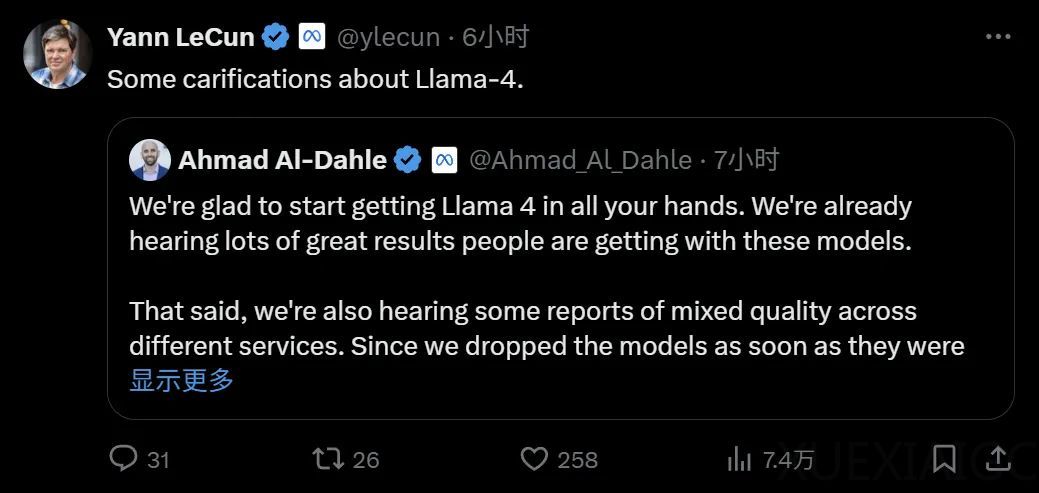

关于Llama 4性能不佳的原因,外界猜测主要集中在测试集是否被混入训练数据的问题上。一位匿名用户在留学论坛上爆料称,Meta领导层曾建议将测试集混入训练数据以提高模型表现,但这一说法并未得到官方证实。Meta的工程师和研究人员对此进行了反驳,强调从未采取过此类做法。Meta Gen AI团队负责人也公开澄清,Llama 4并未在测试集上进行训练,并指出模型的不稳定性可能是由于部署尚未完全稳定所致。

与此同时,一些测试者发现了Llama 4在特定数据集上的异常表现。例如,普林斯顿大学博士生黄凯旋指出,Llama 4 Scout在MATH-Perturb数据集上的得分与其他相似数据集的表现存在显著差异,这可能表明模型在训练过程中过度优化了某些标准测试。Meta官方对此解释称,Llama 4 Maverick在大模型竞技场上的表现是基于“实验性聊天版本”,并针对对话进行了优化。然而,大模型竞技场官方账号对此表示不满,认为Meta的做法是对平台政策的误读,并计划重新测试HuggingFace上发布的Llama 4版本。

尽管存在争议,Llama 4在某些任务中仍展示了其潜力。例如,在生成方案和网页代码的任务中,Llama 4的表现较为出色,并且支持多种语言。然而,用户对其整体性能的质疑并未消除,尤其是在大规模部署和调整之后,Llama 4的真实能力将面临更严格的考验。未来,随着更多测试结果的公布,Llama 4是否能够兑现其承诺,仍有待观察。

原文和模型

【原文链接】 阅读原文 [ 1666字 | 7分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★☆☆