文章摘要

【关 键 词】 自然语言处理、生成式AI、边缘设备、神经网络、智能交互

2022年底,ChatGPT的问世让自然语言处理聊天机器人(NLP)的能力受到广泛关注。科技公司开始探索将这一技术应用于产品和客户体验。然而,生成式人工智能(GenAI)由于其高计算复杂度和功耗需求,带来了显著的成本提升。尽管如此,GenAI算法适用于边缘设备应用,但面临挑战。

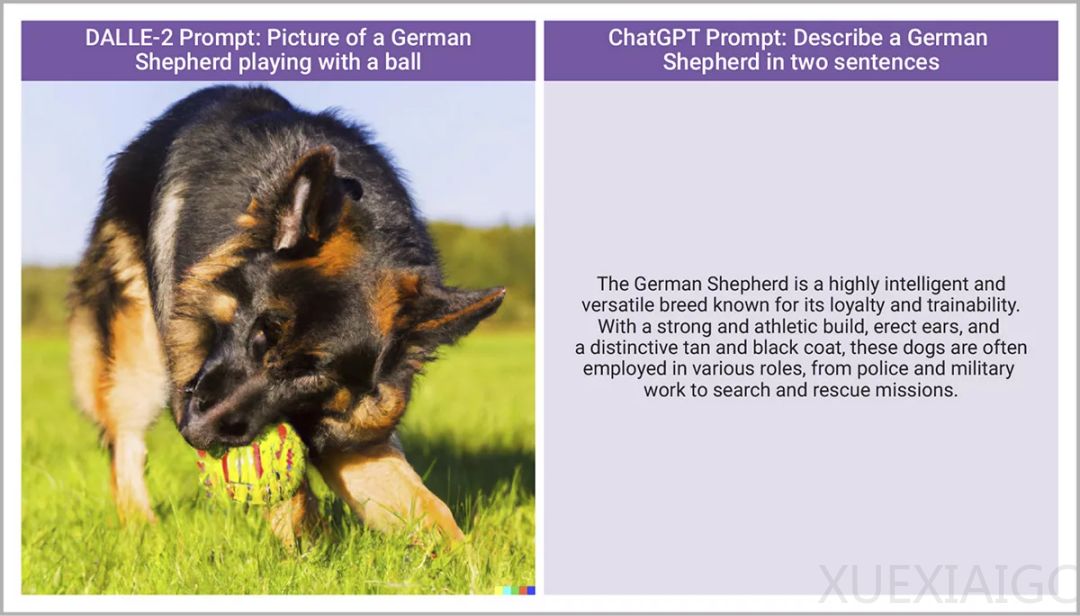

GenAI算法能够生成各种内容,如类人文本和图像。与传统机器学习算法相比,GenAI能够感知和学习规律,并通过模拟原始数据集按需生成新的规律。ChatGPT是最著名的GenAI算法之一,但并非唯一。GenAI算法主要分为文本到文本生成器(如ChatGPT、GPT-4和Llama2)和文本到图像生成模型(如DALLE-2、Stable Diffusion和Midjourney)。

传统的GenAI应用场景需要连接互联网并访问大型服务器群进行复杂计算。然而,边缘设备需要将数据集和神经处理引擎部署在本地,以满足低延迟、高隐私、安全性和有限网络连接等关键需求。将GenAI部署于边缘设备,能够为汽车、相机、智能手机、智能手表、虚拟现实/增强现实(VR/AR)和物联网(IoT)等领域带来全新机遇和变革。

例如,在汽车领域,GenAI的应用包括改善道路救援、将操作手册转换为AI增强的交互式指南、虚拟语音助手和个性化座舱等。其他边缘应用,如AR边缘设备和语音助手,也可以从GenAI中受益。然而,GenAI在边缘设备上的应用尚处于起步阶段,要实现大规模部署,需要突破计算复杂性和模型大小的瓶颈,并解决边缘设备的功耗、面积和性能限制问题。

要将GenAI部署到边缘侧,首先需要了解其架构和运作方式。GenAI快速发展的核心是transformers,一种新型的神经网络架构,具有独特的注意力机制。与传统AI模型不同,transformers更加关注输入数据中的关键部分,如文本中的特定字词或图像中的特定像素。这种能力使transformers能够更准确地理解上下文,从而生成更加逼真和准确的内容。

GenAI模型的参数数量庞大,需要大量的计算资源和内存带宽。为了解决这一难题,研究人员正在积极探索参数压缩技术,以减少GenAI模型的参数数量。此外,选择更快的内存接口也是解决这些问题的有效方法。

新思科技的ARC® NPX6处理器具有灵活的内存架构,可支持可扩展的L2内存,最高可支持64MB的片上SRAM。此外,每个NPX6内核都配备了独立的DMA,专门用于执行获取特征图和系数以及编写新特征图的任务。这种任务区分可以实现高效的流水线数据流,从而最大限度地减少瓶颈并最大化处理吞吐量。

ARC® NPX6 NPU IP系列基于第六代神经网络架构,旨在支持包括CNN和转换器在内的一系列机器学习模型。NPX6系列可通过可配置数量的内核进行扩展,每个内核都有自己的独立矩阵乘法引擎、通用张量加速器(GTA)和专用直接内存访问(DMA)单元,用于简化数据处理。

随着行业各界人士不断探索新的算法和优化技术,以及IP厂商的助推,GenAI将彻底改变我们与设备交互的方式,为我们带来更加智能化、个性化和美好的未来。

原文和模型

【原文链接】 阅读原文 [ 2755字 | 12分钟 ]

【原文作者】 半导体行业观察

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★