GPU泡沫破灭前夜:2美元/小时出租,H100算力价格暴跌75%

文章摘要

【关 键 词】 AI产业、GPU需求、算力成本、市场泡沫、投资回报

AI产业的年产值被认为需超过6000亿美元才能覆盖AI基础设施的费用,如数据中心和GPU卡。尽管基础模型训练的资本支出被看作是快速贬值的资产,但对于GPU基础设施支出的评估尚未明确。大模型公司如OpenAI在训练和推理上的支出超过了收入,最近在历史上最大的风险投资轮中筹集了66亿美元,预计到2026年亏损将达到140亿美元。

NVIDIA的新一代Blackwell系列芯片已交付给OpenAI,且下一年的产品已售罄。NVIDIA CEO黄仁勋认为这可能是行业历史上最成功的产品。与此同时,AMD CEO苏姿丰推出了MI325X,AI推理芯片公司Cerebras提交了IPO申请。数十亿美元的投入可能会促进AI上层的繁荣,但也可能带来泡沫。

作者Eugene Cheah深入研究了H100市场,发现市场上的H100算力已经供过于求,导致价格从8美元/小时降至低于2美元/小时。他建议用户在需要时租用而不是购买算力。AI竞赛的简史显示,基于A100 GPU系列训练的GPT3.5和ChatGPT吸引了全球对AI的想象,并开启了AI竞赛。H100的推出引发了对更高性能和更大模型的追求,但随着时间的推移,H100的价格开始下降,导致市场出现变化。

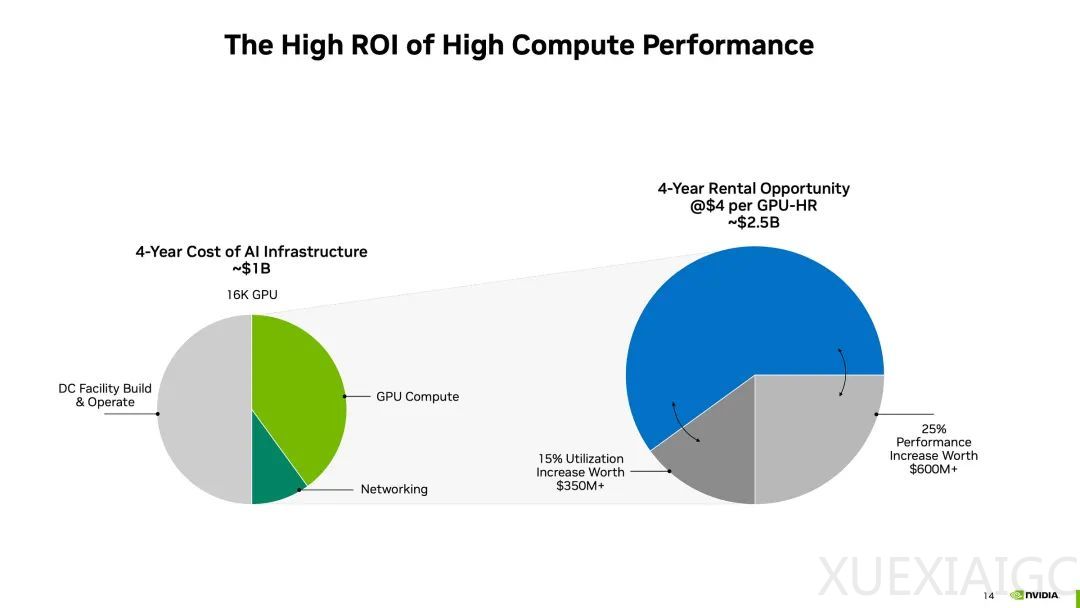

在数据中心,一张H100 SXM GPU的设置、维护和运营成本平均为50000美元或更多。对于按需租赁,如果价格低于2.85美元/小时,投资回报率将低于股市的内部收益率(IRR),而低于1.65美元/小时则可能导致投资亏损。长期租赁(3-5年)的模式也在变化,许多基础设施提供商推动前期承诺和支付,以锁定利润。

当前H100的价值链包括硬件供应商、数据中心基础设施提供商、风险投资基金、大型公司和初创公司,以及算力转售商。开放权重模型的兴起导致市场发生根本性变化,对AI推理和微调的需求增加。这导致基础模型创建市场萎缩,小型和中型模型创建者转向微调,减少了对H100的需求。

其他因素也导致算力供应增加和训练需求减少,如大型模型创建者离开公共云平台,未使用/延迟供应的算力上线,以及更便宜的GPU替代品的出现。这些因素可能导致H100集群价格的分层,新的公共云H100集群可能面临无利可图的风险,而中型到大型模型构建者可能已经通过长期租赁榨取了算力价值。便宜的H100可能加速开放权重AI的采用浪潮,推动AI应用的发展。

最终,作者建议不要购买全新的H100,因为这样的支出很可能是亏损的,除非有特定的条件,如折扣的H100、折扣的电力,或有主权AI的需求。

原文和模型

【原文链接】 阅读原文 [ 6317字 | 26分钟 ]

【原文作者】 Founder Park

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★