文章摘要

近来,GPT-4.5在创意写作、教育咨询、设计提案等任务中展现出惊人的连贯性与创造力,引发了关于多模态大模型(MLLMs)创造力天花板的讨论。现有的评测基准难以衡量多模态大模型的创造性见解,且部分情境过于简单,无法真实反映模型在复杂场景下的创造性思维。为此,浙江大学联合上海人工智能实验室等团队发布了Creation-MMBench,这是全球首个面向真实场景的多模态创造力评测基准,覆盖四大任务类别、51项细粒度任务,用765个高难度测试案例,为MLLMs的“视觉创意智能”提供全方位体检。

在人工智能的“智力三元论”中,创造性智能(Creative Intelligence)始终是最难评估和攻克的一环,主要涉及的是在不同背景下生成新颖和适当解决方案的能力。现有的MLLM评测基准,如MMBench、MMMU等,往往更偏重分析性或实用性任务,却忽略了多模态AI在真实生活中常见的“创意类任务”。Creation-MMBench设置的情境复杂,内容多样,且单图/多图问题交错,能更好的对多模态大模型创意力进行考察。

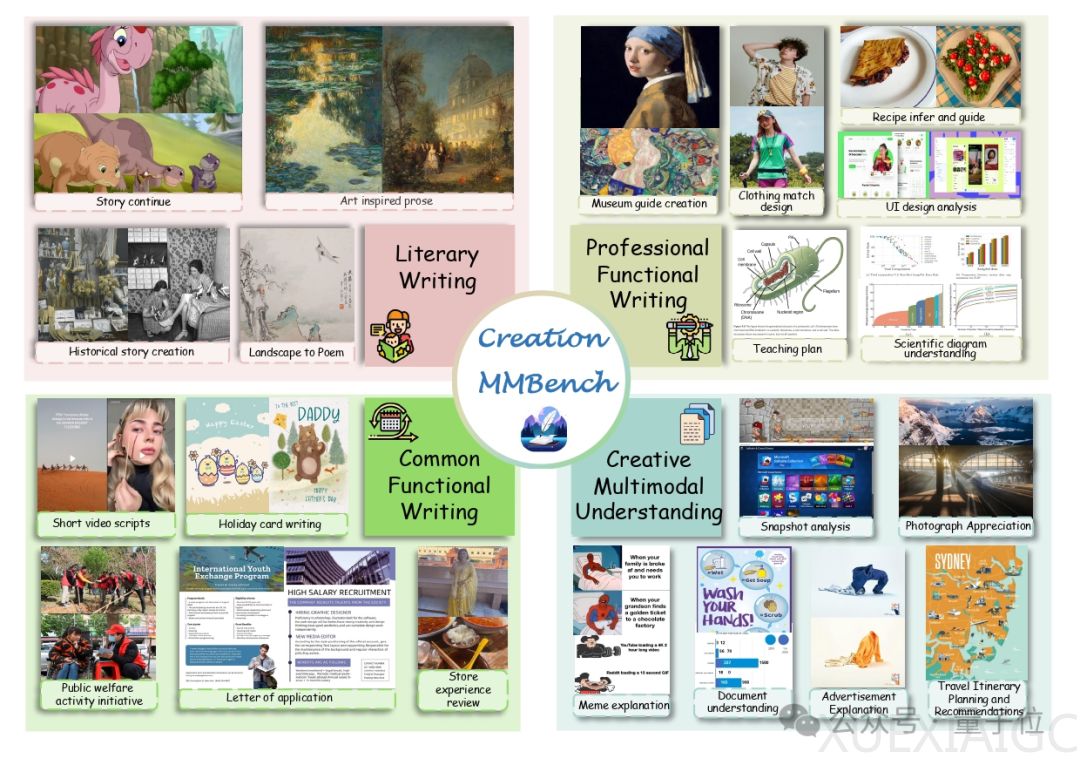

Creation-MMBench的四大任务类型包括文学创作、日常功能性写作、专业功能性写作和多模态理解与创作。在图像上,Creation-MMBench 横跨艺术作品、设计图纸、生活场景等近30个类别,涉及千张不同图片。单任务最多支持9图输入,逼真还原真实创作环境。对于每一个实例,都基于真实图像进行标注,配套明确角色、特定背景、任务指令与额外要求四部分共同组成问题。同时,相较于其他广泛使用的多模态评测基准,Creation-MMBench 具有更全面和复杂的问题设计,大多数问题的长度超过 500 个词元,这有助于模型捕捉更丰富的创意上下文。

在评估策略上,团队选择了使用多模态大模型作为评判模型,同时使用两个不同指标进行双重评估。视觉事实性评分(VFS)确保模型不是“瞎编”——必须读懂图像细节。创意奖励分(Reward)不仅看懂图,更得写得好、写得巧!为了确保评判的公正性和一致性,GPT-4o作为评判模型,会充分结合评判标准、画面内容、模型回复等内容,在双向评判下给出模型回复与参考答案(非标准答案)的相对偏好。

团队基于VLMEvalKit工具链,对20多个主流MLLMs进行了全面评估,包括GPT-4o、Gemini系列、Claude 3.5,以及Qwen2.5-VL、InternVL等开源模型。整体而言,与GPT-4o相比,Gemini-2.0-Pro 展现出了更为出众的多模态创意性写作能力,在部分任务如日常功能性写作上能有效的整合图像生成贴合日常生活的内容。开源模型如Qwen2.5-VL-72B,InternVL2.5-78B-MPO等也展现出了与闭源模型可以匹敌的创作能力,但整体而言仍与闭源模型存在一定差距。

Creation-MMBench现已集成至 VLMEvalKit,支持一键评测,完整评估你的模型在创意任务中的表现。想知道你的模型能不能讲好一个图像里的故事? 来试试 Creation-MMBench 一键跑分,用数据说话。

原文和模型

【原文链接】 阅读原文 [ 3176字 | 13分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek/deepseek-v3/community

【摘要评分】 ★★★★★