文章摘要

【关 键 词】 AI评估、游戏智能体、模型对比、Claude3.7、开源项目

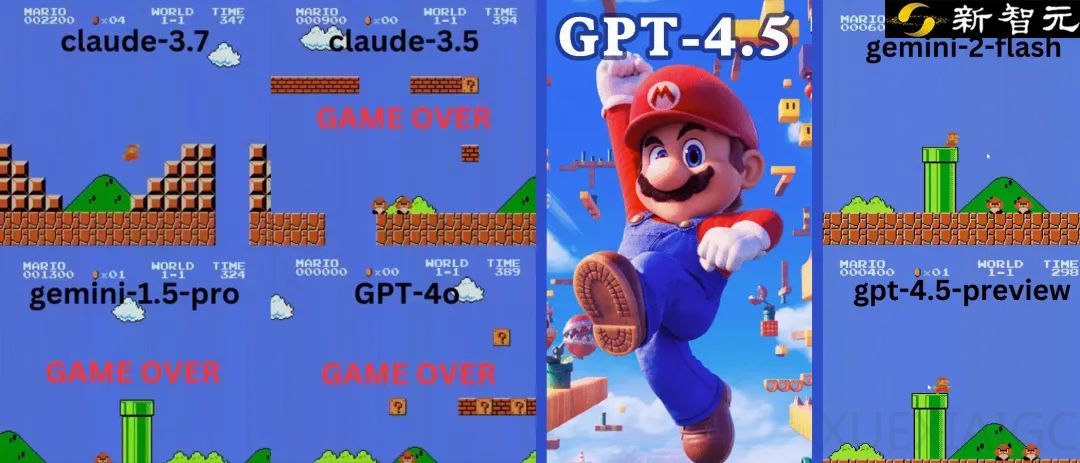

加州大学圣迭戈分校Hao AI Lab通过开发游戏智能体评估框架,为大型语言模型的性能测试开辟了新路径。研究团队利用《超级马里奥》《2048》和《俄罗斯方块》等经典游戏,对Claude 3.7、GPT系列及Gemini等主流模型进行系统性评测,发现Claude 3.7 Sonnet在动作类游戏中展现出显著优势,其操作逻辑与人类玩家高度契合。

在《超级马里奥》测试中,不同模型的表现差异显著。OpenAI的GPT-4o因操作失误在20秒内即被首个障碍击败,GPT-4.5虽能完成基础操作,但决策延迟达10秒以上,反映出模型在实时环境中的响应缺陷。谷歌Gemini 1.5 Pro展现出规律性跳跃模式,而升级版Gemini 2.0 Flash虽突破前代限制,仍受限于地形判断能力,最终跌落深坑结束进程。

Claude 3.7 Sonnet在90秒测试周期内展现出类人化智能特征:精准把握跳跃时机躲避小怪,成功触发隐藏奖励机制获取超级星星,并首次触及库巴级BOSS。该模型对环境交互的理解深度体现在其动态路径规划能力,即便最终因地形误判终止进程,仍创下当前最优测试记录。

研究团队将评测范围扩展至益智类游戏,揭示模型在复杂策略领域的局限性。在《2048》测试中,GPT-4o因计算超时陷入操作停滞,Claude 3.7虽优于前者仍未能突破算法瓶颈。俄罗斯方块测试则暴露出多数模型在快速形状匹配与空间预判方面的共性缺陷,唯有Claude 3.7达到可玩性基准。

该项目开源的游戏智能体框架引发行业关注,开发者可通过标准化接口实现多模型竞技对比。Anthropic开发者关系负责人指出,该评测体系弥补了传统基准在动态环境适应力、实时决策等维度的测量空白。社区反馈显示,将电子游戏转化为评估工具的趋势可能重塑LLM研发方向,部分研究者已提议建立跨游戏的综合评测矩阵。

原文和模型

【原文链接】 阅读原文 [ 1322字 | 6分钟 ]

【原文作者】 新智元

【摘要模型】 deepseek-r1

【摘要评分】 ★★★☆☆