文章摘要

【关 键 词】 语言模型、记忆能力、无状态函数、训练数据、记忆机制

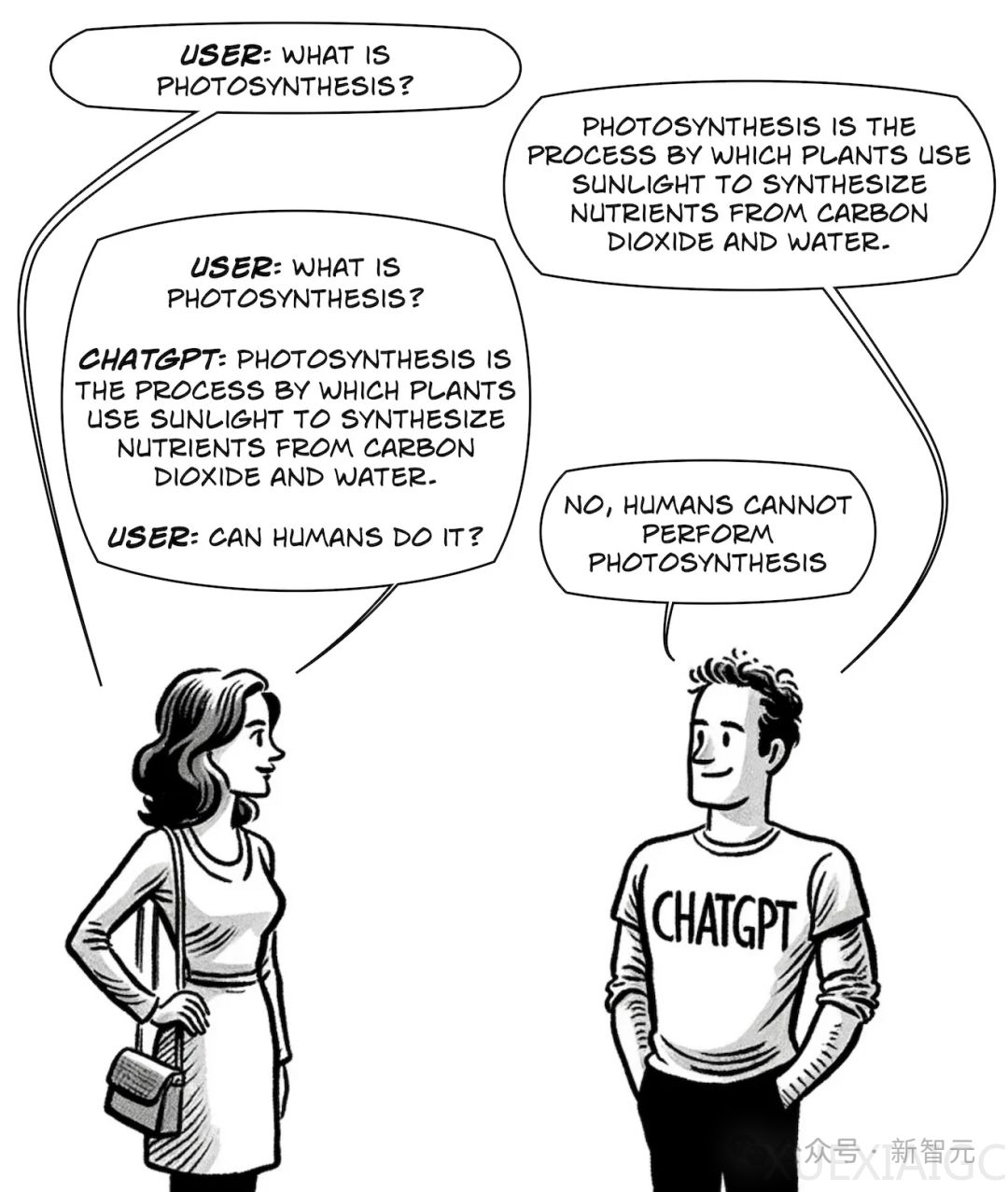

在探讨大型语言模型(LLM)的记忆能力时,Simon Willison指出,尽管LLM看似具备记忆功能,实则它们在推理时并不能记住任何信息,本质上是无状态函数。用户感受到的“记忆”实际上来自于对话上下文的连续提供。这种设计使得模型在面对错误或偏差时,可以通过重置对话来恢复“正轨”。上下文长度的限制使得模型只能保有有限的“工作记忆”。

然而,在训练过程中,LLM表现出不同的记忆特性。DeepMind的最新研究发现,模型能够逐字逐句地输出训练数据,表明训练过程中的记忆不仅仅是简单的复制,而是以某种方式集成在模型的参数中。研究发现,模型参数量越大,记住的训练数据越多,且某些单词更易触发模型回忆训练数据。这既可能反映模型的记忆能力差异,也可能是由于辅助数据集的偏差。

此外,文章提出,为LLM提供外部记忆能力的方法,如直接提供历史对话、递归总结对话内容、使用矢量数据库等,可以在长期和短期记忆之间取得平衡。文章最后提出思考:若改进LLM的记忆方式,使其能更抽象地存储训练数据,是否能够进一步提升模型的能力?这暗示了当前模型记忆机制仍有“机械化”成分,而未来研究或许能在这方面取得突破。

原文和模型

【原文链接】 阅读原文 [ 1925字 | 8分钟 ]

【原文作者】 新智元

【摘要模型】 glm-4

【摘要评分】 ★★★☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...