文章摘要

【关 键 词】 提示缓存、AI优化、成本降低、缓存策略、性能提升

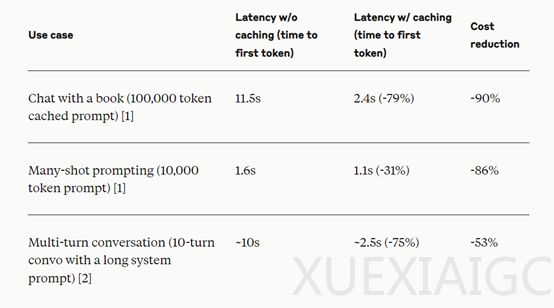

Anthropic公司为其大模型平台API引入了一项新功能——提示缓存(Prompt Caching),旨在帮助开发者优化API调用的效率和成本。这一功能特别适用于需要处理大量上下文信息的场景,如AI代理、编码助手、大型文档助手等。通过缓存,可以显著降低长提示的处理成本和延迟,最高可降低成本90%和延迟85%。

提示缓存的工作原理是,当用户发送请求时,系统会检查是否已有缓存的提示前缀。如果存在,系统将直接使用缓存版本,从而减少处理时间;如果不存在,系统将处理完整提示并创建缓存。缓存的生命周期为5分钟,每次使用时都会刷新。

为了充分利用提示缓存,开发者应将静态内容、系统指令和上下文放在提示的开头,并使用cache_control参数标记可缓存内容的结束。最多可以定义4个缓存断点,以分别缓存不同的可重用部分。此外,开发者还可以通过API响应字段中的usage来监控缓存性能,根据实际使用场景定制缓存策略。

在定价方面,提示缓存引入了新的结构。以Claude 3.5 Sonnet模型为例,基本输入token价格为每千个3美元,缓存写入价格为每千个3.75美元,而缓存命中价格仅为每千个0.30美元,输出token价格为每千个15美元。这意味着缓存写入token比基本输入token贵25%,而缓存读取token则便宜90%。

为了确保缓存的有效性,开发者需要注意以下几点:确保跨调用的缓存部分相同,检查调用是否在5分钟的缓存生命周期内进行,以及验证tool_choice.type和图像使用在调用之间是否保持一致。任何tool_choice.type的更改或提示中图像的存在/缺失都会导致缓存失效,需要创建新的缓存条目。

总之,提示缓存功能为开发者提供了一种优化API调用效率和成本的有效手段,尤其适用于需要处理大量上下文信息的场景。通过合理利用缓存,开发者可以显著提高应用性能,降低成本,并提升用户体验。

原文和模型

【原文链接】 阅读原文 [ 1008字 | 5分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆