AI智能体的炒作与现实:GPT-4都撑不起,现实任务成功率不到15%

文章摘要

【关 键 词】 AI智能体、性能挑战、现实应用、方法比较、人机协同

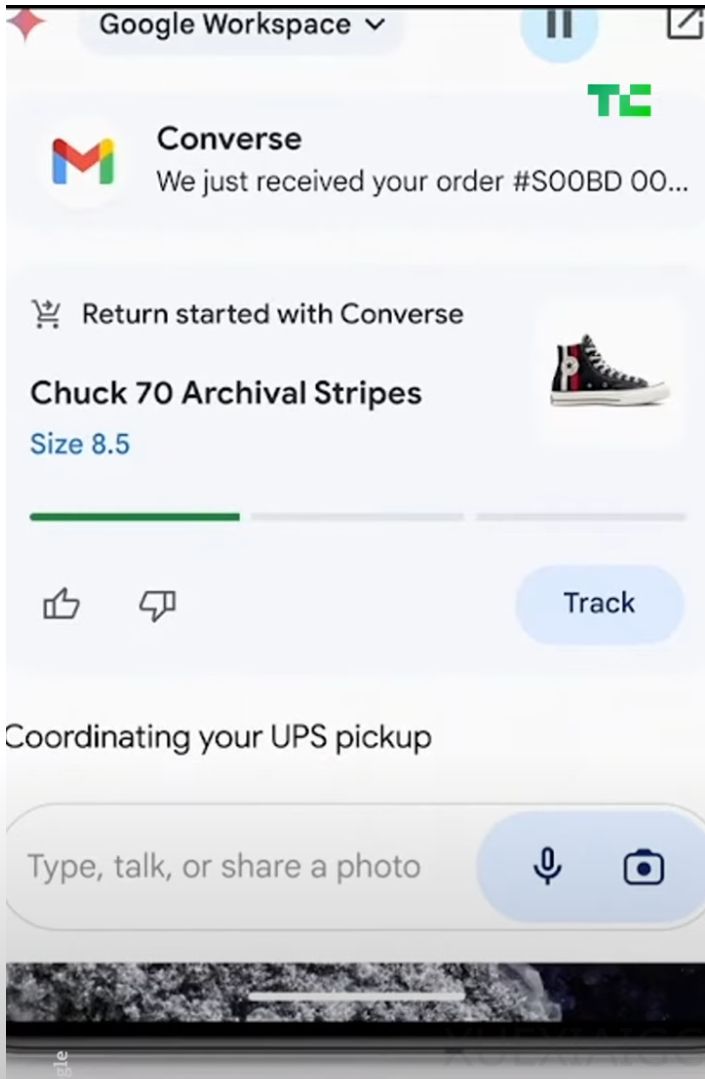

尽管大型语言模型(LLM)在性能、准确度和稳定性方面取得了显著进步,但在现实世界中的应用,特别是作为AI智能体,仍面临重大挑战。AI智能体在公共传媒中被视为能够处理多模态、多任务、多领域的强大系统,然而实际表现与预期差距较大。据WebArena排行榜的基准测试显示,即便是最优秀的模型,在现实任务中的成功率也只有35.8%,而GPT-4等知名模型则更低,仅为14.9%。

AI智能体定义为具有行动能力的LLM,能在环境中进行高层次决策。目前构建AI智能体的主要方法有两种:单一智能体和多智能体系统。单一智能体试图用一个大型模型处理所有任务,而多智能体系统则将任务分解,由多个小型、专业智能体处理。理论上,完美注意力的单一智能体是理想选择,但实际中往往受限于上下文长度,多智能体系统效果较差。

实践中,AI智能体仍存在过早、成本过高、速度慢、可靠性低等问题。这些问题的具体表现包括输出不精确、性能不佳、成本高昂、法律风险和缺乏用户信任。一些初创公司如adept.ai、MultiOn、HypeWrite和minion.ai等正在尝试AI智能体领域,但大多数仍处于实验阶段。

文章认为,AI智能体被过度炒作,大多数尚未准备好用于关键任务。然而,随着模型和架构的快速进步,仍可期待它们在现实应用中的成功。近期内,重点应放在利用AI增强现有工具,而非提供全自主服务。人机协同和现实期望的设定是AI智能体可靠应用的关键。

作者指出,AI智能体有望自动化如网络抓取、填表等重复工作,但在没有人类干预的情况下自动预订假期等复杂任务短期内不太可能实现。通过结合LLMs、评估数据、人机协同监督和传统工程方法,可以在自动化等复杂任务中取得可靠成果。

原文和模型

【原文链接】 阅读原文 [ 2307字 | 10分钟 ]

【原文作者】 机器之心

【摘要模型】 glm-4

【摘要评分】 ★★★★★