ACL 2024论文盖棺定论:大语言模型≠世界模拟器,Yann LeCun:太对了

文章摘要

【关 键 词】 语言模型、世界模拟、准确率、研究发现、实验结果

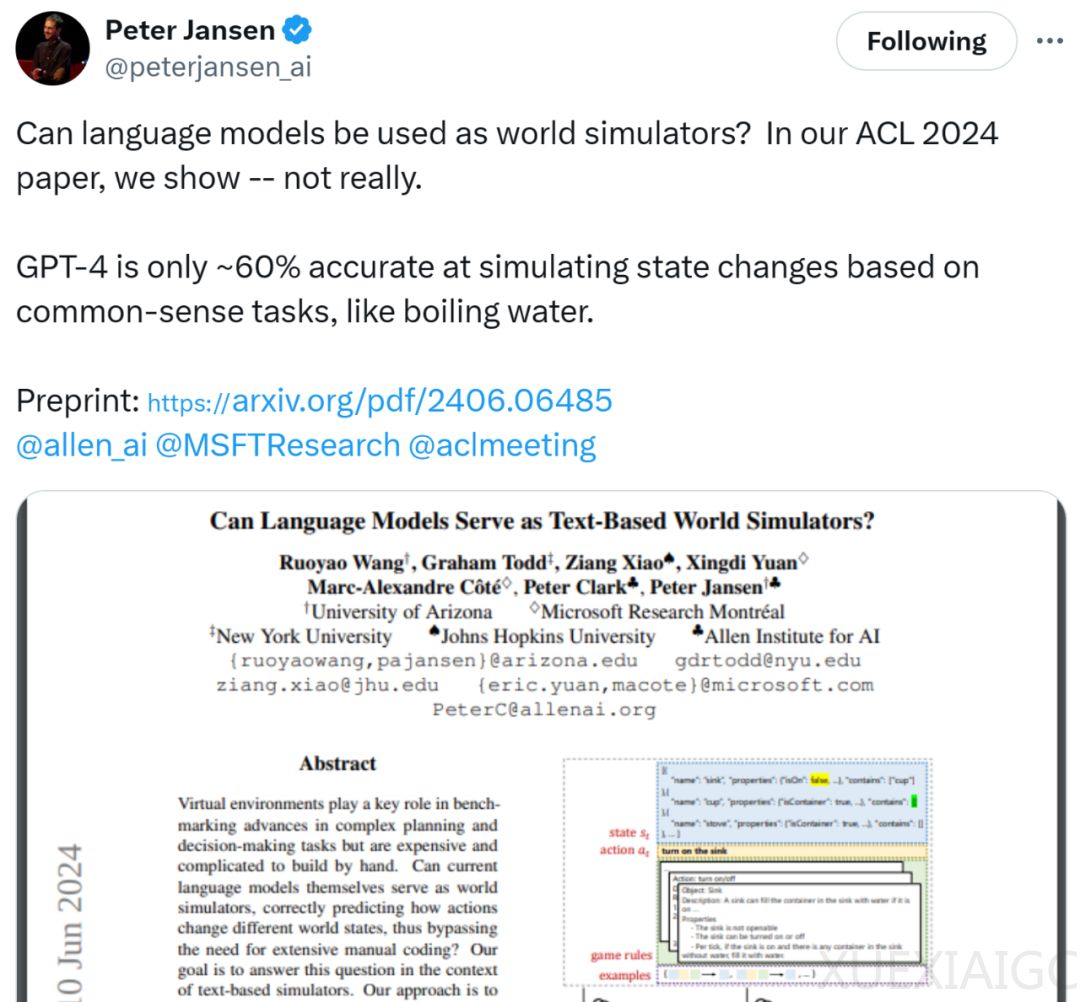

最近,一篇入选ACL 2024的论文《Can Language Models Serve as Text-Based World Simulators?》在社交媒体上引发了广泛讨论。该论文探讨了当前语言模型是否可以充当世界模拟器,并正确预测动作如何改变不同的世界状态,从而避免大量手动编码的需要。研究者来自亚利桑那大学、纽约大学、约翰斯・霍普金斯大学、微软研究院和艾伦人工智能研究所等机构。

研究者认为,当前的语言模型并不能作为可靠的世界模拟器。例如,GPT-4在模拟基于常识任务(如烧开水)的状态变化时,准确率仅为约60%。图灵奖得主Yann LeCun对此表示认同,并指出没有世界模型就没有规划。然而,也有观点认为,当前LLM(没有进行针对性任务训练)的准确率达到60%已经表明它们至少是“某种程度上的世界模型”,并且会随着LLM的迭代而持续改进。

研究者构建并使用了一个新的基准,称为“ByteSized32-State-Prediction”,包含了一个文本游戏状态转换和随附游戏任务组成的数据集。他们首次使用该基准来直接量化大语言模型(LLM)作为基于文本的世界模拟器的性能。通过在这个数据集上测试GPT-4,研究者发现尽管其性能令人印象深刻,但如果没有进一步的创新,它仍然是一个不可靠的世界模拟器。

研究者提出了一个预测任务,称为LLM as-a-Simulator (LLM-Sim),用来定量评估语言模型作为可靠模拟器的能力。LLM-Sim任务是将一个函数F作为世界模拟器来实现。在实践中,完整状态转换模拟器F应考虑两种类型的状态转换:动作驱动转换和环境驱动转换。

实验结果显示,预测动作驱动转换比预测环境驱动转换更容易。在最好的情况下,GPT-4能够正确模拟77.1%的动态动作驱动转换,而环境驱动转换的准确率仅为49.7%。此外,预测静态转换比动态转换更容易。对于动态状态,预测完整游戏状态更容易;而对于静态状态,预测状态差异更容易。

研究者还发现,游戏规则在上下文消息中至关重要。当上下文消息中未提供游戏规则时,GPT-4在所有三个模拟任务上的性能在大多数情况下都会下降。GPT-4在大多数情况下都能预测游戏进度。在上下文中加入了游戏规则信息后,GPT-4可以在92.1%的测试用例中正确预测游戏进度。

人类在LLM-Sim任务中的表现优于GPT-4。研究者对LLM-Sim任务进行了初步的人类研究,结果显示人类的整体准确率为80%,而采样的LLM的准确率为50%。这表明,虽然任务对于人类来说总体上是直观且相对容易的,但对于LLM来说仍有很大的改进空间。

总的来说,研究者认为他们的工作为当前LLM的能力和弱点提供了新的见解,也为跟踪新模型出现时的未来进展提供了一个新的基准。更多技术细节和实验结果请参阅原论文。

原文和模型

【原文链接】 阅读原文 [ 2908字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 gpt-4o

【摘要评分】 ★★★★★