文章摘要

【关 键 词】 参数泄露、医学文档、错误检测、大模型、技术优势

微软在一篇关于医学相关benchmark——MEDEC的论文中意外泄露了OpenAI多个模型的参数规模。论文中提到了o1-preview约300B参数,GPT-4o约200B,GPT-4o-mini约8B等。尽管论文后面有免责声明称确切数据尚未公开,这些数字大多是估计的,但这一泄露还是引起了广泛关注。

MEDEC研究的起因是美国医疗机构调查显示,有1/5的患者在阅读临床笔记时报告发现了错误,40%的患者认为这些错误可能影响他们的治疗。同时,大语言模型(LLMs)被越来越多的用于医学文档任务。因此,MEDEC有两个任务:一是识别并发现临床笔记中的错误;二是还能予以改正。MEDEC数据集包含3848份临床文本,涵盖五种类型的错误,这些错误类型是通过分析医学委员会考试中最常见的问题类型选择的,并由8位医疗人员参与错误标注。

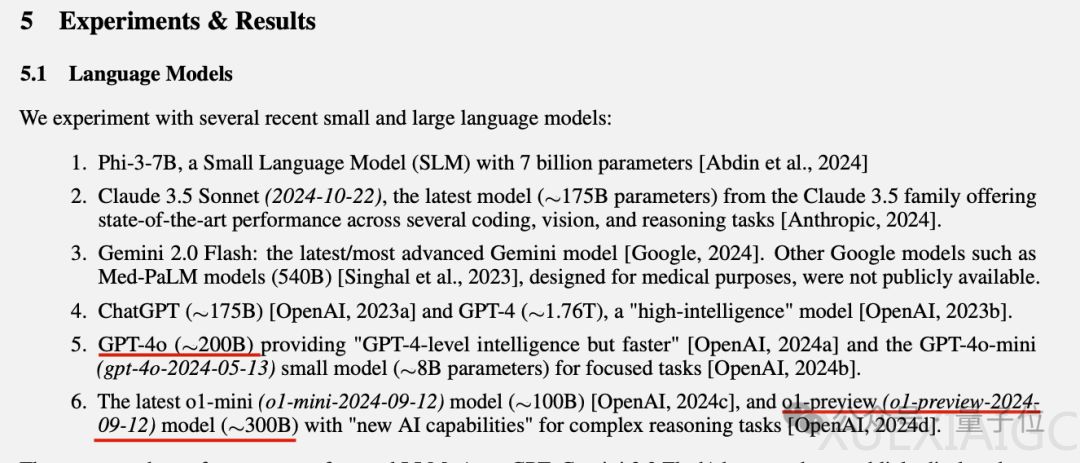

在实验环节,研究者选取了近期主流的大模型和小模型来参与笔记识别和纠错,模型参数、发布时间被公开。研究得出的结论是:Claude 3.5 Sonnet在错误标志检测方面优于其他LLM方法,得分为70.16,第二名是o1-mini。

这一参数泄露事件再次引发了人们对ChatGPT相关模型架构和参数泄露的关注。有网友认为,如果Claude 3.5 Sonnet真的比GPT-4o还小,那Anthropic团队就拥有技术优势。也有网友不相信GPT-4o-mini只有8B这么小。不过此前也有人根据推理成本来算,4o-mini的价格是3.5-turbo的40%,如果3.5-turbo的20B数字准确,那么4o-mini刚好是8B左右。这里的8B也是指MoE模型的激活参数。总之,OpenAI大概是不会公布确切数字了。

原文和模型

【原文链接】 阅读原文 [ 1009字 | 5分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★☆☆☆☆