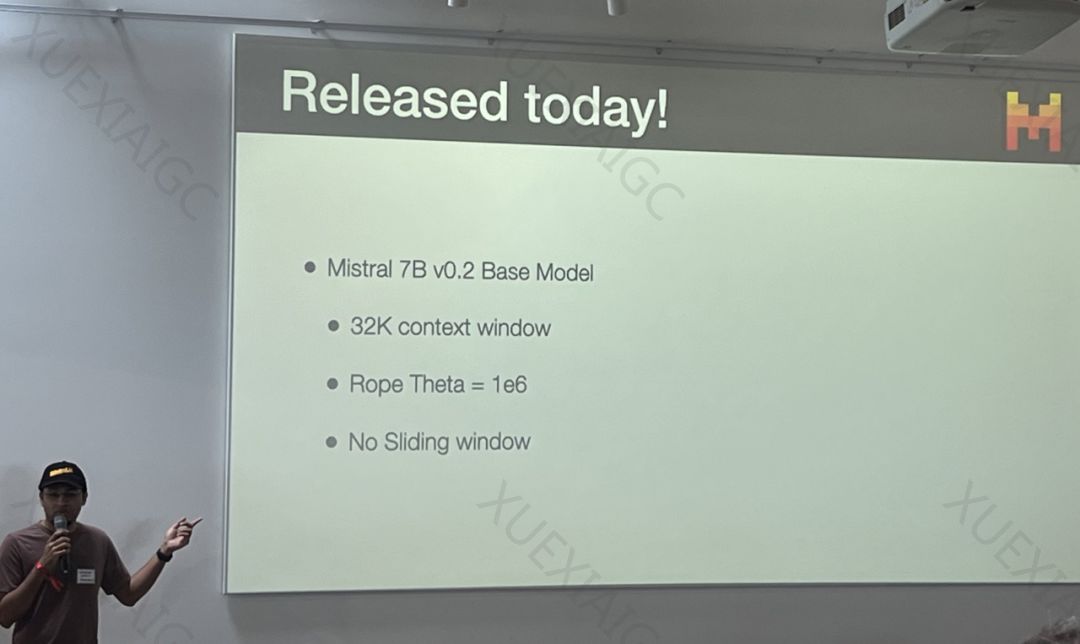

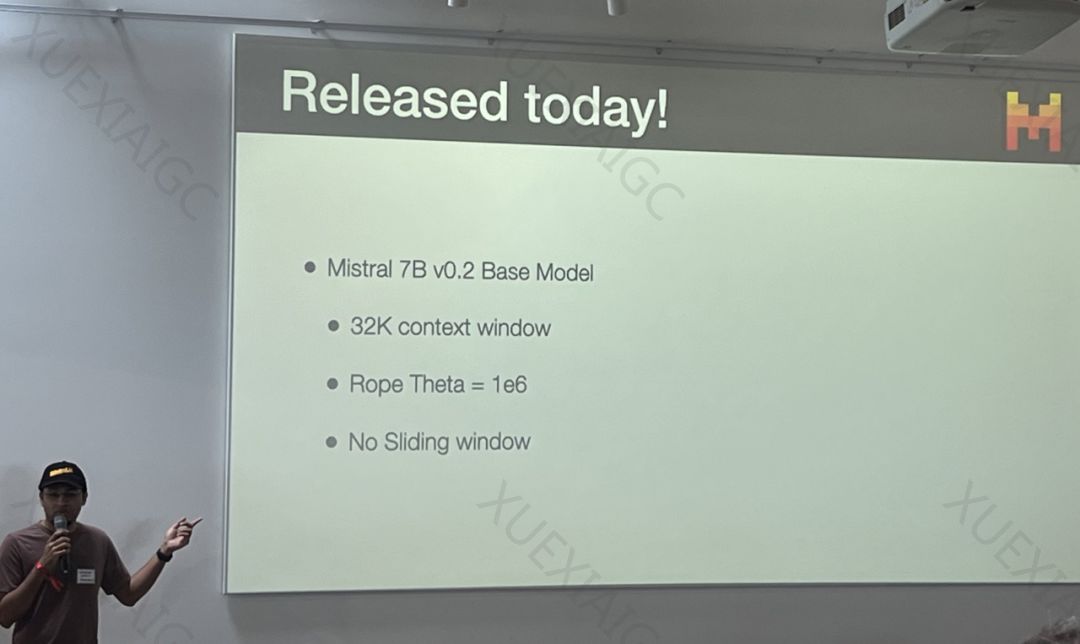

32K上下文,Mistral 7B v0.2 基模型突然开源了

文章摘要

Mistral AI最新发布了

原文和模型

【原文链接】 阅读原文 [ 928字 | 4分钟 ]

【原文作者】 机器之心

【摘要模型】 gpt-3.5-turbo-0125

【摘要评分】 ★☆☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

Mistral AI最新发布了

【原文链接】 阅读原文 [ 928字 | 4分钟 ]

【原文作者】 机器之心

【摘要模型】 gpt-3.5-turbo-0125

【摘要评分】 ★☆☆☆☆