文章摘要

【关 键 词】 多模态、推理能力、强化学习、数学推理、智能体

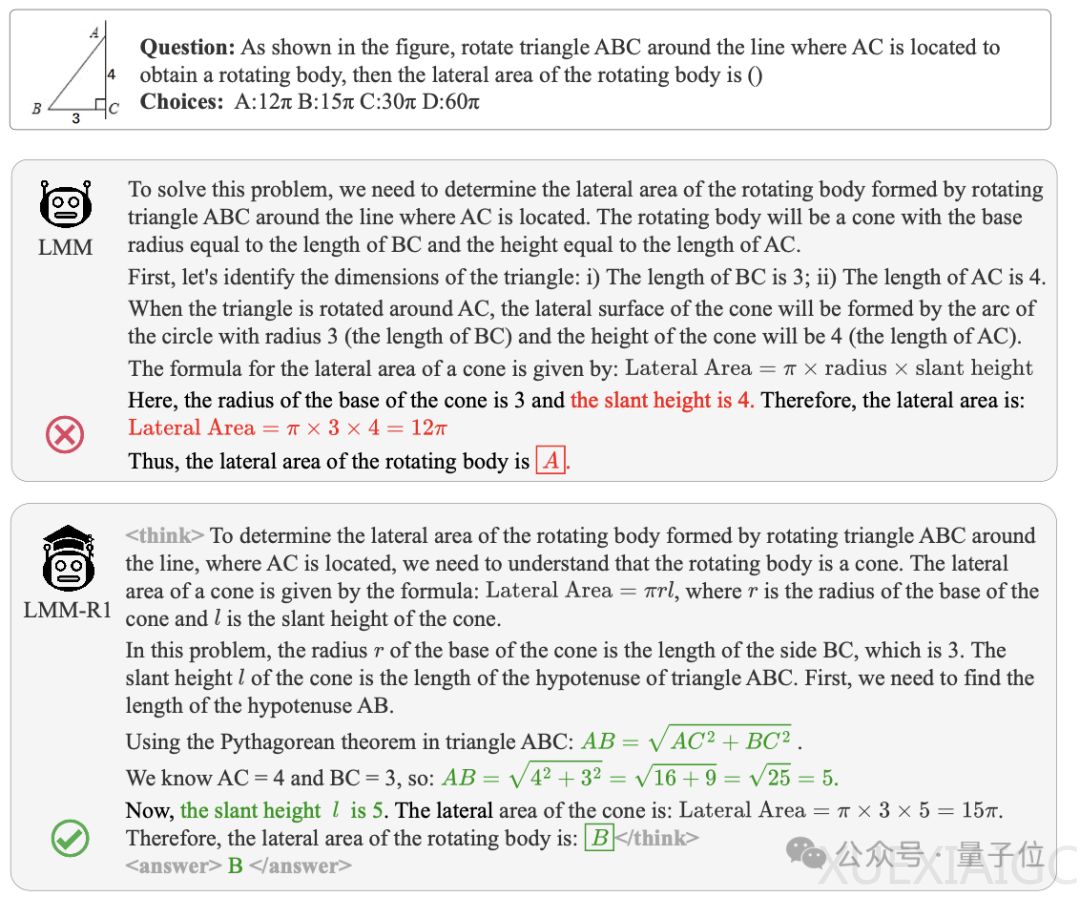

多模态大模型在视觉理解方面表现出色,但在深度数学推理任务上往往表现不佳,尤其是参数量较小的模型。为了解决这一问题,东南大学、香港中文大学、蚂蚁集团等研究人员提出了两阶段多模态基于规则强化学习的框架LMM-R1,显著提升了多模态大模型的推理性能。该框架通过创新的两阶段训练策略,成功解决了多模态领域中“高训练成本、低任务泛化”的难题,并在无需多模态标注数据的情况下,仅需240元GPU成本即可显著增强模型性能。

LMM-R1框架的核心在于其两阶段训练策略。第一阶段为基础推理增强(FRE),利用高质量的纯文本推理数据,通过基于规则的强化学习增强模型的基础推理能力。这一阶段避开了多模态数据的限制,专注于构建坚实的推理基础,使模型能够进行严密的逻辑思考、复杂的数学运算和多步骤推理。第二阶段为多模态泛化训练(MGT),将第一阶段培养的推理能力泛化到多模态领域,特别是在几何推理、感知-推理平衡和智能体相关领域取得了显著进展。这种两阶段策略避免了对昂贵的高质量多模态训练数据的依赖,同时有效利用了丰富的文本推理数据资源。

实验结果显示,经过LMM-R1框架训练的QwenVL-2.5-3B模型在各类基准测试上均取得了显著提升,特别是在推理密集型任务(如几何问题)上效果尤为明显。此外,该框架在推箱子等复杂路径规划任务中,性能显著超越GPT-4o、Claude3.5等100B+参数量产品级大模型。实验证明,通过先增强基础推理能力再进行多模态泛化的策略,可以有效避免直接在多模态数据上训练时常见的推理能力退化问题。

LMM-R1框架的上游项目OpenRLHF实现了完全自主研发的多模态训练方案,通过重构数据流实现多模态支持,基于张量并行优化和内存管理技术创新,构建起高效稳定的训练体系。其开创性的PackingSample + Ring FlashAttention技术实现了模型最大上下文长度基于GPU数量的线性增长率,配合动态梯度裁剪策略,在保证训练稳定性的同时大幅降低资源消耗。项目自2025年2月开源以来迅速获得学术界关注,相关技术方案已被多个知名开源项目采纳为基准架构。

LMM-R1框架的成功不仅展示了多模态强化学习技术的强大应用潜力,还为构建高性能多模态模型提供了一种高效路径。研究团队表示将持续深耕多模态模型领域,推动多模态强化学习技术在智能体、视觉问答等场景的落地应用,并与开源社区共建多模态强化学习框架。

原文和模型

【原文链接】 阅读原文 [ 1564字 | 7分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek-v3

【摘要评分】 ★★★☆☆