文章摘要

【关 键 词】 人工智能、数据规模、模型性能、数据清洗、数据管理

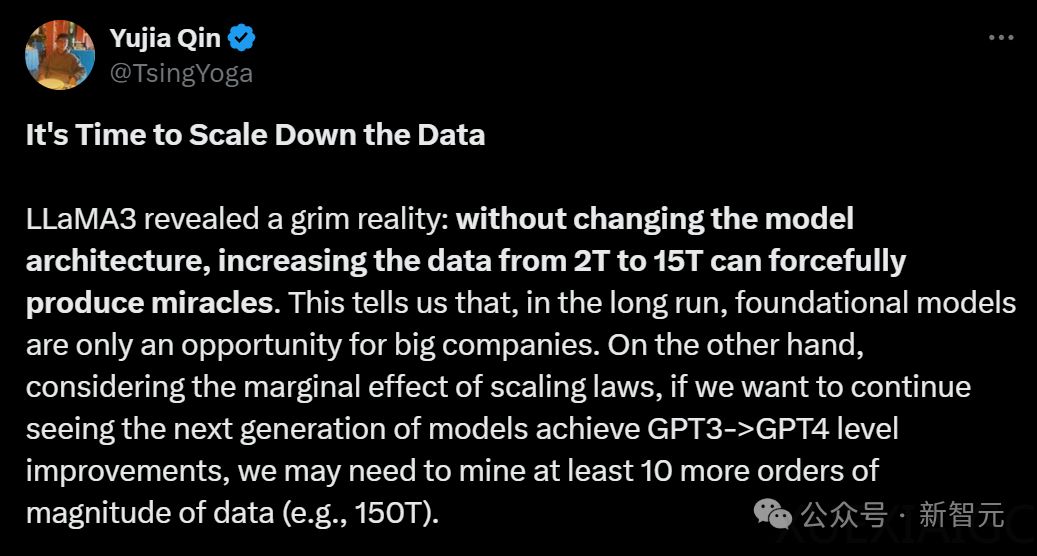

随着人工智能技术的快速发展,数据规模对模型性能的影响日益显著。Llama 3的研究揭示了在不改变模型架构的前提下,数据量从2万亿增加到15万亿可以显著提升模型性能。

然而,这种数据规模的扩大并非易事,它意味着基座模型的发展机会可能只属于大公司。为了实现从GPT-3到GPT-4级别的演进,下一代模型至少需要150T的数据。

幸运的是,DCLM团队从CommonCrawl清洗出了240T的数据,为数据规模的扩大提供了可能。在后Scaling Law时代,除了扩大数据规模,如何缩减规模并提高每单位数据的质量同样关键。

模型的智能来源于数据压缩,而模型也会重新定义数据的组织方式。研究表明,使用模型过滤掉噪声数据可以显著提高大模型的性能和收敛速度。

例如,PbP使用小模型的困惑度来过滤数据,DeepSeek使用fastText清理高质量数据,在数学和代码场景中取得了出色的成果。这些研究都发现,「干净数据+小模型」可以极大地接近「脏数据+大模型」的效果。

为了应对训练数据的挑战,研究人员引入了DataComp-LM(DCLM),这是语言模型训练数据管理的第一个基准。DCLM提出了全新的训练集和数据管理算法,通过使用固定的方法训练模型以评估数据集。

DCLM-POOL是从未经过滤的爬虫网站Common Crawl上扒下来的240T数据集,涵盖了2023年之前所有的数据。获取如此庞大的数据是通过resiliparse架构从HTML中重新提取文本,与Common Crawl原本预处理的方法并不相同。

DCLM还提供了一个去数据污染的工具,让参与者检查自己的测试集和训练集是否有重叠的情况,并提交相关的报告。对于那些表现最好的AI模型,研究人员会特别检查它们是否「作弊」。

这一工具也被应用在了DCLM-POOL,以评估数据污染是否影响模型。为了确保DCLM对拥有不同计算资源的研究人员能够访问,并推动对Scaling Law趋势的研究,研究人员创建了跨越三个数量级计算规模的不同竞赛级别。

每个级别指定了模型参数的数量和一个Chinchilla乘数。这样多种参数规模竞赛的设计存在一个问题——当增加计算规模时,数据整理方法的排名可能会发生变化。

研究人员比较了10种方法在不同参数规模下的表现,发现小参数和大参数结果之间存在高度相关性。在参与者选择了参数规模后,还需从两个基准测试赛道选择其一:过滤和混合。

过滤赛道中,参与者提出算法从候选池中选择训练数据。混合赛道中,允许参与者从多个来源自由组合数据,创造出最好的「配方」。

为了单独研究数据集干预的效果,研究人员还在每种参数规模上固定一个训练方案。基于之前对模型架构和训练的消融实验,他们采用了一个仅有解码器的Transformer模型。

研究的完整评估套件基于LLM-Foundry,包含53个适合基础模型评估的下游任务。总之,在前Scaling Law时代,我们强调的是Scale Up,即在数据压缩后争取模型智能的上限;在后Scaling Law时代,需要比拼的则是Scale Down,即谁能训出更具「性价比」的模型。

目前主流的数据缩减方法是基于模型的数据去噪。最近,也有一些研究开始使用训好的模型来改写预训练数据。

这个过程就需要注意,避免模型在改写过程中生成虚假信息,同时还要有效地去除数据中的固有噪声。未来,更重要的研究方向就是如何对多个数据点进行语义级别的去重和合并,这虽然困难,但对Scale Down意义重大。

原文和模型

【原文链接】 阅读原文 [ 4792字 | 20分钟 ]

【原文作者】 新智元

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★