赶超Gemini Pro,提升推理、OCR能力的LLaVA-1.6太强了

作者信息

【原文作者】 机器之心

【作者简介】 专业的人工智能媒体和产业服务平台

【微 信 号】 almosthuman2014

文章摘要

摘要:

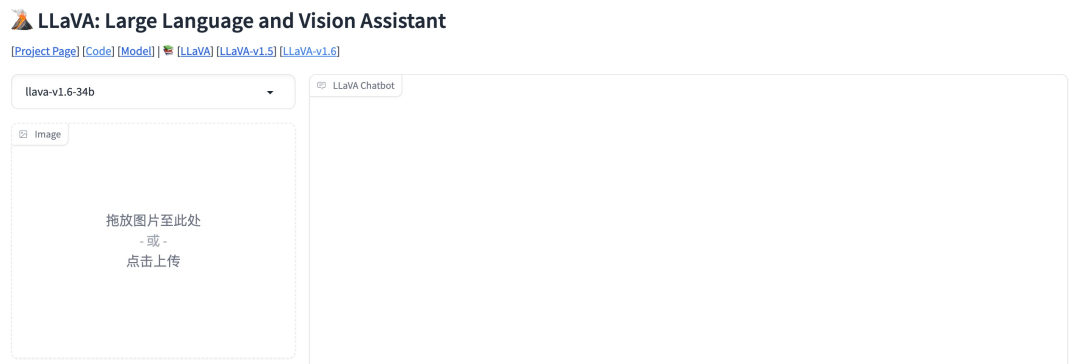

去年,威斯康星大学麦迪逊分校、微软研究院和哥伦比亚大学合作发布了LLaVA(Large Language and Vision Assistant),并在10月推出了LLaVA-1.5,最近又推出了LLaVA-1.6。LLaVA-1.6在推理、OCR和世界知识方面有了显著改进,甚至超越了Gemini Pro。该版本的改进包括提升输入图像分辨率、改进视觉指令调整数据混合、增强视觉对话和世界知识掌握,以及使用SGLang进行高效部署和推理。LLaVA-1.6保持了极简设计和数据效率,使用不到1M的视觉指令调优样本,训练成本仅为其他方法的百分之一至千分之一。与其他开源LMM和商用产品相比,LLaVA-1.6实现了SOTA性能,尤其在零样本中文能力方面表现出色。

方法改进:

LLaVA-1.6在设计上注重动态高分辨率,提高了模型对图像细节的感知能力。通过数据混合,特别是高质量的用户指令数据,研究团队确保了任务指令的多样性和响应的优先级。他们使用现有的GPT-V数据和自己收集的小型视觉指令调优数据集,同时删除了TextCap并添加了DocVQA、SynDog-EN、ChartQA等数据,以提高模型的OCR能力和对图表的理解。团队还考虑采用更多LLM方案,以支持更广泛的用户和场景。

通过这些改进,LLaVA-1.6在多项基准测试中取得了令人瞩目的成绩,展现出了强大的多模态能力和优越的性能表现。

原文信息

【原文链接】 阅读原文

【原文字数】 1009

【阅读时长】 4分钟

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...