作者信息

【原文作者】 code路漫漫

【作者简介】 分享学习路上的经历

【微 信 号】 gh_10b06ffb0f2b

文章摘要

【关 键 词】 生成式AI、预训练、微调、Transformer、Prompt工程

LLM溯源

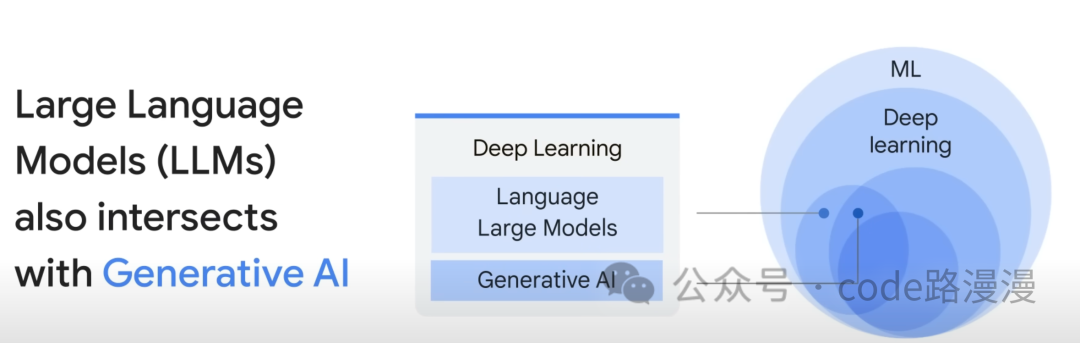

Large Language Models(LLMs)是深度学习领域的一个重要分支,它们属于生成式AI的范畴,能够创造文本、语音、视频等内容。LLMs通过预训练来掌握通用知识,然后通过微调来适应特定任务,类似于对狗进行基本训练和专业训练的区别。

LLM的特点

LLMs的特点在于它们庞大的训练数据集和参数数量。目前开源的最小LLM拥有70亿个参数,这些参数存储了模型所需的知识。训练LLM的成本很高,因此通常先训练一个基础模型来解决一般性问题,再针对特定任务进行微调。

使用LLM的好处

LLMs的出现基于这样一种思想:是否可以训练一个强大的模型来解决多种任务。基础LLM可以用于文本分类、问题回答和内容生成等任务,而针对特定任务的优化只需要少量数据和微调,这大大节省了成本。此外,数据量和参数量越多,模型的能力也越强大。

LLM的结构

LLMs技术基于Transformer架构,通过扩展数据量和参数量,并堆叠多个Transformer层来增强性能。Transformer最初用于解决序列到序列任务,如机器翻译和文本摘要,它由编码器和解码器组成。不同公司根据自己的研究重点,发展出Encoder-Only、Decoder-Only和Encoder-Decoder三种流派。

LLM的发展历程

随着深度学习的发展,我们不再需要像传统编程那样定义一个猫,而是可以通过文本或图片让计算机判断输入是否是猫。LLM的出现进一步简化了这一过程,我们只需向LLM提问即可获得答案。

Prompts

Prompt Engineering是LLM中的一个重要概念,它指的是通过精心设计的提问来引导LLM生成更高质量的答案。Prompt为LLM提供了上下文和规范,使其在特定领域的创作质量更高。Prompt的使用场景包括解决一般性问题、特殊任务和多轮对话。

Fine Tuning

微调是优化LLM在具体任务上表现的关键步骤。由于LLM的参数数量庞大,研究者提出了各种”参数高效的微调方法”,包括Prompt Tuning、Adapter Tuning和Head Tuning,这些方法都旨在减少需要更新的参数数量,使微调更加高效。

原文信息

【原文链接】 阅读原文

【原文字数】 2069

【阅读时长】 7分钟