【原文作者】 郭红俊

【作者简介】 郭红俊的认知分享

【微 信 号】 gh_8aa347587bf9

【关 键 词】 tag1、标准提示词、检索增强生成、微调、模块化

【文章摘要】

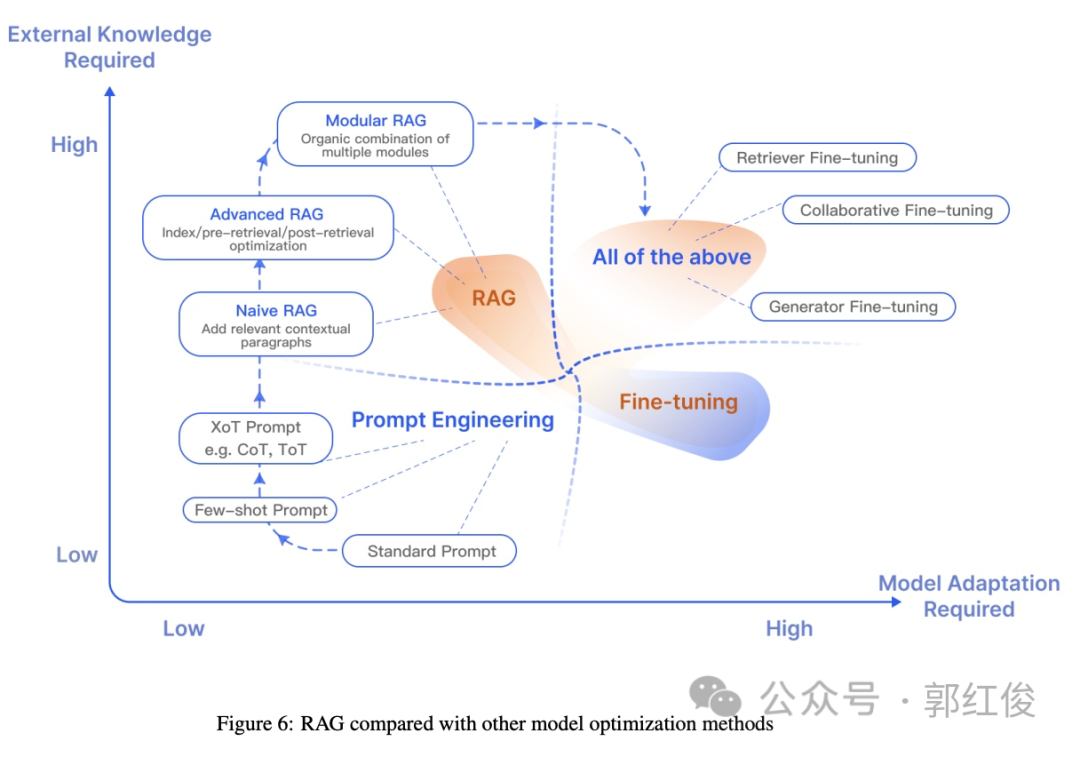

大型语言模型(如GPT、LLama、Gemini)在准确性、知识更新速度和答案透明度方面存在挑战。论文“Retrieval-Augmented Generation for Large Language Models: A Survey”对解决这些问题的模型优化方法做了分类,包括Prompt Engineering(提示词工程)、Retrieval-Augmented Generation(RAG,检索增强生成)和Fine-tuning(微调)。每种方法都有不同的层次和特点。Prompt Engineering包括标准提示词、Few-shot提示词和XoT提示词,用于提高模型的回答精准度。RAG分为Naive RAG、Advanced RAG和Modular RAG三种类型,分别涉及添加相关上下文、在索引/检索前后进行优化以及组合多种模块。而Fine-tuning涉及检索器微调、生成器微调和协同微调,旨在提高模型在特定任务上的表现。

【原文链接】 阅读原文

【原文字数】 2474

【阅读时长】 9分钟

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...