黑匣子被打开了!能玩的Transformer可视化解释工具,本地运行GPT-2、还可实时推理

文章摘要

【关 键 词】 Transformer架构、AI教育、可视化工具、交互式学习、模型理解

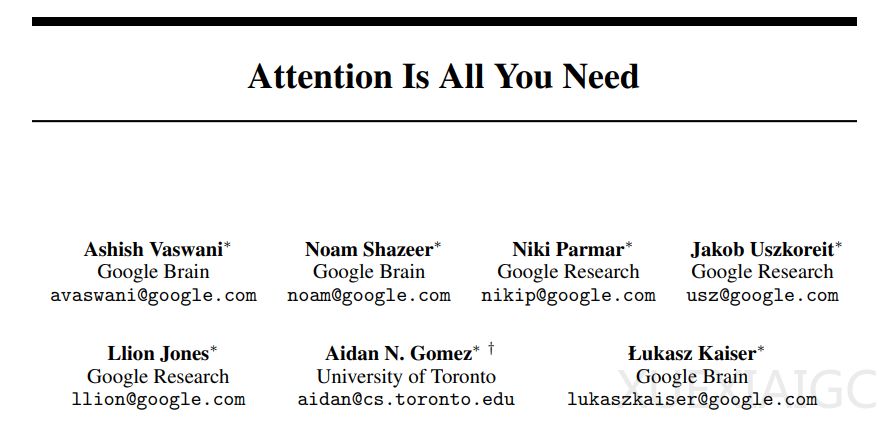

在2017年,谷歌发表的论文《Attention is all you need》中提出了Transformer架构,对深度学习领域产生了深远影响。该架构不仅在文本和视觉任务中广泛应用,尤其在AI聊天机器人领域备受青睐。然而,Transformer的内部工作原理对非专业人士来说仍然不够透明,这限制了他们的理解和参与。为了解决这一问题,佐治亚理工学院和IBM研究院的研究者开发了一款名为“Transformer Explainer”的基于web的开源交互式可视化工具,旨在帮助非专业人士理解Transformer的高级模型结构和低级数学运算。

Transformer Explainer通过文本生成的方式,采用桑基图的可视化设计,展示了输入数据如何在模型组件中流动,有效地说明了信息在模型中的传递过程。该工具不仅提供了模型概述,还允许用户在多个抽象层级之间平滑过渡,从而全面理解Transformer中的复杂概念。此外,Transformer Explainer还具有实时推理功能,集成了实时GPT-2模型,使用户可以在浏览器中交互式地试验自己的输入文本,并观察Transformer内部组件和参数如何协同工作以预测下一个token。

Transformer Explainer的设计和实现采用了多级抽象和交互性设计原则,通过一致的视觉语言和动画序列帮助用户识别架构中的重复模式,同时保持数据的端到端流程。用户可以实时调整温度参数,观察其在控制预测确定性中的关键作用。此外,该工具还支持自定义输入文本,使用户能够更深入地参与和测试不同条件下的模型行为。

在实际应用场景中,Transformer Explainer已被用于自然语言处理课程的教学,帮助学生克服对基于Transformer的模型的恐惧和误解,鼓励他们进行实验和学习。通过使用该工具,学生可以获得对操作的高层次理解,同时深入了解产生结果的底层细节。

未来,研究者们计划通过增强交互式解释、提升推理速度、减小模型大小等方式,进一步改善Transformer Explainer的学习体验。他们还将进行用户研究,评估工具的效能和可用性,并收集用户反馈以支持额外功能的开发。

Transformer Explainer的推出,为打破对Transformer的“魔法”幻想,真正理解其背后的原理提供了一个直观、互动的平台。通过这款工具,无论是AI新手、学生、教育者还是从业者,都能够更深入地了解和掌握Transformer的工作原理和应用。

原文和模型

【原文链接】 阅读原文 [ 2479字 | 10分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★