黄仁勋对话Transformer七子:人类正见证“AI工厂”的诞生|钛媒体AGI

文章摘要

【关 键 词】 英伟达、Transformer、AI、模型、推理

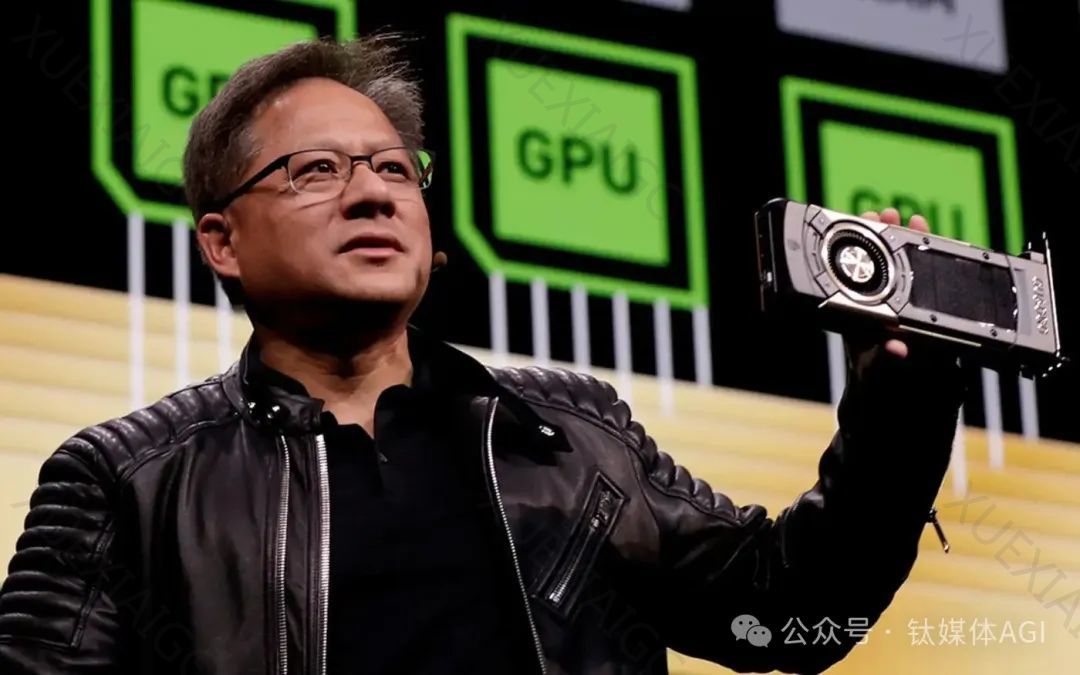

在英伟达GTC大会上,英伟达CEO黄仁勋主持了一场圆桌论坛,邀请了七位Transformer论文《Attention is All You Need》的作者们。

黄仁勋表示,在过去的六十年中,计算机技术并没有经历根本性的变革,但随着时间的推移,计算机的边际成本持续下降,为社会带来了巨大的动力。

2012年,AlexNet的问世标志着人类在AI领域的神奇旅程的开始。

2017年,Transformer模型的提出,使得深度学习NLP翻译模型的性能显著提高,从而诞生了大型语言模型如ChatGPT、Llama、GPT-4等。

在圆桌论坛上,作者们讨论了启发他们去做Transformer的原因。

Illia Polosukhin表示,他想发布能够真正读取搜索结果的模型,当时的递归神经网络(RNN)并不能满足这样的需求。

Noam Shazeer也认为RNN处理起来太麻烦,团队开始探讨用卷积或注意力机制来取代它。

Ashish Vaswani认为,Transformer特别是其自注意力机制具有非常广泛的适用性。

作者们也讨论了当前模型的局限性。

Aidan Gomez认为,这个世界需要比Transformer更好的东西,以推动AI行业的发展。

Llion Jones表示,我们需要在原始模型上做出改进。

此外,自适应计算被认为是接下来必须出现的事情之一,以实现计算资源的高效分配。

Noam Shazeer认为,当前的模型规模还太小,成本也过于经济实惠。

他指出,拥有五千亿参数的模型的成本比购买一本平装书还要便宜。

Ashish Vaswani表示,让世界更聪明的方法之一是实现多任务、多线的并行。

最后,作者们讨论了推理的重要性。

Jakob Uszkoreit表示,下一步是推理,希望模型能够生成我们想要的内容。

Lukasz Kaiser认为,推理实际上来源于数据,数据模型非常重要。

Ashish Vaswani提出,他们有很多合作伙伴取得了一些里程碑式的进展,将真实世界的任务分解成不同的内容。

总的来说,这场圆桌论坛展示了Transformer模型的发展历程、当前的挑战以及未来的发展方向。

作者们分享了他们对AI技术的看法,以及如何推动AI行业的进步。

原文和模型

【原文链接】 阅读原文 [ 2696字 | 11分钟 ]

【原文作者】 钛媒体AGI

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★☆☆☆☆