首个超越GPT4o级开源模型!Llama 3.1泄密:4050亿参数,下载链接、模型卡都有了

文章摘要

【关 键 词】 多语言模型、性能提升、Transformer、安全性考量、环境友好

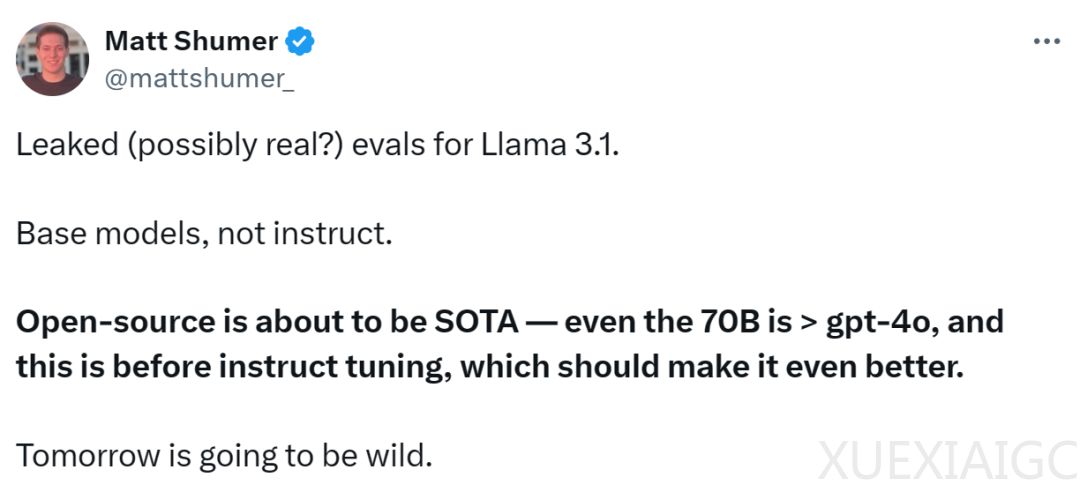

Llama 3.1,一个多语言大型语言模型(LLM)集合,最近在Reddit上泄露,引起了广泛关注。这个集合包含8B、70B和405B三种不同参数规模的模型,且在多项基准测试中超越了OpenAI的GPT-4o。Llama 3.1的模型是基于405B参数模型蒸馏得到的,显示出显著的性能提升。该模型集合支持包括英语、法语、德语、印地语、意大利语、葡萄牙语、西班牙语和泰语在内的多语言,使用了超过15万亿个token的公开数据进行预训练,并且微调数据包括公开指令数据集和1500万个合成样本。

Llama 3.1的模型架构是优化的Transformer自回归语言模型,经过指令微调和强化学习(RLHF)微调,以提高可用性和安全性。模型的上下文长度为128k,使用了分组查询注意力(GQA)技术来提高推理可扩展性。Llama 3.1旨在用于多语言的商业应用和研究,适用于助理聊天和自然语言生成任务,同时支持模型输出用于改进其他模型。

在训练方面,Llama 3.1使用了Meta定制的GPU集群和生产基础设施,累计使用了39.3M GPU小时的计算。尽管训练期间预估的温室气体排放量为11,390吨二氧化碳当量,但由于Meta的净零排放政策,实际排放量为0。训练数据的截止日期为2023年12月,确保了数据的时效性。

Llama 3.1在安全性方面也进行了深入考量,采用了多方面数据收集方法,结合人工生成和合成数据,以减轻潜在的安全风险。研究团队还开发了基于LLM的分类器,以选择高质量的prompt和响应,增强数据质量控制。Llama 3.1的设计宗旨是开放、包容和乐于助人,旨在服务于每个人,并适用于各种使用情况。然而,作为一项新技术,Llama 3.1的使用也存在风险,开发人员在部署模型时应进行安全测试和微调。

原文和模型

【原文链接】 阅读原文 [ 2235字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆