文章摘要

【关 键 词】 AIGC、大语言模型、Jamba、SSM-Transformer、开源

AI研究实验室AI21最近开源了其基于SSM-Transformer混合架构的商业大模型——Jamba。

这个模型在传统的Transformer架构上加入了结构化状态空间模型 (SSM) 技术,以提升其性能。

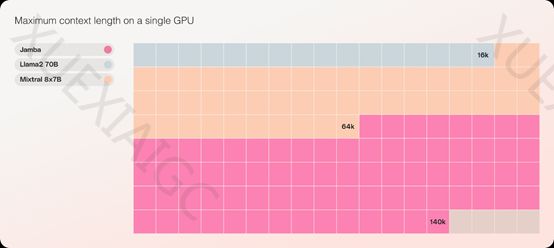

Jamba的吞吐量是同类知名开源模型Mixtral 8x7B的3倍,也是同类模型中极少数能在单个GPU上容纳高达140K上下文的模型。

这意味着小企业和个人开发者也能通过Jamba开发出高性能、低消耗的生成式AI产品。

Jamba的SSM技术源自卡内基梅隆大学和普林斯顿大学的论文《Mamba: Linear-Time Sequence Modeling with Selective State Spaces》。

Mamba的核心技术是使用“选择性状态空间”来进行序列推理,这种灵活性使得它能够更好地处理离散型数据。

Mamba可以根据当前的文本输入数据,有选择地过滤掉不相关的信息,并且能够长时间地记住与当前任务相关的信息。

Mamba不需要使用复杂的自注意力机制或者MLP块(多层感知器),主要通过选择性状态空间和MLP块的协同工作,实现了高效的推理过程,并且在处理长序列数据时非常高效。

Jamba在Mamba的基础之上进行了创新,采用了分块分层的方法成功融合了SSM和Transformer架构。

每个Jamba模块都包含一个注意力层或一个Mamba层,然后是一个多层感知器,总体比例为每八个层中有一个Transformer层。

这样可以在保持模型推理性能的前提下,极大的降低了AI算力同时提升吞吐量。

此外,Jamba还是一个专家混合模型(MoE),520亿参数中的120亿参数长期处于激活状态,并对所有MoE层的专家进行了大幅度优化,减轻了推理时内存占用大的问题。

AI21 Labs创立于2017年,总部位于特拉维夫和纽约。

由Yoav Shoham、Ori Goshen和Amnon Shashua三人联合创立。

仅2023年,AI21一共融资了2.08亿美元,目前总融资额度3.26亿美元。

产品方面,AI21 Labs在2023年3月推出了大语言模型Jurassic-2,包含Large、Grande和Jumbo三种模型。

Jurassic-2除了在文本生成、API延迟、语言支持等全面增强之外,还开放了指令微调、数据微调,帮助企业、个人开发者打造量身定制的ChatGPT助手。

目前,耐克、Zoom、沃尔玛、三星、阿迪达斯、airbnb等知名企业在使用AI21的大模型产品。

原文和模型

【原文链接】 阅读原文 [ 1240字 | 5分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 gpt-4-32k

【摘要评分】 ★★★★☆