零一万物Yi-VL多模态大模型开源,MMMU、CMMMU两大权威榜单领先

作者信息

【原文作者】 机器之心

【作者简介】 专业的人工智能媒体和产业服务平台

【微 信 号】 almosthuman2014

文章摘要

【关 键 词】 多模态模型、语言大模型、Yi-VL、性能测试、模型架构

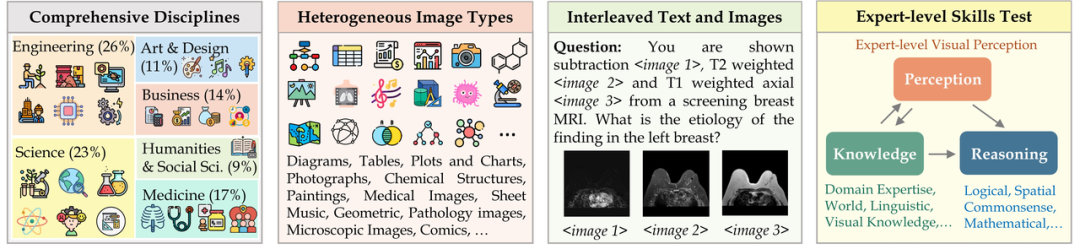

零一万物公司于1月22日发布了Yi-VL多模态语言大模型,该模型基于Yi语言模型开发,包括Yi-VL-34B和Yi-VL-6B两个版本。Yi-VL模型在英文数据集MMMU和中文数据集CMMMU上取得了领先成绩,展示了在复杂跨学科任务上的强大实力。

Yi-VL模型在MMMU数据集上的准确率为41.6%,仅次于GPT-4V的55.7%。在CMMMU数据集上,GPT-4V的准确率为43.7%,而Yi-VL-34B的准确率为36.5%,在现有的开源多模态模型中处于领先位置。

Yi-VL模型的架构设计基于开源LLaVA架构,包含Vision Transformer(ViT)、Projection模块和Yi-34B-Chat及Yi-6B-Chat大规模语言模型。训练方法分为三个阶段,旨在全面提升模型的视觉和语言处理能力。

目前,Yi-VL模型已在Hugging Face、ModelScope等平台上向公众开放,用户可通过这些平台亲身体验这款模型在图文对话等多元场景中的优异表现。

原文信息

【原文链接】 阅读原文

【原文字数】 1260

【阅读时长】 5分钟

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...