文章摘要

【关 键 词】 开源发布、AI模型、性能测试、多语言支持、技术提升

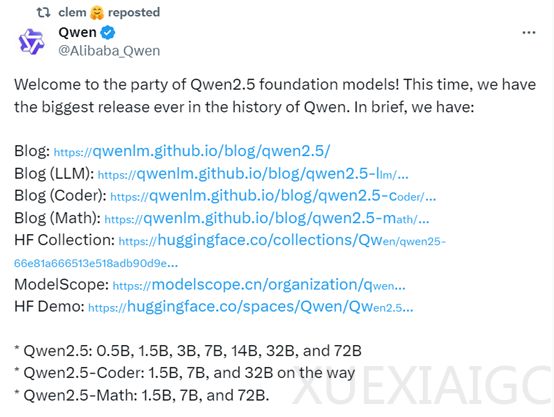

阿里巴巴宣布了其历史上最大规模的开源发布,推出了包括基础模型Qwen2.5、编码专用模型Qwen2.5-Coder和数学模型Qwen2.5-Math在内的三大类模型。这些模型涵盖了从0.5B到72B不同规模的版本,以适应个人、企业以及移动端、PC等不同用户和业务场景的需求。为了简化部署流程,阿里巴巴还提供了Qwen-Plus和Qwen-Turbo模型的API,以便用户能够快速开发或集成生成式AI功能。

在性能测试方面,Qwen2.5系列在多个全球知名基准测试平台上的表现卓越。尽管Qwen2.5-72B模型只有720亿参数,但它在多个基准测试中超越了Meta的Llama-3.1模型,后者拥有4050亿参数。Qwen2.5系列的性能甚至超过了Mistral的Large-V2指令微调模型,成为目前最强大的开源模型之一。即使是未进行指令微调的基础模型,其性能也超过了Llama-3-405B。此外,Qwen-Plus的性能可与闭源模型GPT4-o和Claude-3.5-Sonnet相媲美。

Qwen2.5系列引入了140亿和320亿两种新参数模型,即Qwen2.5-14B和Qwen2.5-32B,其指令微调模型的性能超过了谷歌的Gemma2-27B和微软的Phi-3.5-MoE-Instruct。与闭源模型GPT-4o mini相比,Qwen2.5在三项测试中略低,但在其他基准测试中均超过。

自CodeQwen1.5发布以来,它已经帮助用户完成了各种编程任务。新发布的Qwen2.5-Coder-7B指令微调版本在多个测试基准中击败了参数更大的知名模型。Qwen2.5-Math模型在更大规模的高质量数学数据上进行了预训练,并增加了对中文的支持,通过CoT、PoT和TIR技术增强了其推理能力。Qwen2.5-Math-72B的整体性能超越了Qwen2-Math-72B指令微调和闭源模型GPT4-o。

Qwen2.5系列支持超过29种主流语言,包括中文、英文、法文、西班牙文、葡萄牙文、德文、意大利文、俄文和日文等。与Qwen2相比,Qwen2.5的语言模型支持高达128K tokens,并能生成最多8K tokens的内容。Qwen2.5的预训练数据量达到了18万亿tokens,超过了Meta的Llama-3.1的15万亿tokens,成为目前训练数据最多的开源模型。在知识能力方面,Qwen2.5在MMLU基准测试中的得分从Qwen2-7/72B的70.3提高到74.2,从84.2提高到86.1。在GPQA/MMLU-Pro/MMLU-redux/ARC-c基准测试上也有显著改进。

Qwen2.5能够生成更符合人类偏好的响应,其Arena-Hard分数从Qwen2-72B-Instruct的48.1显著提高到81.2,MT-Bench分数从9.12提高到9.35。数学能力也得到增强,在MATH基准上,Qwen2.5-7B/72B-Instruct的得分从Qwen2-7B/72B-Instruct的52.9/69.0提高到75.5/83.1。此外,Qwen2.5在指令跟踪、生成长文本、理解结构化数据和生成结构化输出方面实现了显著改进,同时对系统提示的多样性更具弹性,增强了聊天机器人的角色扮演实施和条件设置。

原文和模型

【原文链接】 阅读原文 [ 1069字 | 5分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆