作者信息

【原文作者】 DataLearner

【作者简介】 关注数据科学 关注科技行业 关注人工智能 关注一切促进人类生活美好的新技术

【微 信 号】 data_learner

文章摘要

【关 键 词】 阿里巴巴、开源、大语言模型、Qwen、模型发布

以下是加粗后的文本:

阿里巴巴开源了一系列名为Qwen的大语言模型,并在2023年8月首次公开了一个拥有70亿参数的版本。在接下来的几个月里,该公司陆续发布了四个不同规模的模型,包括一个最小规模为18亿参数和一个最大规模为720亿参数的版本。现在,阿里巴巴已经发布了他们第二代的Qwen系列大语言模型(或称为1.5代)。

Qwen2系列大模型包含了六个不同参数规模的版本,分别为5亿、18亿、40亿、70亿、140亿和720亿。每个版本的模型都提供了基础预训练版本、聊天优化版本、Int4量化、Int8量化以及AWQ版本,共计30个版本的模型。这些模型被官方称为Qwen2-beta版本,但在本次发布时更名为Qwen1.5。

Qwen1.5系列模型的特点包括:

1. 提供6个不同参数模型版本(0.5B, 1.8B, 4B, 7B, 14B 和 72B),最小的仅5亿参数,最大的有720亿参数;

2. 聊天优化版本的模型相比第一代模型有明显进步,其中720亿参数的Qwen1.5-72B在MT-Bench得分仅次于GPT-4;

3. 基座版本和聊天版本在多语言方面的能力得到增强,包括中英文在内,共支持12种语言;

4. 所有版本模型最高支持32K的长上下文输入;

5. 支持系统提示,可以完成Roleplay;

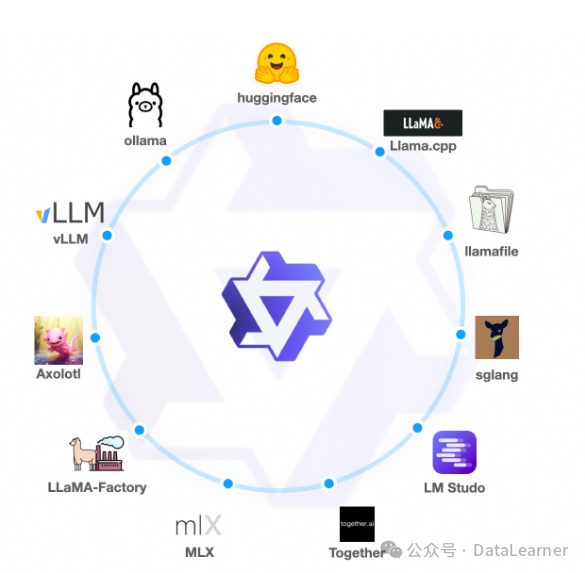

6. 生态完善,发布即支持vLLM、SGLang等推理加速框架;

7. 支持不同的量化框架;

8. 月活1亿以下直接商用授权,月活1亿以上商用需要获取授权。

官方公布的Qwen1.5系列模型在不同评测结果上的得分情况显示,Qwen1.5模型具有竞争力。然而,与第一代相比,72B模型的提升并不高。此外,小规模版本的模型对比显示,40亿参数规模的Qwen1.5-4B最强,但其参数规模也相对较高。

Qwen1.5最亮眼的表现是在MT-Bench上的得分,其中Qwen1.5-72B模型的MT-Bench得分8.61,仅次于GPT-4模型。

在实际测试中,Qwen1.5-72B模型在一些问题上表现不佳,这可能是因为这些问题本身就具有挑战性。尽管如此,该模型在其他任务中的表现仍然可圈可点。

Qwen2系列模型的开源地址如下:

– Qwen1.5-0.5B-Chat: https://www.datalearner.com/ai-models/pretrained-models/Qwen1_5-0_5B-Chat

– Qwen1.5-1.8B-Chat: https://www.datalearner.com/ai-models/pretrained-models/Qwen1_5-1_8B-Chat

– Qwen1.5-4B-Chat: https://www.datalearner.com/ai-models/pretrained-models/Qwen1_5-4B-Chat

– Qwen1.5-7B-Chat: https://www.datalearner.com/ai-models/pretrained-models/Qwen1_5-7B-Chat

– Qwen1.5-14B-Chat: https://www.datalearner.com/ai-models/pretrained-models/Qwen1_5-14B-Chat

– Qwen1.5-72B-Chat: https://www.datalearner.com/ai-models/pretrained-models/Qwen1_5-72B-Chat

原文信息

【原文链接】 阅读原文

【原文字数】 1334

【阅读时长】 5分钟