文章摘要

【关 键 词】 微软研究院、phi-4模型、基准测试、合成数据、预训练优化

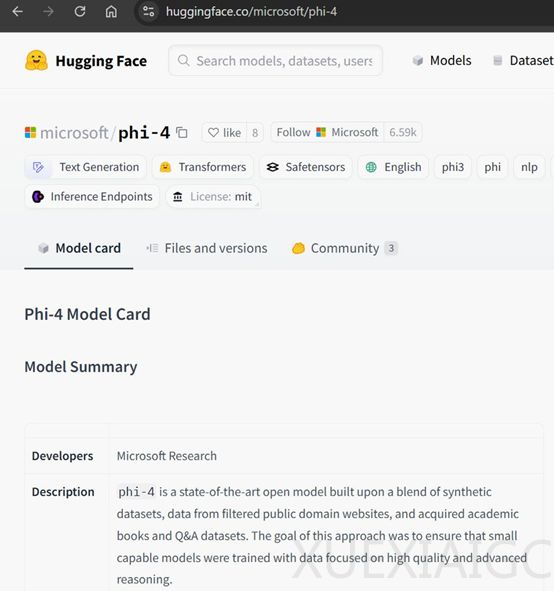

微软研究院近日开源了一款名为phi-4的小参数模型,该模型以其140亿参数的规模在多项基准测试中超越了包括OpenAI的GPT-4o在内的多个知名开闭源模型。phi-4在GPQA研究生水平和MATH数学基准测试中表现尤为突出,甚至在AMC美国数学竞赛测试中达到了91.8分,接近4050亿参数的Llama-3.1模型。该模型的开源地址为https://huggingface.co/microsoft/phi-4/tree/main,支持MIT许可证下的商业用途。

phi-4的成功归功于其高质量的合成数据,这些数据提供了结构化、逐步的学习材料,使模型能更高效地学习语言逻辑与推理过程。合成数据与模型的推理上下文对齐,更接近实际应用中需要生成的输出格式。phi-4的合成数据生成遵循多样性、细腻性与复杂性、准确性和推理链等原则,涵盖了50多种不同类型的数据集,生成了约4000亿个未加权的tokens。

除了合成数据,phi-4还对有机数据进行了严格的筛选与过滤,从网络内容、授权书籍和代码库等多渠道收集数据,提取出具有高教育价值和推理深度的种子数据。这些种子数据为合成数据的生成提供了基础,同时也直接用于预训练,进一步丰富了模型的知识储备。

在预训练方面,phi-4主要使用合成数据进行训练,同时辅以少量的高质量有机数据。这种数据混合策略使得模型在学习能力的同时,也能吸收丰富的知识内容。在中期训练阶段,phi-4将上下文长度从4096扩展到16384,以提高模型对长文本的处理能力。后训练阶段,微软采用了监督微调(SFT)和直接偏好优化(DPO)技术,以及关键tokens搜索(PTS)技术来优化模型。

微软在多个基准测试上评估了phi-4的性能,包括MMLU、GPQA、MATH、HumanEval等学术基准测试,phi-4均表现出色。在MMLU测试中,phi-4取得了84.8的高分,在GPQA和MATH测试中超越了GPT-4o,在数学竞赛相关任务中展现出强大的推理能力。在与其他类似规模和更大规模的模型比较中,phi-4在12个基准测试中的9个上优于同类开源模型Qwen-2.5-14B-Instruct。

原文和模型

【原文链接】 阅读原文 [ 1443字 | 6分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆