文章摘要

【关 键 词】 多模态模型、图像视频、性能优化、OCR能力、多语言支持

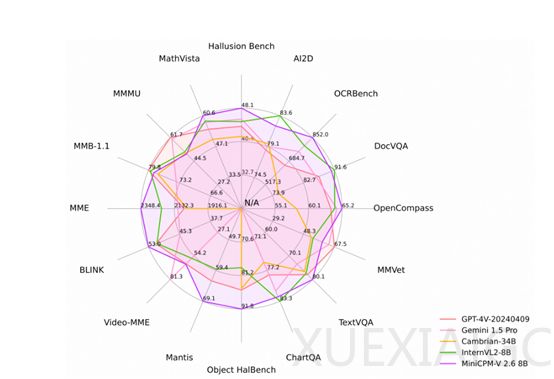

国内开源社区OpenBMB推出了一款新型的多模态大模型——MiniCPM-V 2.6,该模型拥有80亿参数,在图像和视频理解方面表现出色,超越了包括GPT-4V在内的多个知名模型。MiniCPM-V 2.6在单图像理解上优于GPT-4o mini、Gemini 1.5 Pro和Claude 3.5 Sonnet,并在多图像和视频理解方面展现了其特色功能。模型在减少内存占用和提高推理效率方面取得了显著成果,支持iPad等端侧设备进行实时视频理解。

MiniCPM-V 2.6的开发基于SigLip-400M和阿里的Qwen2-7B模型,相较于前一版本V 2.5,性能有了大幅提升。在OpenCompass上的平均得分达到65.2,在8个流行基准测试中表现优异。模型在多图像理解和上下文学习能力方面达到了领先水平,同时在视频理解能力上,无论有无字幕,均优于GPT-4V、Claude 3.5 Sonnet和LLaVA-NEXT-Video-34B。

此外,MiniCPM-V 2.6在OCR任务上展现了强大的能力,能够准确识别和转录图像中的文字,尤其在处理高达180万像素的图像时,其OCRBench得分超越了多个专有模型。在可信行为方面,基于最新的RLAIF-V和VisCPM技术,减少了幻觉的产生,提高了模型的可信度。

MiniCPM-V 2.6支持多种语言,包括英语、中文、德语、法语、意大利语、韩语等,增强了对不同语种的识别和生成能力。模型的推理效率极高,处理180万像素的图像时仅产生640个token,比大多数模型少75%,显著提升了推理效率、首token延迟、内存使用和功耗。此外,模型易于扩展,支持在本地设备上进行高效的CPU推理,并提供量化模型和支持vLLM进行高吞吐量和内存高效的推理。

MiniCPM-V 2.6在Github上的评分已超过9000颗星,成为开源多模态中性能优秀的模型之一。模型的开源地址为https://github.com/OpenBMB/MiniCPM-V,同时提供了在线demo:https://huggingface.co/spaces/openbmb/MiniCPM-V-2_6,供开发者和研究者进一步探索和应用。

原文和模型

【原文链接】 阅读原文 [ 979字 | 4分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆