文章摘要

【关 键 词】 AI原理、机制解释、稀疏编码、开源工具、模型控制

谷歌DeepMind团队正在探索一种名为“机制可解释性”的新方法,旨在揭示人工智能(AI)背后的工作原理。该团队发布了一个名为Gemma Scope的工具,帮助研究人员理解AI在生成输出时的内部过程,以便更有效地控制模型输出,并开发更好的AI系统。机械可解释性(mech interp)是一个新兴研究领域,旨在揭示神经网络的实际工作原理。AI通过在数据中寻找模式并根据模型得出结论,但这些模式可能非常复杂,通常以人类无法解读的形式存在。

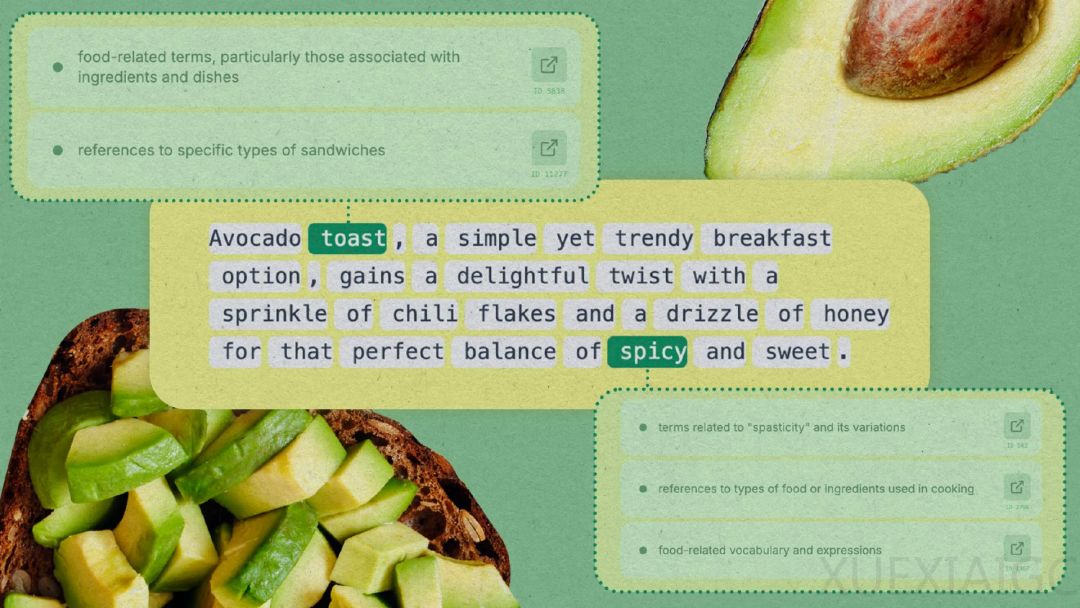

为了在AI模型Gemma中找到能代表更大概念的特征或数据类别,DeepMind在其每一层上都运行了一种名为“稀疏自动编码器”的工具。这种工具可以限制神经元的使用数量,更有效地展示数据。DeepMind通过运行不同精细度的稀疏自动编码器,改变其能找到的特征数量。Gemma和自动编码器都是开源的,目的是鼓励研究者探索稀疏自动编码器的发现,从而对模型的内部逻辑有新的见解。

Neuronpedia平台与DeepMind合作制作了一个体验版demo,可以在demo中测试不同的prompt,看看模型是如何对prompt进行分解,触发了哪些特征。稀疏自动编码器的一个有趣之处在于它是无监督的,这意味着它会自己发现特征,让我们对模型分解人类概念方面能有惊人的发现。

尽管机制可解释性研究还不能让我们更深入地了解AI出错的原因,但它在减少模型中的偏见、处理用户询问危险问题等方面具有潜在应用。如果模型的创建者能够找到AI中某些知识的所在,理论上他们就可以永久关闭这些节点。然而,这种细粒度和精确的控制在目前的机制可解释研究中极难实现。尽管如此,如果我们能更深入且清晰地窥探AI的“思想”,DeepMind和其他公司或许能让机制可解释性成为通向一致性的成功途径,确保AI能确实进行我们希望它做到的事。

原文和模型

【原文链接】 阅读原文 [ 2836字 | 12分钟 ]

【原文作者】 AI前线

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆