文章摘要

【关 键 词】 Transformer、生成式AI、表示崩塌、过度压缩、解决方案

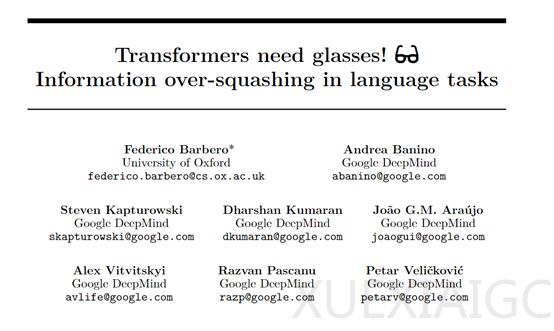

Transformer架构的出现极大地推动了生成式AI的发展,催生了诸如ChatGPT、Copilot、讯飞星火、文心一言和Midjourney等知名产品。然而,尽管Transformer架构在自然语言处理等领域取得了显著成就,它仍然存在一些关键问题,特别是在需要计数或复制输入序列元素的任务中表现不佳。这些操作是推理的基本组件,对于解决日常任务至关重要。为了解决这些问题,谷歌DeepMind和牛津大学的研究人员深入研究了Transformer架构中的“表示崩塌”和“过度压缩”两大难题,并提出了相应的解决方案。

表示崩塌是指在某些情况下,输入给大模型的不同序列在经过处理后,会生成非常相似甚至几乎相同的表示,导致模型无法具体区分它们。这种现象的出现与Transformer架构中的自注意力机制和位置编码设计密切相关。随着序列的增长,信息的表示越来越集中,从而导致信息的损失。为了验证这一现象,研究人员在Gemma 7B大语言模型中进行了实验,发现随着序列长度的增加,两组序列的表示差异逐渐减小,直至低于机器的浮点精度,模型无法精准区分这两个序列。

过度压缩现象与表示崩塌密切相关,表现为早期输入的token在模型的最终表示中的影响力减弱,特别是当这些token距离序列的末尾较远时。由于Transformer模型的自注意力机制和层叠结构,数据在每一层都会经过多次的压缩和重新分配,这可能导致一些重要的信息在传播过程中被稀释或变得非常不明显。研究人员在Gemini 1.5和Gemma 7B模型中进行了复制和计数任务实验,结果显示,当序列长度增加时,模型在复制序列末尾的token时表现不佳,而在复制序列开始的token时表现较好,这验证了过度压缩现象的存在。

为了解决这两大难题,研究人员提出了五种解决方案。改进注意力机制是最直接的方法,通过调整注意力权重的分配,增强模型对序列中早期token的关注。改进位置编码是另一种方法,通过使用相对位置编码或可学习的动态位置编码,帮助模型更好地保持序列中各个token的独特性。增加大模型深度和宽度可以提供更多的参数来学习复杂的表示,但这对AI算力的需求非常大。使用正则化方法,如权重衰减,可以帮助模型避免过拟合,减少表示崩溃现象。引入外部记忆组件,如差分记忆或指针网络,可以帮助模型存储和检索长序列中的信息,保持关键信息的活跃度。

为了验证这些方法的有效性,研究人员在谷歌的Gemini 1.5和Gemma 7B大语言模型中进行了综合评测。结果显示,改进注意力机制和引入外部记忆组件等方法,确实能有效缓解表示崩塌和过度压缩这两大难题。这些研究为Transformer架构的进一步优化提供了重要的理论支持和实践指导。

原文和模型

【原文链接】 阅读原文 [ 1397字 | 6分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek-v3

【摘要评分】 ★★★☆☆