被忽略的起点?Karpathy揭秘最初的注意力论文被Transformer光芒掩盖的故事

文章摘要

【关 键 词】 注意力机制、神经网络、深度学习、AI论文、技术创新

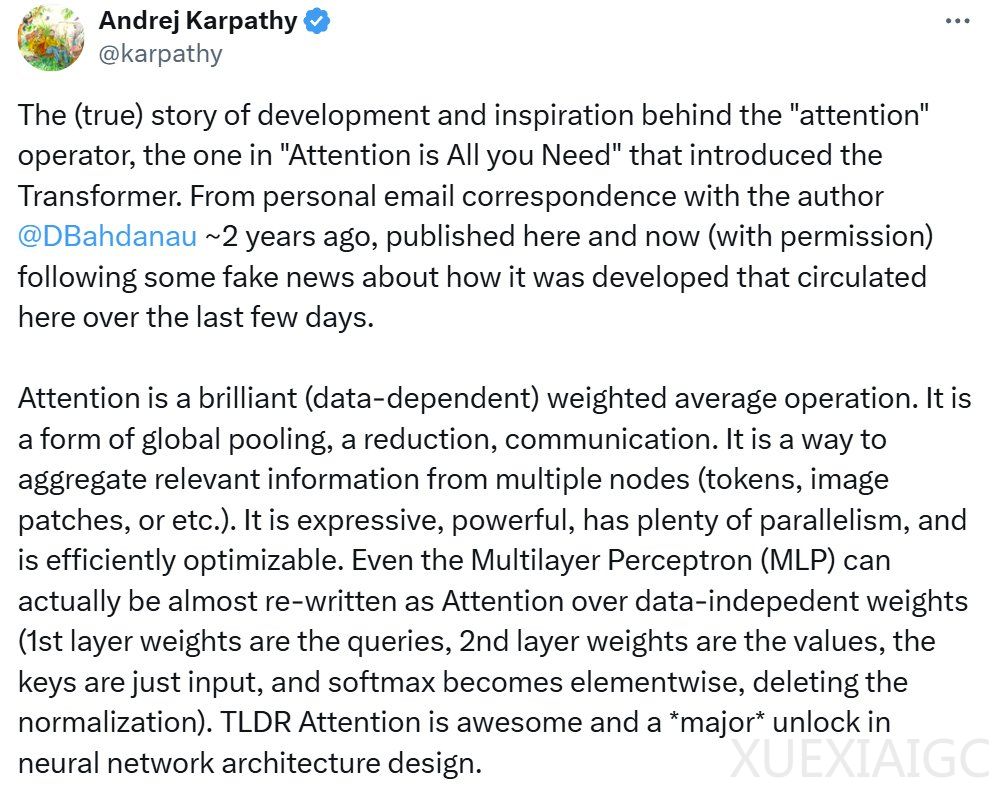

AI研究者Andrej Karpathy最近在推特上分享了注意力机制背后的故事,揭示了这一概念的起源和发展。他指出,Dzmitry Bahdanau、Kyunghyun Cho和Yoshua Bengio的论文《Neural Machine Translation by Jointly Learning to Align and Translate》实际上比著名的《Attention is All You Need》早三年提出了注意力机制,但并未获得相应的关注。Bahdanau在给Karpathy的邮件中详细描述了注意力机制的发现过程,包括其灵感来源和术语的创造者Yoshua Bengio。Karpathy强调,注意力机制是一种强大的数据依赖型加权平均运算,是神经网络架构设计的重大突破。

Karpathy的推文引起了广泛关注,许多读者对这一背后的故事表示兴趣。有人感叹2013-2017年间深度学习领域有许多隐藏的英雄,也有人分享了对注意力机制的看法。Hyperbolic Labs的创始人和CTO Yuchen Jin甚至调侃说,《Attention Is All You Need》的另一项贡献是影响了后来AI论文标题的命名方式。

Bahdanau的邮件中提到,他在Yoshua Bengio的实验室实习期间,受到启发提出了让解码器RNN学会在源序列中搜索放置光标位置的想法,这成为了后来的注意力机制。他将这种软性搜索表示为softmax,然后对BiRNN状态进行加权平均,效果显著。Bahdanau还提到,尽管他们的想法独立于其他类似机制,如神经图灵机和记忆网络,但他相信注意力机制是深度学习中实现灵活空间连接的自然方式。

Karpathy补充说,现代AI模型如ChatGPT的核心神奇之处在于反复应用注意力,一遍又一遍地关注输入的token,以预测下一个token是什么。他还分享了Bahdanau的原始邮件内容,以及相关论文的链接,供感兴趣的读者进一步探索。

原文和模型

【原文链接】 阅读原文 [ 2669字 | 11分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆