文章摘要

【关 键 词】 GPU短缺、AI服务器、NVIDIA、云服务、半导体市场

NVIDIA的GPU需求自2022年11月30日美国Open AI发布ChatGPT以来显著增加,导致全球范围内的GPU短缺,这一现象被称为NVIDIA的“GPU节”。尽管台积电增加了中制程产能,SK海力士等DRAM制造商也提高了HBM产量,但预计到2024年,高端AI服务器的出货量仅占所有服务器的3.9%,无法满足谷歌、亚马逊、微软等云服务提供商的需求。因此,NVIDIA的“GPU节”还远未结束,全面的生成式AI热潮即将到来。

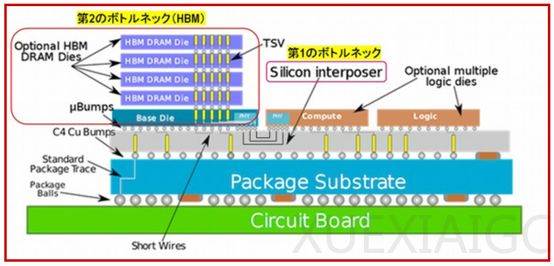

NVIDIA GPU生产的两个瓶颈是台积电的中制程和高带宽内存(HBM)与DRAM堆叠。台积电的硅中介层产能从每月15000片翻倍至超过30000片,三星电子和美光科技也开始供应尖端HBM,导致NVIDIA H100的交货时间从52周缩短至20周。

AI服务器分为两类:通用AI服务器和高端AI服务器。通用AI服务器配备两个或多个AI加速器但未配备HBM,而高端AI服务器至少配备四个搭载HBM的AI加速器。ChatGPT级别的生成式AI需要大量高端AI服务器。预计2022年至2024年,通用AI服务器的出货量分别为34.4万台、47万台和72.5万台,而高端AI服务器的出货量分别为3.4万台、20万台和56.4万台。

ChatGPT的开发和运营需要30,000台NVIDIA DGX H100高端AI服务器,总投资达到138亿美元。2022年高端AI服务器出货量为3.4万台,仅能构建一套ChatGPT级AI系统。2023年出货量达到20万台,可以构建6到7个ChatGPT级AI系统。预计2024年将出货56.4万台高端AI服务器,有可能构建18至19个ChatGPT级AI系统。

最终用户中,2023年微软拥有最多的高端AI服务器数量,为6.3万台,但到2024年,谷歌将拥有最多的高端AI服务器。2024年排名前五的分别是谷歌、微软、超微、亚马逊和Meta,垄断了约80%的份额。

AI加速器方面,NVIDIA的GPU是最受欢迎的,2024年将达到33.6万台。谷歌的张量处理单元(TPU)排名第二,预计到2024年将达到13.8万台。AMD和亚马逊也在开发自己的人工智能加速器。

综上所述,NVIDIA的AI加速器出货量目前最多,但谷歌和亚马逊正在成为其强有力的竞争对手。预计到2030年,全球半导体市场规模将超过1万亿美元,其中计算和数据存储市场将成为最大的市场。数据中心市场预计将稳步增长,服务器和存储将分别增加一倍左右。因此,服务器用半导体(包括高端AI服务器)将占据全球市场最大份额,数据中心市场也将扩大。

原文和模型

【原文链接】 阅读原文 [ 2929字 | 12分钟 ]

【原文作者】 半导体行业观察

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★