文章摘要

【关 键 词】 MLPerf测试、英伟达芯片、性能提升、AI推理、能效竞争

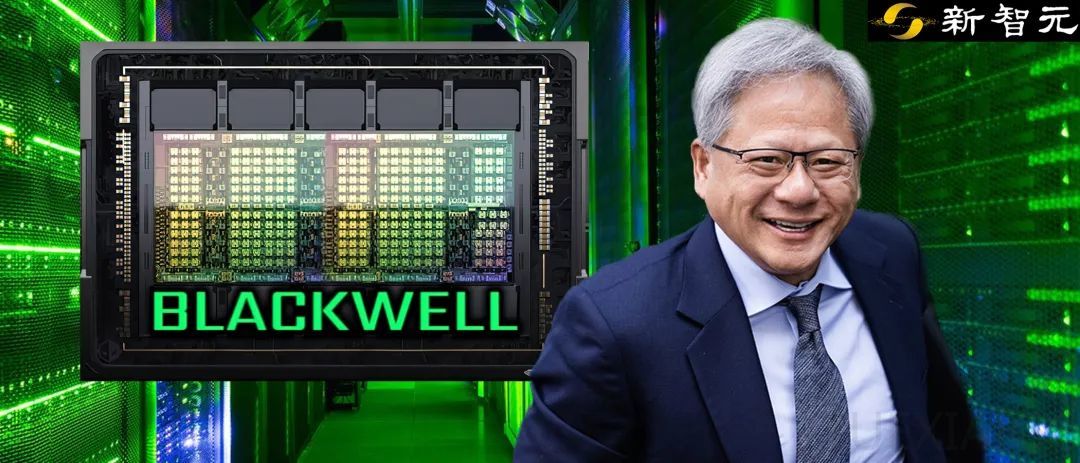

MLCommons发布了MLPerf Inference v4.1的最新测试结果,其中英伟达的Blackwell架构芯片在大语言模型(LLM)推理任务中表现出色,刷新了部分任务的测试纪录。MLPerf是一个广泛认可的测试套件,提供机器学习系统性能基准测试,每年更新两次。此次测试涵盖了专家混合(MoE)模型架构的首次评测,以及与推理功耗相关的新发现。

英伟达Blackwell架构的B200加速器在Llama 2 70B模型上实现了高达4倍的性能提升,相较于上一代的H100 GPU。此外,H200 GPU在数据中心工作负载上的性能提升高达1.5倍,得益于软件改进,性能提升高达27%。Blackwell架构的成功归因于使用4位浮点精度(FP4)运行模型,以及内存带宽的翻倍,达到8TB/s。Blackwell GPU支持多达18个NVLink连接,总带宽为1.8TB/s。

H200 GPU采用了业界最快的AI内存技术HBM3e,容量和带宽分别提高了1.8倍和1.4倍。在Llama 2 70B模型上,通过TensorRT-LLM的软件改进,性能比上一轮预览提交提高了多达14%。此外,英伟达还提交了使用H200 GPU运行Triton推理服务器的结果,表现与单机提交相似。

MLPerf新增了Mixtral 8x7B模型的工作负载,采用MoE架构,英伟达提交了H100和H200 GPU使用TensorRT-LLM软件以FP8精度运行的结果。在Stable Diffusion XL任务中,H200的性能提高到每秒生成两张图像,刷新了基准测试纪录。性能提升主要归功于软件栈的优化,包括UNet FP8支持、VAE INT8支持和变分自编码器(VAE)批分割。

Jetson AGX Orin在边缘推理任务中表现出巨大飞跃,通过软件优化,在GPT-J 6B模型的基准测试中,吞吐量提高了多达6.2倍,延迟改善了2.4倍。性能提升得益于TensorRT-LLM的多项软件优化,包括运行中批处理和INT4激活感知权重量化(AWQ)。

尽管英伟达GPU在AI训练方面仍具有主导地位,但AI推理领域的竞争日益激烈,特别是在能效方面。MLPerf设置了多个类别,包括数据中心封闭组和边缘组,测试大量查询处理能力和最小化延迟。数据中心组包含9个不同的基准测试,涵盖图像生成、LLM问答等任务。本轮比赛新增了「混合专家」基准测试,展示了LLM部署中的增长趋势。

在数据中心封闭组中,英伟达的H200 GPU和GH200超级芯片仍然是每个基准测试的获胜者。然而,性能结果表明,有些提交结果使用了多个芯片,有些则只使用了单个芯片。按每个加速器计算,英伟达的Blackwell在LLM问答任务上比所有以前的芯片高出2.5倍。Untether AI的speedAI240 Preview芯片在图像识别任务中几乎与H200的表现持平,展示了高能效推理方法。

AMD MI300X虽然在纸面参数上优于H100和H200,但在实际AI工作负载中并未实现对H100的超越,与H200相比落后约30-40%。Cerebras和Furiosa虽然没有参加MLPerf测试,但发布了新芯片,展示了在生成式AI方面的潜力。Cerebras的平台在每秒token生成上比H100快7倍,而Furiosa的第二代芯片RNGD在性能上与英伟达L40S相当,但功耗更低。

原文和模型

【原文链接】 阅读原文 [ 3058字 | 13分钟 ]

【原文作者】 新智元

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★