文章摘要

【关 键 词】 语言模型、长文本处理、RULER基准、性能评估

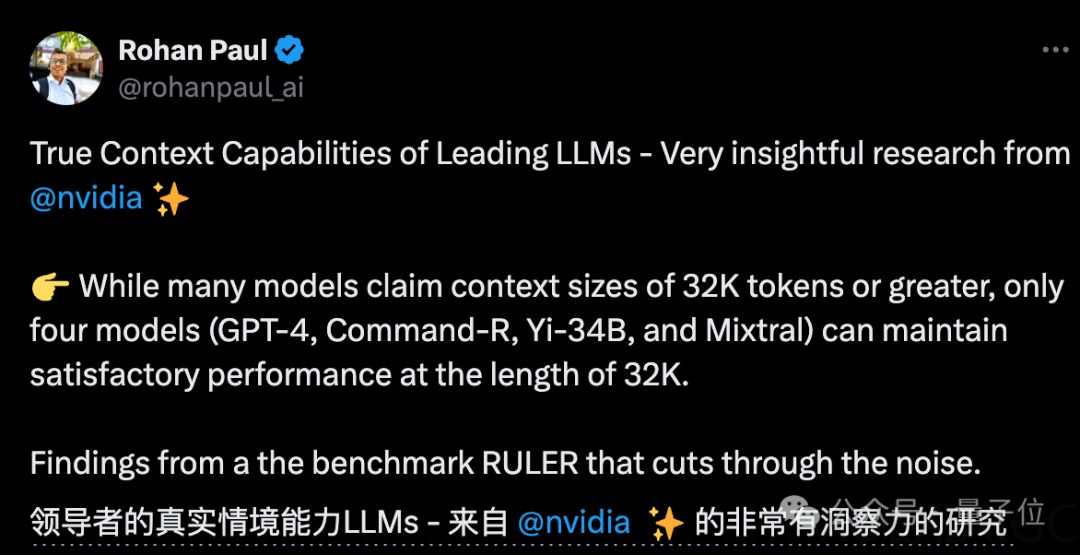

研究人员近日针对大型语言模型处理长文本的能力进行了深入探讨,并提出了名为RULER的新基准测试。该测试包含四大类共13项任务,旨在评估模型的“有效上下文”长度,即模型在保持与基线Llama-7B在4K长度下同等性能的最大长度。研究发现,尽管许多模型声称能够处理长达32K甚至1M的token,实际上在RULER测试中,大多数模型在声称的长度上并未能保持基线性能。

研究揭示了当前模型在长上下文处理上的虚标现象,其中英伟达的研究特别指出,包括GPT-4在内的10个大模型在“有效上下文”长度上存在显著缩水。在RULER测试中,GPT-4虽然在4K长度下表现最佳,但在上下文扩展到128K时性能下降了15.4%。而开源模型中Command-R、Yi-34B和Mixtral的表现较好,这些模型使用了较大的基频RoPE,且具有更多参数。

研究人员还对训练上下文长度、模型大小和架构对性能的影响进行了分析。他们发现,更大的上下文训练通常能带来更好的性能,模型大小的增加对长上下文建模有显著好处。非Transformer架构如RWKV和Mamba在RULER上的表现则显著落后于基于Transformer的Llama2-7B。

此外,研究还指出现有评测方法的不足,如ZeroSCROLLS、L-Eval、LongBench、InfiniteBench等,要么仅评估了模型检索能力,要么受到先验知识的干扰。RULER基准则减少了这种依赖,更专注于模型处理和理解长上下文的能力。

综上所述,该研究为评估大型语言模型的长文本理解能力提供了一个更为全面和严格的框架,有助于揭示模型的实际性能,并为未来的模型改进指明了方向。

原文和模型

【原文链接】 阅读原文 [ 2130字 | 9分钟 ]

【原文作者】 量子位

【摘要模型】 glm-4

【摘要评分】 ★★★★★