英伟达开源最新大模型Nemotron 70B后,只有OpenAI o1一个对手了

文章摘要

【关 键 词】 英伟达、开源、大型语言模型、基准测试、训练数据集

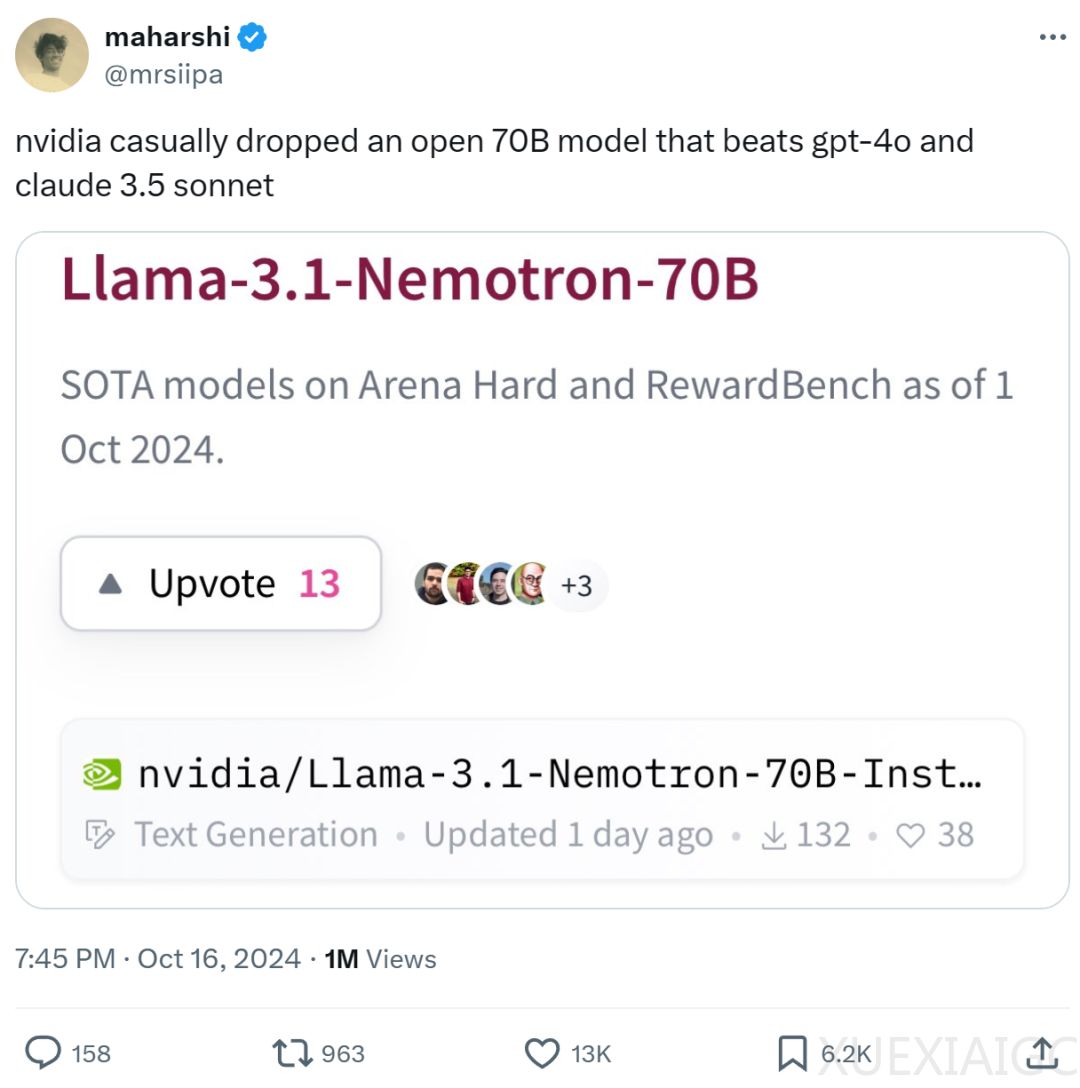

英伟达最近开源了一款名为Llama-3.1-Nemotron-70B-Instruct的大型语言模型,该模型在性能上超越了OpenAI的GPT-4o和Anthropic的Claude-3.5 sonnet等竞争对手。Llama-3.1-Nemotron-70B-Instruct基于Llama-3.1-70B构建,其性能在大模型榜单中仅次于OpenAI的最新o1大模型。该模型已开放在线体验,尽管在某些情况下可能会提供不准确的信息,如比较2.11和2.9的大小。英伟达强调,模型主要在通用领域进行了优化,尚未针对数学等专业领域进行调优。

此外,英伟达还开源了Nemotron的训练数据集HelpSteer2,包含21362个提示响应,旨在使模型更符合人类偏好,更有帮助、更符合事实、更连贯,并可根据复杂度和详细度进行定制。同时,还有20324个提示响应用于训练,1038个用于验证。

Llama-3.1-Nemotron-70B-Instruct是英伟达定制的大型语言模型,旨在提高LLM生成的响应的有用性。该模型在Arena Hard、AlpacaEval 2 LC和GPT-4-Turbo MT-Bench等基准测试中均排名第一,击败了GPT-4o和Claude 3.5 Sonnet等前沿模型。在训练细节上,该模型使用了RLHF技术(主要是REINFORCE算法),并采用了Llama-3.1-Nemotron-70B-Reward和HelpSteer2偏好提示作为初始训练策略。

英伟达还开源了另一个模型Llama-3.1-Nemotron-70B-Reward,用于预测LLM生成的响应的质量。该模型使用Llama-3.1-70B-Instruct Base进行训练,并结合了Bradley Terry和SteerLM回归奖励模型方法。Llama-3.1-Nemotron-70B-Reward在RewardBench榜单的Overall排名中表现最佳,并在Chat、Safety和Reasoning排名中也有出色表现。

要部署这些模型,需要至少一台带有4个40GB或2个80GB NVIDIA GPU的机器,以及150GB的可用磁盘空间。

原文和模型

【原文链接】 阅读原文 [ 816字 | 4分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★☆☆☆☆