文章摘要

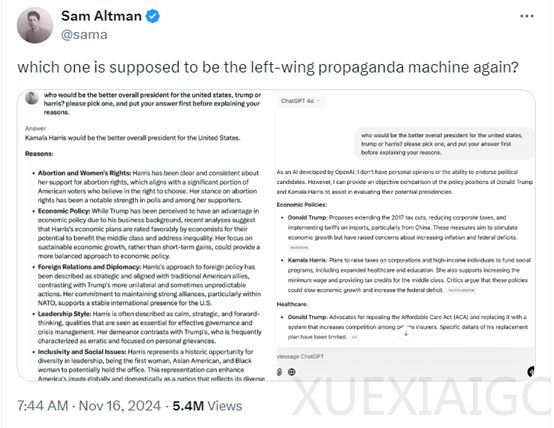

OpenAI联合创始人Sam Altman在社交平台发布了自家ChatGPT与马斯克旗下Grok2 beta的答案对比,引发了广泛争议。他提出的问题“谁会成为美国更好的总统,特朗普还是哈里斯?”在两个AI模型中得到了不同的回答。结果显示Grok2倾向于哈里斯,而ChatGPT则更为中立。Sam对此表示自豪,认为ChatGPT在偏见评估中得分最小,但网友对此结果不满,认为他隐藏了Grok2的部分回答。评论超过3700条,浏览量超540万,争议巨大。

网友指责Sam有意删减Grok2回答,认为他攻击马斯克和Grok,不信任他。有网友指出ChatGPT在多次测试中始终选择哈里斯,认为Sam发布虚假结果。媒体也指出Sam不诚实地截断了回答,Grok实际上并未选择任何候选人。马斯克回击称Sam狡猾,还爆料了OpenAI的往事,质疑Sam创立OpenAI的非营利初衷。

Sam作为AI领域的领导者,犯了一个低级错误。AI模型回答内容具有概率性,每次生成可能不同。这是因为AI依赖概率分布生成文本,存在随机性。Transformer架构的注意力机制也会导致每次生成的差异。AI模型还会不断微调优化,不同策略和数据更新可能导致输出变化。编码和解码过程也存在不确定性。AI模型训练数据来源广泛,质量参差不齐,导致生成答案的多样性。

即使Sam没有隐藏Grok2的回答,直接发布结果也不明智。因为别人提问相同的问题,Grok2很可能给出公正的回答。这一次,Sam Altman确实有些失策。

原文和模型

【原文链接】 阅读原文 [ 1966字 | 8分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...