模型信息

【模型公司】 月之暗面

【模型名称】 moonshot-v1-32k

【摘要评分】 ★★★★★

文章摘要

【关 键 词】 AIGC、Gemini、Sora、RAG、AI人格体

本文由Zilliz合伙人兼研发VP栾小凡撰写,讨论了AIGC(人工智能生成内容)技术的快速发展,特别是Gemini和OpenAI的Sora之间的技术竞争。文章首先指出,尽管Sora以其逼真的视觉效果吸引了公众的注意,但Gemini的技术报告和长上下文处理能力更值得关注。Gemini 1.5能够处理高达1000万token的超长上下文,支持与大量数据集的交互,如整本书籍、大型文档集等。

文章进一步探讨了Gemini 1.5在长上下文处理方面的能力,通过“大海捞针”测试展示了其在处理庞大数据集时的强大搜索功能。测试结果表明,Gemini 1.5 Pro在长文档中的信息检索准确率极高,即使在文档长度达到10M tokens时,仍能保持99.2%的准确率。这与GPT-4相比,后者在小于128k的上下文中表现优异,但处理更长上下文的能力有限。

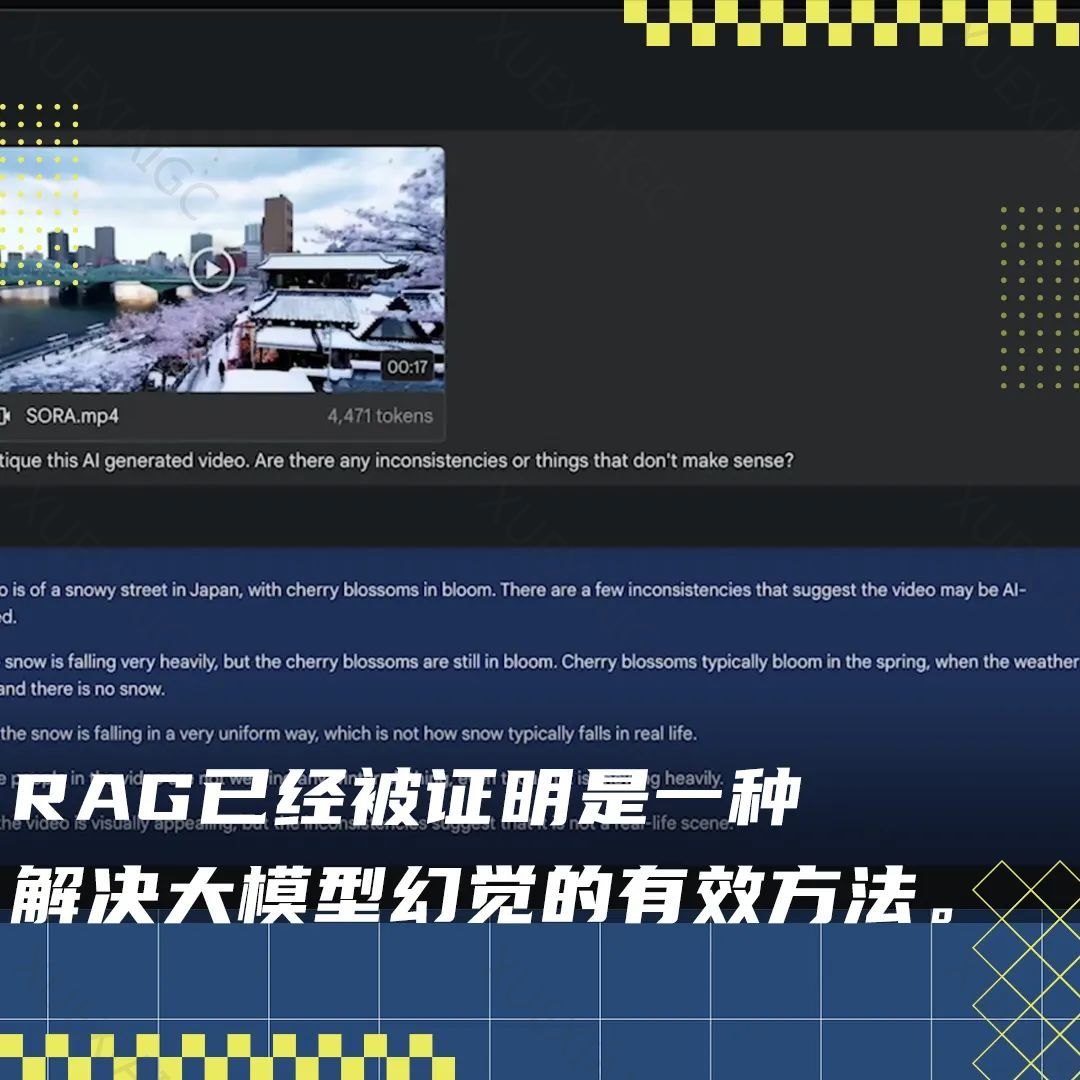

文章还讨论了RAG(检索增强生成)技术的发展,这是一种通过外部信息增强AI模型准确性和可靠性的方法。尽管有人认为RAG技术可能已经过时,但作者认为RAG技术仍在发展初期,并将随着大型模型处理长上下文能力的提升而持续迭代。

作者提出了提升RAG实战效果的三个方向:1) 提升长上下文的理解能力;2) 利用多路召回提升搜索质量;3) 使用复杂策略提升RAG能力。同时,文章指出,尽管大模型技术正在改变世界,但存储器、计算器和外存的分离仍然是必要的,RAG技术和向量数据库是实现查询质量和成本平衡的重要工具。

最后,文章提到了即将在北京举行的“AI人格体搭建赛”,这是一个旨在探索AI人格体创作可能性的活动,邀请AI开发者和技术爱好者参与。

原文信息

【原文链接】 阅读原文

【阅读预估】 3057 / 13分钟

【原文作者】 硅星人Pro

【作者简介】 硅(Si)是创造未来的基础,欢迎来到这个星球。