用AI短视频「反哺」长视频理解,腾讯MovieLLM框架瞄准电影级连续帧生成

模型信息

【模型公司】 OpenAI

【模型名称】 gpt-3.5-turbo-0125

【摘要评分】 ★★★☆☆

文章摘要

【关 键 词】 AI、生成框架、MovieLLM、长视频、数据生成

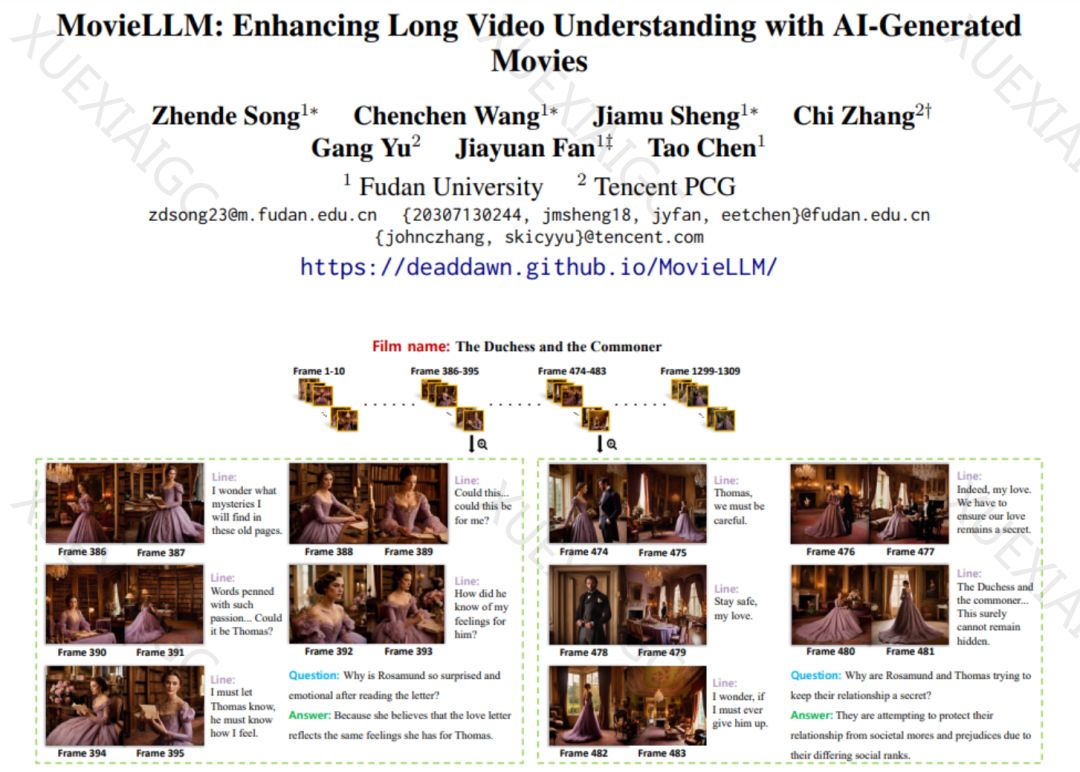

这篇文章介绍了腾讯和复旦大学研究团队提出的创新性AI生成框架MovieLLM,旨在解决长视频理解的挑战。长视频的分析与理解一直是一个难题,因为缺乏高质量、多样化的长视频数据资源。MovieLLM结合了GPT-4和扩散模型的生成能力,通过创造高质量、多样性的视频数据和问答数据集,极大地丰富了数据维度和深度。该框架包括电影情节生成、风格固定过程和视频指令数据生成三个阶段,通过这些步骤生成了高质量、风格多样的电影连续帧和对应的问答对数据。实验结果表明,MovieLLM显著提高了模型处理长视频内容的理解能力,并在短视频基准上也取得了性能提升。总体而言,MovieLLM的数据生成工作流程降低了为模型生成电影级视频数据的难度,提高了生成内容的控制性和多样性,同时增强了模型对长视频的理解能力,为其他领域提供了宝贵的参考。

原文信息

【原文链接】 阅读原文

【阅读预估】 1266 / 6分钟

【原文作者】 机器之心

【作者简介】 专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...