模型信息

【模型公司】 月之暗面

【模型名称】 moonshot-v1-32k

【摘要评分】 ★★★★★

文章摘要

【关 键 词】 达观大模型、曹植MoE、GPT-4、MoE架构、LLMP

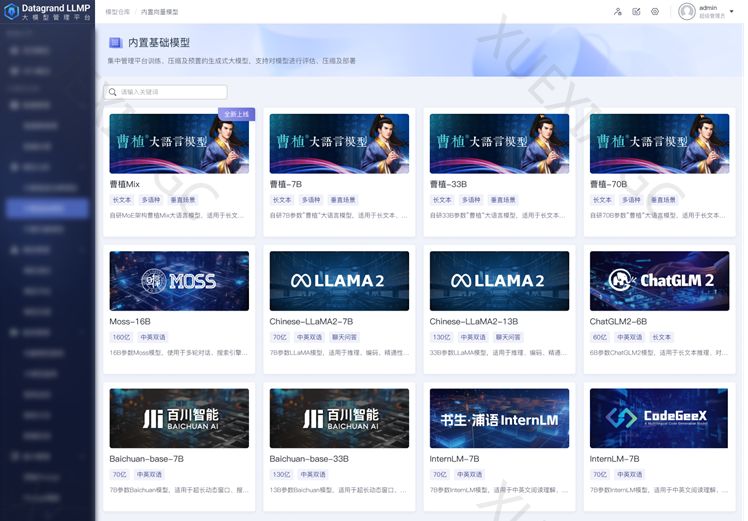

达观大模型管理平台(DATAGRAND)推出了支持中文的曹植MoE模型,以满足用户多样化的模型管理需求。曹植MoE模型具有更大的参数量级(70B),并支持私有化部署和一键训练。用户可以对模型进行SFT微调、模型量化、封装服务接口、Prompt指令定制等运维流程。曹植MoE模型在中文场景进行了优化,使其在长文本、多语种和垂直场景中具有更优的性能。

GPT-4架构引发猜想

GPT-4自问世以来,其强大的涌现能力备受关注。据黑客George Hotz透露,GPT-4是一个由8个专家模型组成的混合模型,每个专家模型有2200亿参数,总共有1.76万亿参数。这些子模型针对不同数据和任务分布进行了训练。

MoE架构的优势

MoE(Mixture of Experts)架构通过组合多个中等规模的模型,达到更大模型的效果。MoE架构的核心思想是将模型分为若干个专家模块,由门控机制动态选择哪个专家模块负责当前输入数据。这种结构有效减少了模型的参数规模,提高了灵活性和泛化能力。MoE架构具有可扩展性、高效计算、并行计算和减少训练时间等优势。

LLMP实现曹植MoE模型全流运维实践

达观大模型管理平台LLMP为用户提供了一站式的模型管理解决方案,包括数据集管理、模型SFT微调、服务封装上线、Prompt指令自定义等。平台支持零门槛优化、灵活的模型训练、手把手式引导和定制化服务,帮助用户轻松管理大语言模型。

原文信息

【原文链接】 阅读原文

【阅读预估】 2434 / 10分钟

【原文作者】 AIGC开放社区

【作者简介】 专注AIGC领域的专业社区,关注微软OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!