文章摘要

【关 键 词】 多模态理解、感知定位、图像编码、计算优化、技术应用

Groma通过区域性图像编码,提升多模态大模型的感知定位能力,使文本内容能与图像区域直接关联,增强对话的交互性和指向性。

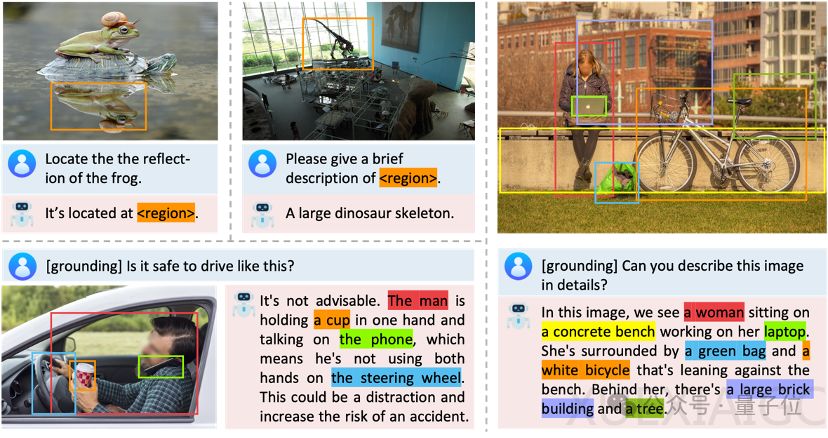

Groma的设计利用了vision tokenizer本身的空间理解能力,无需外接专家模型进行辅助定位。具体来说,Groma在全局图像编码基础上,引入Region Proposer定位潜在物体,通过Region Encoder将定位到的区域编码成region token。大语言模型根据region token进行语意判断,通过在输出中插入region token实现类似超链接的效果,从而进行visually grounded conversation。

为提升定位的鲁棒性和准确性,Groma采用了超过8M的数据进行预训练。分离式设计使得Groma可以采用高分辨率特征图进行Region Proposer/Encoder输入,同时采用低分辨率特征图用于大模型输入,降低计算量的同时保持定位性能。

实验结果显示,Groma在传统的Grounding Benchmarks上超越MiniGPT-v2和Qwen-VL,同时在VQA Benchmark (LLaVA-COCO)验证了其对话和推理能力。可视化对比中,Groma表现出更高的recall和更少的幻觉。此外,Groma还支持融合对话能力和定位能力的referential dialogue以及grounded chat。

Groma的意义在于把感知和认知解耦开来,vision tokenizer负责感知,大语言模型负责认知,这既符合人类的视觉过程,也避免了重新训练大语言模型的计算开销。字节跳动已将此技术应用于自研的豆包大模型,通过火山引擎开放给企业客户,助力企业提升效率、加速智能化创新。豆包APP成为中国市场用户量最大的AIGC应用,体现了字节跳动对顶尖人才和前沿技术的持续投入。相关项目网站、论文链接和开源代码已发布。

原文和模型

【原文链接】 阅读原文 [ 1617字 | 7分钟 ]

【原文作者】 量子位

【摘要模型】 glm-4

【摘要评分】 ★★★★☆