文章摘要

【关 键 词】 大模型、量化推理、硬件优化、开源框架、性能突破

王颖研究员团队联合华北电力大学和上海科技大学,在ASPLOS 2025会议上发布了COMET框架,该框架通过系统-算法协同优化,实现了权重、激活和KV缓存全4比特推理的实际性能突破。在LLaMA-70B等大模型上,COMET仅造成0.32的困惑度微增,同时实现2.02倍的端到端推理加速,创造了大模型量化推理技术领域的新标杆。COMET框架通过三大量化维度全破壁,将权重、激活、KV缓存全面压缩至4比特,精度损失仅0.32。

全球大模型军备竞赛已陷入“能耗地狱”,GPT-4单次训练耗电堪比5000户家庭年用电量,推理成本更是高居不下。传统量化技术如同“瘸腿赛跑”,权重量化(W4A16)虽然将权重压到4比特,但激活值仍用16比特计算,GPU算力浪费超70%。权重激活双量化(W8A8)为保精度牺牲性能,加速比仅1.3倍,长序列场景内存照样崩。COMET框架通过三大硬核创新,在4比特的极限压缩下实现近乎无损的推理性能。

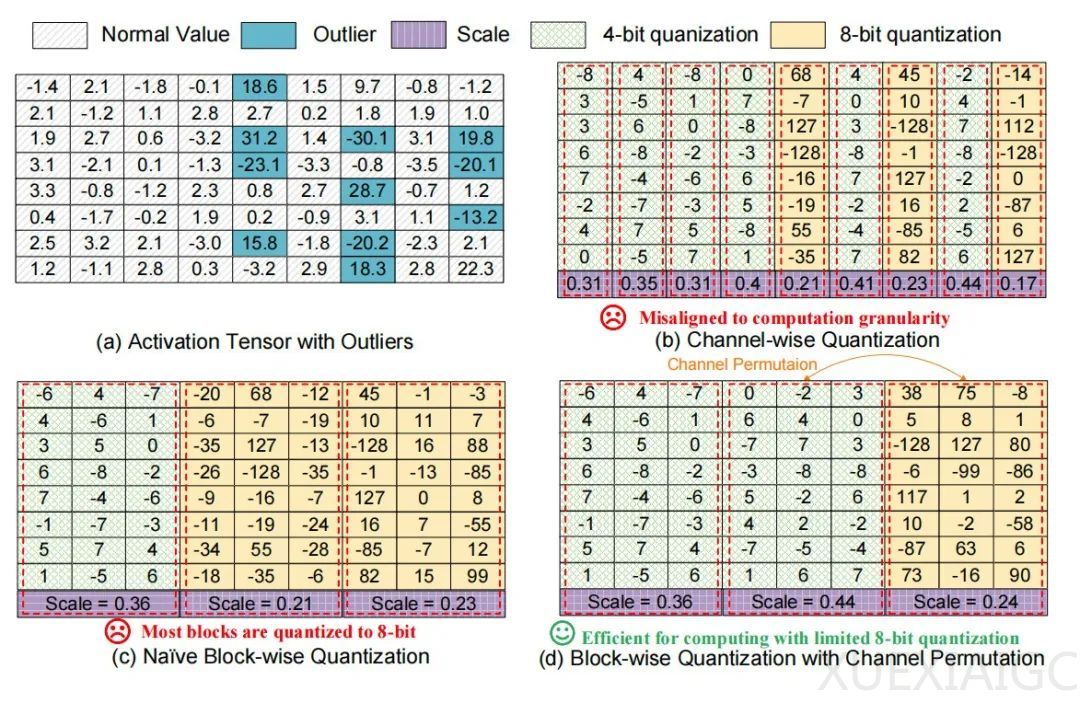

COMET框架从GPU底层架构出发,重新解构量化逻辑与计算内核优化,在三个关键维度实现突破。首先,通过对LLaMA等主流大模型的深入分析,研究团队首次发现激活中的异常值并非随机分布,而是高度集中在约10%的特定通道中。这一关键发现为提出的细粒度混合精度量化算法(FMPQ)的设计奠定了基础。FMPQ算法通过硬件友好的分块方式,将激活张量按128通道划分,使其天然适配现代GPU张量核心的64×64×32计算结构,从而确保量化操作与底层执行单元高度对齐。同时,算法引入了动态精度调控机制,将8比特高精度分配给异常值密集的“重点区域”,而其余部分则压缩为4比特,在保证模型精度的前提下显著提升运算效率。

在实际部署中,W4A4与W4A8混合精度计算往往会带来计算负载的不均衡,成为系统性能的瓶颈。为此,研究团队构建了一套三层异步流水线架构,以最大化GPU资源的利用率。整个架构设计从数据传输和计算重叠入手,借助双缓冲机制,在数据预取的同时启动计算,有效隐藏了加载延迟,确保张量核心始终处于高效运行状态。同时,团队打破了传统“Tile一SM(Streaming Multiprocessor)”的固定分配策略,引入了更灵活的SM协作机制,使空闲的计算单元可以动态接管邻近任务,极大缓解了局部资源闲置的问题。

在4比特量化领域,真正的技术挑战并不在于量化本身,而在于数据转换的效率瓶颈。传统方法往往需要多达10条指令才能完成一次4比特到8比特的转换操作,严重制约了实际部署性能。为此,研究团队从底层硬件指令集出发,深入挖掘GPU的潜力,通过对数据存储格式和指令流的重构,将这一过程优化至只需两条指令即可完成。这种极简方案的核心在于两项关键突破:其一,团队充分利用GPU PTX指令的特性,使得打包在16位中的4个4比特数值可以被同时提取,极大提升了解包效率;其二,巧妙地用“零扩展”替代了传统的“符号扩展”策略,通过缩放参数的补偿机制,等价保持了整体精度表现的稳定性。

在4比特极致压缩的背景下,COMET框架通过细粒度混合精度量化技术,有效抑制了量化带来的精度损失。在实际测试中,LLaMA-7B模型在WikiText2数据集上的困惑度仅从5.68小幅上升至5.95,误差控制在5%以内,显示出高度鲁棒性。更具代表性的是,在LLaMA-3-70B这样的大模型上,困惑度提升更是被压缩至0.36,精度表现相比传统方案提升超过三倍。此外,COMET还对KV缓存结构进行了优化,首次将键值存储压缩至4比特,不仅将长序列场景下的内存占用削减了75%,同时额外引入的精度损失控制在0.05以内,几乎可以忽略。

而在性能层面,COMET同样展现出跨越性的突破。以A100 GPU为例,深度优化的COMET-W4Ax计算内核在适配LLaMA、Mistral、Qwen等主流模型时,实现了对cuBLAS内核2.75至2.97倍的加速。更重要的是,这种性能优势在端到端推理过程中得到了充分延续,在长序列任务中(如1024 token输入),整体吞吐量提升达到3.27倍,即使在短序列场景(128 token),也能获得1.63倍的增益。借助异步流水线与动态调度机制,GPU SM的利用率从原本的45%大幅提升至76%,极大释放了底层硬件的潜力。

目前,COMET-W4Ax的内核与接口已正式开源,开发者只需短短5行代码,即可将其集成至TensorRT-LLM框架,实现从压缩到加速的一体化部署,进一步推动大模型落地的普及与平民化。论文《COMET: Towards Practical W4A4KV4 LLMs Serving》已正式出版,详细介绍了研究成果,并提供了完整的框架开源代码地址。

原文和模型

【原文链接】 阅读原文 [ 1954字 | 8分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★☆