文章摘要

【关 键 词】 数学推理、模型弱点、Putnam-AXIOM、逻辑缺陷、自动化评估

斯坦福大学的研究揭示了大型语言模型(LLMs)在数学推理任务中的一个显著弱点:仅通过改变题目中的变量名称和取值范围,就能显著降低模型的准确率。这一发现表明,这些模型可能并未真正理解数学问题的逻辑,而是依赖于检索记忆中的题目。在Putnam-AXIOM测试集上,即使是表现最佳的模型o1-preview,其准确率也从50%骤降至33.96%,而其他模型如GPT-4o、Claude、Deepseek、Qwen等几乎全部失败。

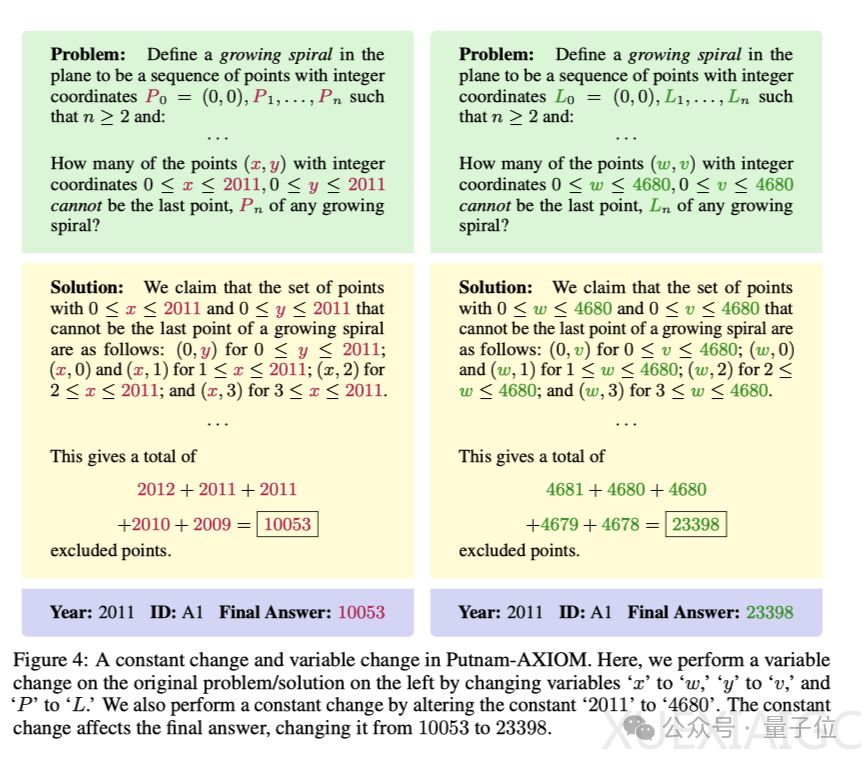

Putnam-AXIOM基准是为评估模型解决复杂数学问题能力而设计的全新测试集,它基于1985-2023年William Lowell Putnam数学竞赛的236个问题,覆盖11个不同的数学领域,并确保问题可以自动化评估。为了防止模型在训练过程中接触过评估基准中的问题,研究团队引入了功能变异构建变异数据集,包括变量变化和常数变化,以生成无限多相同难度的新问题。

实验结果显示,大多数模型在原始数据集上的准确率低于10%,而在变异数据集上,准确率进一步显著下降。例如,o1-preview在原始数据集上的准确率为50%,但在变异数据集中降至33.96%。这表明模型在原始问题上的表现可能依赖于记忆而非真正的推理能力。进一步分析发现,OpenAI的o1-preview和GPT-4o在逻辑推理和数学严谨性方面存在明显缺陷,如未能提供充分的证明和逻辑跳跃。

这项研究不仅指出了现有评估基准的不足,还提供了一个挑战性的新方法来评估模型的数学推理能力,并实现了完全自动化的评估。尽管变体数据集的生成过程复杂耗时,但优化变体生成方法将有助于加速人工推理的研究。

原文和模型

【原文链接】 阅读原文 [ 1373字 | 6分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆