攻陷短视频后,Sora将需要72万块H100 GPU

文章摘要

【关 键 词】 Sora模型、视频生成、扩散模型、计算成本、推理计算

以下是带有HTML标记的文本,其中重点词语和句子已用HTML元素标记出来:

机器之心报道了OpenAI推出的Sora模型,这是一个建立在扩散Transformers(DiT)和潜在扩散模型之上的视频生成模型,能够生成极其逼真的视频。Sora模型的推出引起了全球关注,其在视频生成的质量和能力方面取得了重大进展。然而,Sora模型的训练和推理成本都非常高,尤其是在推理阶段,成本将很快超过训练成本。

Sora模型的有效性在于扩大视频模型,类似于大语言模型(LLM),通过增加模型的规模来快速改进模型。目前,Runway、Genmo和Pika等公司正在围绕类Sora视频生成模型构建直观的界面和工作流程,这将决定它们的用途和可用性。Sora模型需要大量的计算能力来训练,至少需要在4200至10500块英伟达H100 GPU上训练一个月。在推理阶段,每个H100 GPU每小时最多可以生成约5分钟的视频。

随着类Sora模型的广泛部署,推理计算消耗将超过训练计算消耗。预计在生成1530万至3810万分钟的视频后,推理阶段的计算需求将超过原始训练。以TikTok和YouTube为例,每天上传的视频量分别为1700万分钟和4300万分钟。如果这些平台上大量采用人工智能进行视频生成,推理阶段的计算峰值需求可能约为72万块Nvidia H100 GPU。

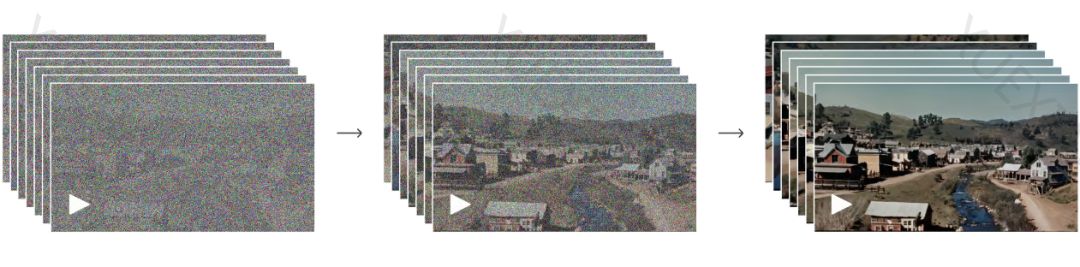

Sora模型的诞生背景是基于扩散模型,这是一种生成式机器学习模型,通过向数据中添加随机噪声并逐步反向学习来创建与训练数据相似的数据。扩散模型从噪声模式开始,逐步去除噪声并完善模型,最终输出详细且连贯的结果。这与LLM的工作方式不同,后者通过自回归采样逐个生成token。

Sora的技术细节受到《Scalable Diffusion Models with Transformers》研究论文的影响,采用了基于Transformer的架构。Sora模型的三个重要部分包括:1)在隐空间而非像素空间中执行扩散;2)使用Transformers架构;3)使用大型数据集。潜在扩散是Sora的关键技术之一,通过将像素映射到具有压缩系数的隐空间表征,然后在隐空间中执行扩散,最后将隐空间表征解码回像素空间,从而降低计算复杂度。

Sora模型的影响分析表明,视频模型开始变得真正有用,生成的视频质量足以应对某些场景并在现实世界中应用。然而,模型的可操控性仍然是一个挑战,需要直观的用户界面和工作流程。此外,Sora模型证明了模型缩放对视频模型有效,可以期待进一步的进展。Sora还可用于数据增强和仿真,帮助生成合成数据或将现有视频转换成不同外观。此外,Sora模型可能有助于学习世界模型,从而在真实世界的任务中大规模地训练具身智能体。

Sora的计算量估算显示,其训练计算量可能在1.1×10^25至2.7×10^25 FLOPS之间,相当于使用4211至10528台Nvidia H100 GPU进行一个月的训练。推理计算量与训练计算量的比较表明,在生成一定量的视频后,推理计算将超过训练计算。对于Sora、DiT-XL、LLama 2 70B和GPT-4等不同模型,Sora的推理计算成本要高出几个数量级。

最后,文章指出,随着生成式人工智能模型变得越来越流行且实用,推理计算将占主导地位。对于像Sora这样的基于扩散的模型,更是如此。扩展模型将进一步增加推理计算的需求,但可以通过优化的推理技术和跨堆栈的其他优化方法来解决部分问题。

原文和模型

【原文链接】 阅读原文 [ 5704字 | 23分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★